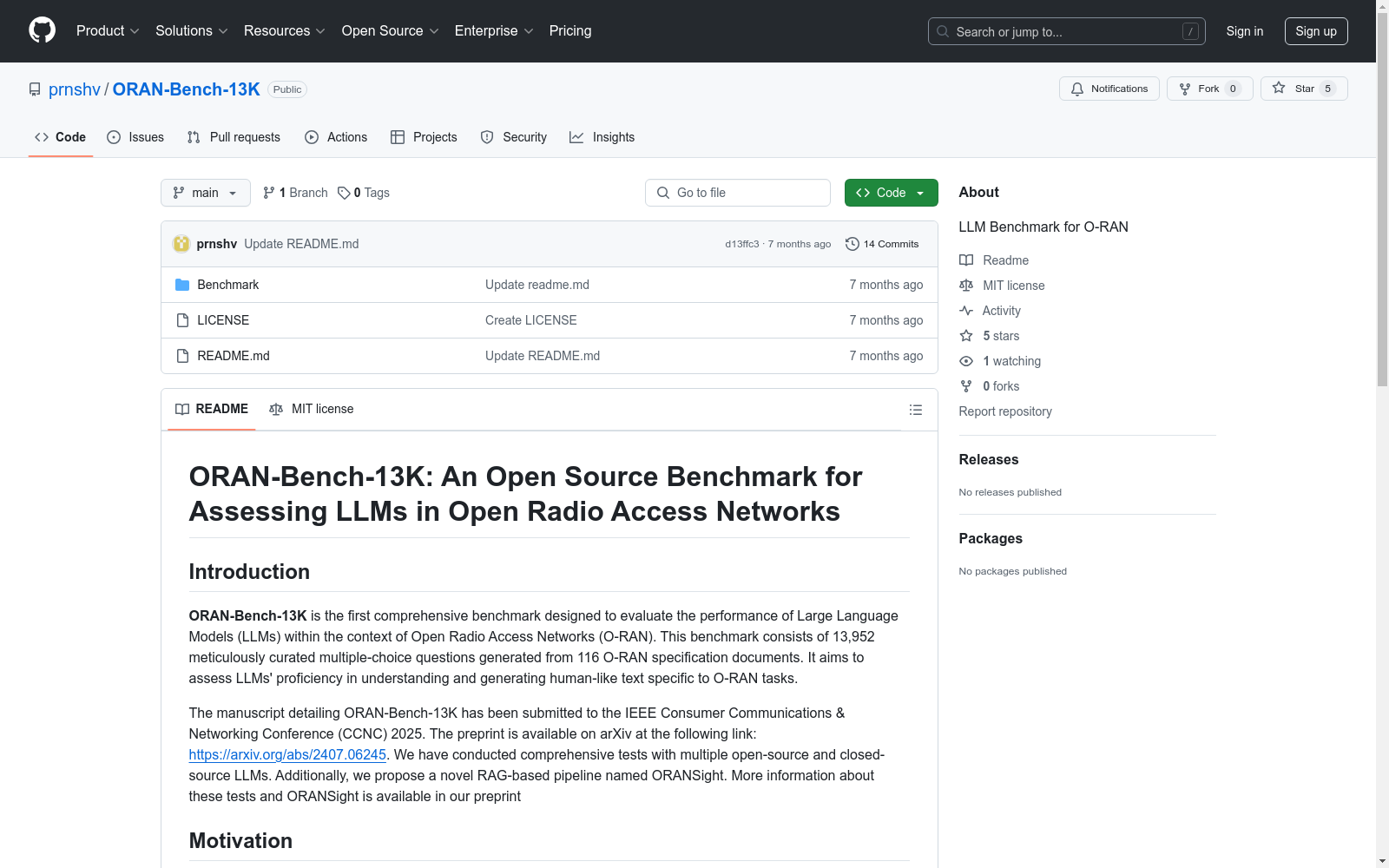

ORAN-Bench-13K|O-RAN数据集|大型语言模型评估数据集

收藏ORAN-Bench-13K: 评估大型语言模型在开放无线接入网络中的性能的开源基准

简介

ORAN-Bench-13K 是首个全面评估大型语言模型(LLMs)在开放无线接入网络(O-RAN)环境中性能的基准。该基准包含从116份O-RAN规范文档中精心挑选的13,952个多选题。它旨在评估LLMs在理解和生成特定于O-RAN任务的人类般文本方面的熟练程度。

动机

O-RAN技术的快速发展需要开发能够管理这些网络中复杂任务的复杂和智能系统。大型语言模型在各个领域显示出显著潜力,但尚未在O-RAN的特定环境中得到充分评估。ORAN-Bench-13K通过提供一个强大且全面的基准来填补这一空白,以评估LLMs在此关键领域的能力。

仓库结构

- MCQA: 该文件夹包含三个JSON文件(Fin_E.json, Fin_M.json, Fin_D.json),对应不同难度的多选题。

使用方法

要使用该基准,您可以加载Benchmark文件夹中的JSON文件,并将其集成到您的LLM评估框架中。每个文件包含一系列问题、选项和正确答案索引。

引用

如果您在研究中使用ORAN-Bench-13K,请按以下方式引用我们的工作:

bibtex @misc{gajjar2024oranbench13kopensourcebenchmark, title={ORAN-Bench-13K: An Open Source Benchmark for Assessing LLMs in Open Radio Access Networks}, author={Pranshav Gajjar and Vijay K. Shah}, year={2024}, eprint={2407.06245}, archivePrefix={arXiv}, primaryClass={cs.NI}, url={https://arxiv.org/abs/2407.06245}, }

贡献

我们欢迎对基准的扩展和改进做出贡献。如果您有建议或想添加新问题,请与我们联系。

许可证

本项目基于MIT许可证。更多详情请参见LICENSE文件。

- 1ORAN-Bench-13K: An Open Source Benchmark for Assessing LLMs in Open Radio Access Networks乔治梅森大学NextG无线实验室 · 2024年

PDT Dataset

PDT数据集是由山东计算机科学中心(国家超级计算济南中心)和齐鲁工业大学(山东省科学院)联合开发的无人机目标检测数据集,专门用于检测树木病虫害。该数据集包含高分辨率和低分辨率两种版本,共计5775张图像,涵盖了健康和受病虫害影响的松树图像。数据集的创建过程包括实地采集、数据预处理和人工标注,旨在为无人机在农业中的精准喷洒提供高精度的目标检测支持。PDT数据集的应用领域主要集中在农业无人机技术,旨在提高无人机在植物保护中的目标识别精度,解决传统检测模型在实际应用中的不足。

arXiv 收录

VisDrone2019

VisDrone2019数据集由AISKYEYE团队在天津大学机器学习和数据挖掘实验室收集,包含288个视频片段共261,908帧和10,209张静态图像。数据集覆盖了中国14个不同城市的城市和乡村环境,包括行人、车辆、自行车等多种目标,以及稀疏和拥挤场景。数据集使用不同型号的无人机在各种天气和光照条件下收集,手动标注了超过260万个目标边界框,并提供了场景可见性、对象类别和遮挡等重要属性。

github 收录

CMNEE(Chinese Military News Event Extraction dataset)

CMNEE(Chinese Military News Event Extraction dataset)是国防科技大学、东南大学和清华大学联合构建的一个大规模的、基于文档标注的开源中文军事新闻事件抽取数据集。该数据集包含17,000份文档和29,223个事件,所有事件均基于预定义的军事领域模式人工标注,包括8种事件类型和11种论元角色。数据集构建遵循两阶段多轮次标注策略,首先通过权威网站获取军事新闻文本并预处理,然后依据触发词字典进行预标注,经领域专家审核后形成事件模式。随后,通过人工分批、迭代标注并持续修正,直至满足既定质量标准。CMNEE作为首个专注于军事领域文档级事件抽取的数据集,对推动相关研究具有显著意义。

github 收录

IMF International Financial Statistics (IFS)

国际货币基金组织(IMF)的国际金融统计(IFS)数据集提供了全球各国的金融和经济数据,包括货币供应、利率、国际收支、国际储备等。该数据集是研究国际金融和经济趋势的重要资源。

www.imf.org 收录

AISHELL/AISHELL-1

Aishell是一个开源的中文普通话语音语料库,由北京壳壳科技有限公司发布。数据集包含了来自中国不同口音地区的400人的录音,录音在安静的室内环境中使用高保真麦克风进行,并下采样至16kHz。通过专业的语音标注和严格的质量检查,手动转录的准确率超过95%。该数据集免费供学术使用,旨在为语音识别领域的新研究人员提供适量的数据。

hugging_face 收录