PreCT-160K|医学影像数据集|数据分析数据集

收藏github2024-10-15 更新2024-10-16 收录

下载链接:

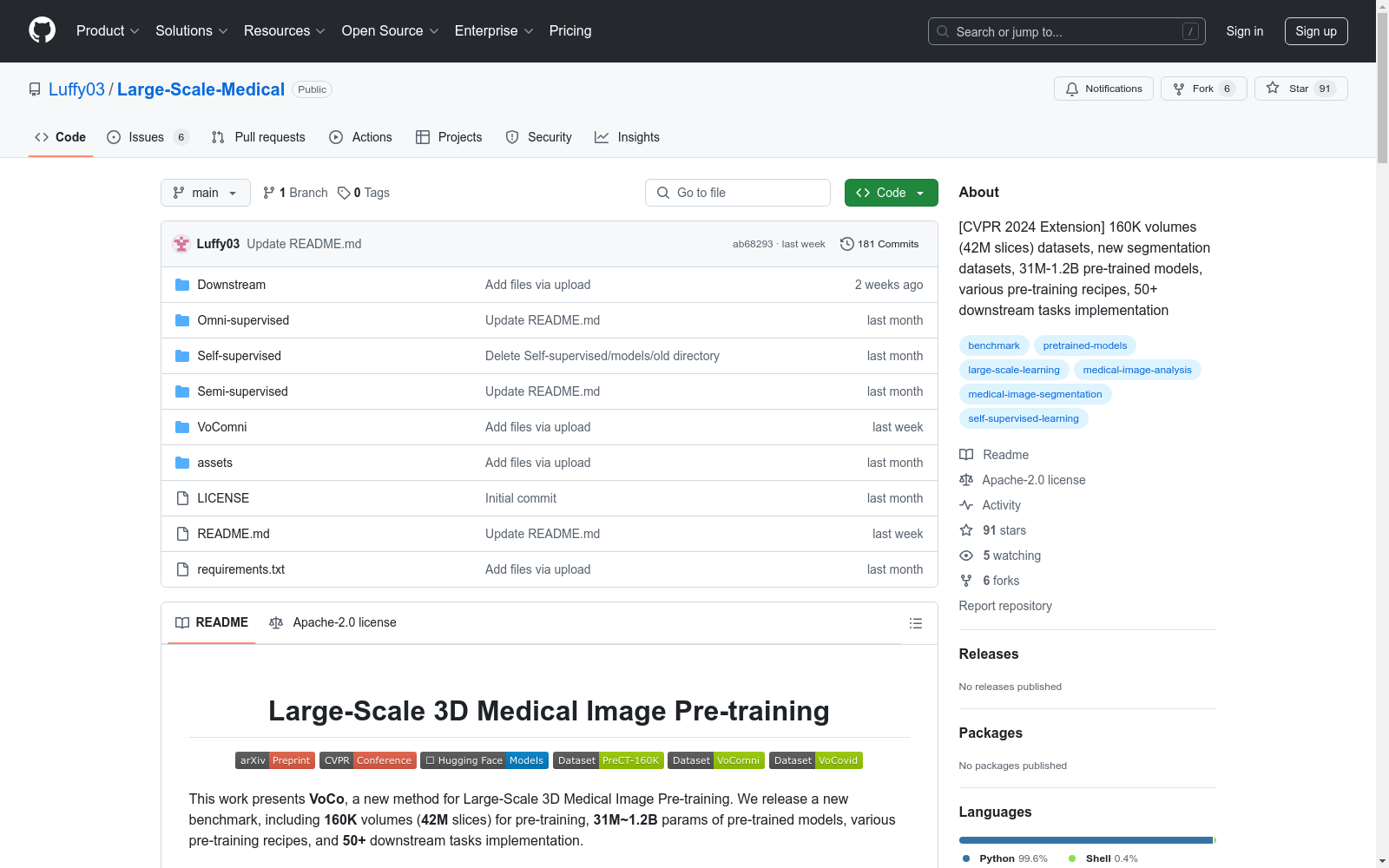

https://github.com/Luffy03/Large-Scale-Medical

下载链接

链接失效反馈资源简介:

该数据集是该领域中现有的最大数据集,包含160K个CT体积(42M个切片)。

创建时间:

2024-10-08

原始信息汇总

Large-Scale 3D Medical Image Pre-training

数据集概述

- VoCo: 一种新的用于大规模3D医学图像预训练的方法。

- 数据集:

- PreCT-160K: 包含160K个CT体积(42M切片),是目前该领域最大的数据集。

- VoComni: 包含20K个带有伪标签的体积(20个器官和肿瘤类别)。

- VoCovid: 用于半监督的COVID-19分割。

预训练模型

- 模型参数范围: 31M~1.2B

- 模型列表:

- VoComni_nnunet: 31M参数

- VoCo_B_SSL_head: 53M参数

- VoCo_L_SSL_head: 206M参数

- VoCo_H_SSL_head: 818M参数

- VoComni_B: 72M参数

- VoComni_L: 290M参数

- VoComni_H: 1.2B参数

下游任务

- 任务数量: 50+

- 任务类型: 分割、分类、配准、视觉语言等

预训练方法

- Fully-supervised: 使用标记数据进行预训练

- Self-supervised: 使用未标记数据进行预训练

- Semi-supervised: 使用标记和未标记数据进行预训练

- Omni-supervised: 使用标记和未标记数据进行预训练

数据集下载

- PreCT-160K: 需要22.6 TB存储空间

- VoComni: 需要少于10 TB存储空间

- VoCovid: 可从Hugging Face下载

引用

bibtex @InProceedings{voco-v1, author = {Wu, Linshan and Zhuang, Jiaxin and Chen, Hao}, title = {VoCo: A Simple-yet-Effective Volume Contrastive Learning Framework for 3D Medical Image Analysis}, booktitle = {CVPR}, month = {June}, year = {2024}, pages = {22873-22882} }

AI搜集汇总

数据集介绍

构建方式

在医学影像分析领域,PreCT-160K数据集的构建基于大规模的3D医学图像预训练需求。该数据集包含了160,000个CT体积(共计4200万张切片),通过收集和处理来自多个公开数据源的医学影像数据,确保了数据集的多样性和广泛性。数据集的构建过程中,采用了多种预训练方法,包括全监督、自监督、半监督和全监督预训练,以适应不同的研究需求和应用场景。

使用方法

使用PreCT-160K数据集时,研究人员可以通过Hugging Face平台下载数据集和预训练模型。数据集的加载和使用方法在README文件中有详细说明,包括如何加载预训练模型、调整模型参数以及进行微调。为了确保数据集的高效使用,建议在SSD上存储数据,并根据实际需求选择合适的预训练方法和模型参数。此外,数据集还提供了多种下游任务的实现代码,方便研究人员直接应用于实际项目中。

背景与挑战

背景概述

在医学影像分析领域,三维医学图像的预训练技术近年来取得了显著进展。PreCT-160K数据集由Linshan Wu、Jiaxin Zhuang和Hao Chen等研究人员于2024年创建,旨在推动大规模三维医学图像预训练的发展。该数据集包含160,000个CT体积(共计4200万张切片),是目前该领域中最大的数据集之一。其核心研究问题是如何利用几何上下文先验进行有效的三维医学图像预训练,从而提升下游任务的性能。PreCT-160K的发布不仅为研究人员提供了丰富的预训练资源,还推动了三维医学图像分析技术的进步。

当前挑战

尽管PreCT-160K数据集在规模和多样性上具有显著优势,但其构建和应用过程中仍面临诸多挑战。首先,数据集的存储需求巨大,原始数据需要22.6 TB的存储空间,预训练过程中还需额外的30 TB空间,这对计算资源提出了极高的要求。其次,数据集的标注和预处理过程复杂,涉及大量的计算和时间成本。此外,如何在有限的计算资源下高效地进行预训练,以及如何确保预训练模型在下游任务中的泛化能力,也是当前研究中亟待解决的问题。

常用场景

经典使用场景

在医学影像分析领域,PreCT-160K数据集以其庞大的规模和多样性,成为3D医学图像预训练的经典资源。该数据集包含160,000个CT体积(共计4200万张切片),为研究人员提供了丰富的几何和解剖学信息。通过利用这些数据进行预训练,研究人员可以显著提升模型在下游任务中的表现,如器官分割、肿瘤分类和图像配准等。

解决学术问题

PreCT-160K数据集解决了3D医学图像预训练中的关键学术问题,即如何在有限标注数据的情况下,通过大规模无标注数据提升模型性能。其庞大的数据量和多样性为模型提供了丰富的几何和解剖学先验知识,从而在下游任务中实现了更高的准确性和鲁棒性。这一研究成果对推动医学影像分析技术的发展具有重要意义。

实际应用

在实际应用中,PreCT-160K数据集被广泛用于医学影像分析系统的开发和优化。例如,在临床诊断中,通过预训练的模型可以更准确地识别和分割病变区域,辅助医生进行诊断和治疗规划。此外,该数据集还支持多种预训练策略,如全监督、自监督和半监督学习,为不同应用场景提供了灵活的解决方案。

数据集最近研究

最新研究方向

在3D医学图像处理领域,PreCT-160K数据集的最新研究方向主要集中在利用大规模预训练模型来提升医学图像分析的准确性和效率。通过引入VoCo方法,研究者们致力于开发一种简单而有效的体积对比学习框架,以处理3D医学图像的预训练任务。该方法不仅提供了160K体积(42M切片)的预训练数据集,还包含了31M至1.2B参数的预训练模型,以及多种预训练策略和50多个下游任务的实现。这些研究成果在CVPR 2024等顶级会议上得到了广泛关注,展示了其在医学图像分类、分割和注册等任务中的显著优势,为未来的医学图像处理研究奠定了坚实的基础。

以上内容由AI搜集并总结生成