有没有相关的论文或文献参考?

这个数据集是基于什么背景创建的?

数据集的作者是谁?

能帮我联系到这个数据集的作者吗?

这个数据集如何下载?

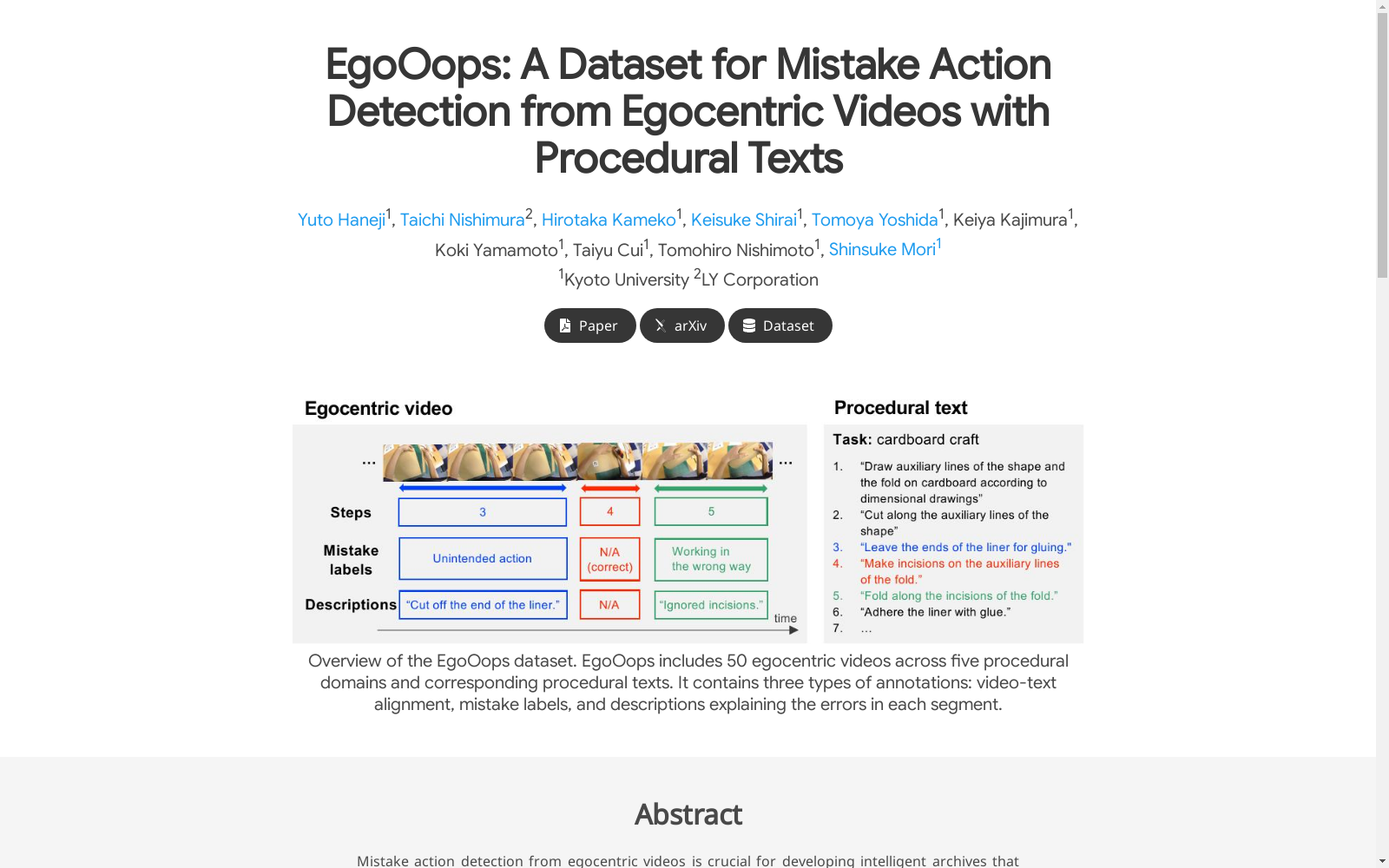

EgoOops 是一个视频-语言数据集,记录了包括错误动作在内的程序性活动。该数据集专注于从第一人称视角视频中检测错误动作,并结合程序性文本进行分析。

机构:

烟火数据集

烟火数据集是一个专门用于烟火识别和检测任务的数据集,旨在帮助研究人员开发更加精确和高效的烟火识别算法。包含了大量真实场景下的烟火视频数据,具有广泛的应用前景和重要的研究价值。

阿里云天池 收录

Subway Dataset

该数据集包含了全球多个城市的地铁系统数据,包括车站信息、线路图、列车时刻表、乘客流量等。数据集旨在帮助研究人员和开发者分析和模拟城市交通系统,优化地铁运营和乘客体验。

www.kaggle.com 收录

Google Scholar

Google Scholar是一个学术搜索引擎,旨在检索学术文献、论文、书籍、摘要和文章等。它涵盖了广泛的学科领域,包括自然科学、社会科学、艺术和人文学科。用户可以通过关键词搜索、作者姓名、出版物名称等方式查找相关学术资源。

scholar.google.com 收录

糖尿病预测数据集

糖尿病相关的医学研究或者健康数据

AI_Studio 收录

WideIRSTD Dataset

WideIRSTD数据集包含七个公开数据集:SIRST-V2、IRSTD-1K、IRDST、NUDT-SIRST、NUDT-SIRST-Sea、NUDT-MIRSDT、Anti-UAV,以及由国防科技大学团队开发的数据集,包括模拟陆基和太空基数据,以及真实手动标注的太空基数据。数据集包含具有各种目标形状(如点目标、斑点目标、扩展目标)、波长(如近红外、短波红外和热红外)、图像分辨率(如256、512、1024、3200等)的图像,以及不同的成像系统(如陆基、空基和太空基成像系统)。

github 收录