C4 Dataset|自然语言处理数据集|机器学习数据集

收藏EMNLP 2024 数据集概述

数据集名称

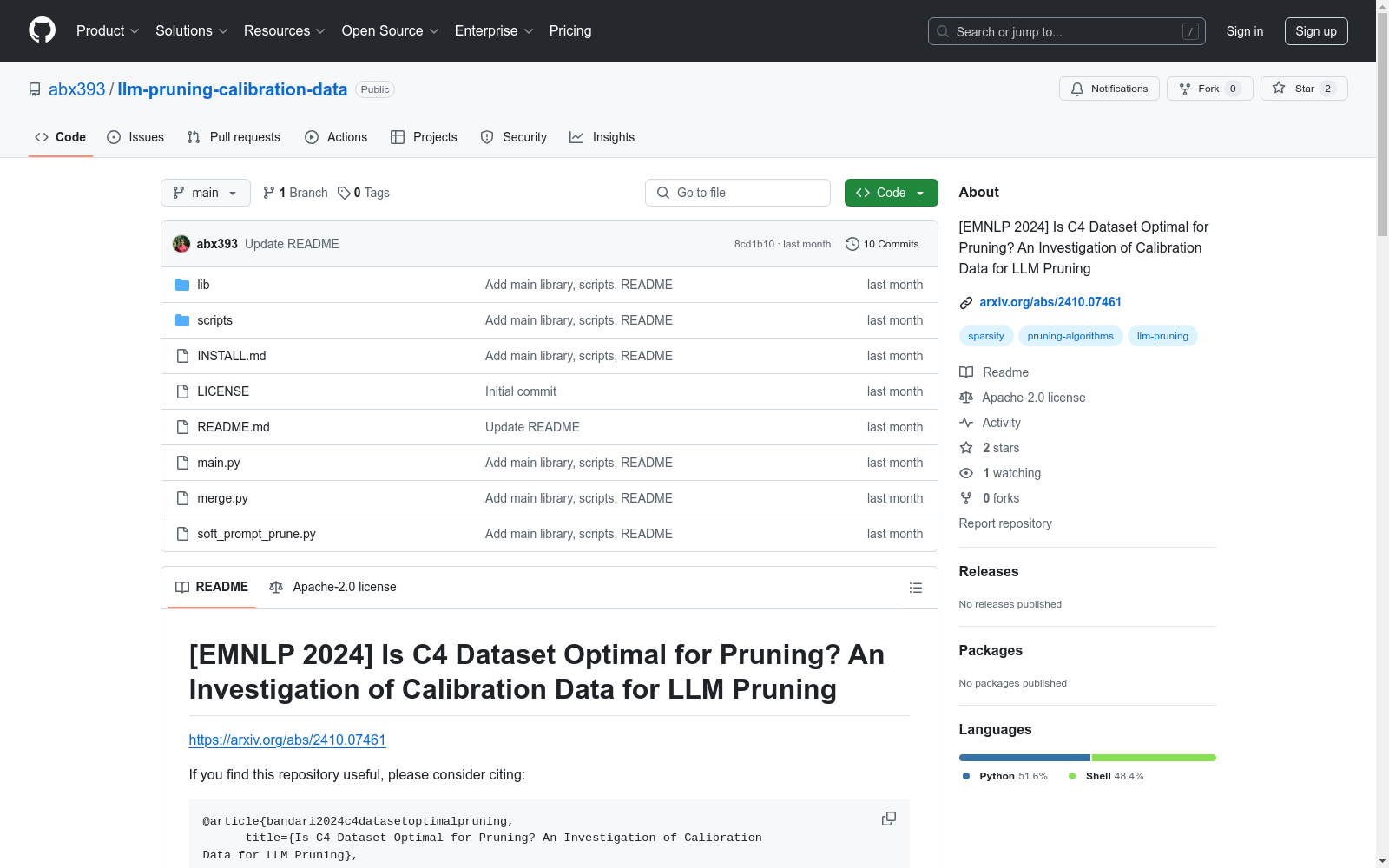

Is C4 Dataset Optimal for Pruning? An Investigation of Calibration Data for LLM Pruning

数据集描述

该数据集用于研究大型语言模型(LLM)剪枝中的校准数据选择问题。研究评估了多种常用数据集在LLM剪枝中的表现,包括预训练数据集和下游任务数据集。研究结果表明,C4数据集并非最优选择,某些算术数据集在校准数据选择上表现更佳。

数据集内容

校准数据集

- 文本数据集:

- C4

- Pile

- Oscar

- RedPajama

- 算术问答数据集:

- GSM8K

- SVAMP

- MAWPS

- 自然语言推理数据集:

- e-SNLI

- ANLI R1

- ANLI R3

- 常识问答数据集:

- CommonSenseQA

- RACE

- WinoGrande

剪枝方法

- Wanda

- SparseGPT

模型

- Llama 2-Chat 7B

- LLaMA 7B

使用说明

参数说明

--model:Hugging Face模型库中的LLaMA模型标识符。--cache_dir:加载或存储LLM权重的目录,默认为llm_weights。--prune_method:剪枝方法,可选值为["magnitude", "wanda", "sparsegpt", "none"]。--sparsity_ratio:表示要剪枝的权重百分比。--sparsity_type:指定稀疏类型,可选值为[unstructured,2:4,4:8]。--save:指定存储结果的目录。--calibration:校准数据集选择,可选值包括[c4, oscar, redpajama, pile, gsm8k, svamp, mawps, anli_r1, anli_r2, anli_r3, esnli, rte, boolq, commonsense_qa, race, winogrande, wmt14, ellipses, random]。--seed:校准数据采样的种子,默认为0。--nsamples:校准样本数量,默认为128。--cache_dir:缓存权重的文件路径目录,默认为llm_weights。--input_format:默认为concat,可选值为[single, concat, zero]。--seqlen:上下文窗口的长度(以token为单位),默认为2048。--data_seqlen:每个校准样本中有意义的token数量,剩余部分用填充token填充。--num_incontext:每个校准样本中的上下文问答对数量。--num_cot_steps:每个问答对在校准样本中的CoT推理步骤数量,仅在使用--rationale时有效。--rationale:如果包含此标志,在校准样本的问答对答案部分包含CoT推理。--eval_rationale:如果包含此标志,在评估时,在提示中的上下文示例中包含CoT推理。--eval:默认为wikitext,可选值为[wikitext, redpajama, oscar, gsm8k, svamp, mawps, anli_r1, anli_r2, anli_r3, esnli, rte, boolq, commonsense_qa, race, winogrande, all]。--skip_dense_eval:如果包含此标志,跳过密集模型(剪枝前)的评估。--verbose:如果包含此标志,将中间结果打印到标准输出。--append_to_file:追加结果的文件。--save_model:保存剪枝模型的路径。

示例

sh python main.py --model huggyllama/llama-7b --seed 0 --prune_method wanda --sparsity_ratio 0.5 --sparsity_type unstructured --save out/llama_7b/0/

引用

@article{bandari2024c4datasetoptimalpruning, title={Is C4 Dataset Optimal for Pruning? An Investigation of Calibration Data for LLM Pruning}, author={Abhinav Bandari and Lu Yin and Cheng-Yu Hsieh and Ajay Kumar Jaiswal and Tianlong Chen and Li Shen and Ranjay Krishna and Shiwei Liu}, year={2024}, eprint={2410.07461}, archivePrefix={arXiv}, primaryClass={cs.CL}, url={https://arxiv.org/abs/2410.07461}, }