shibing624/medical|医疗,偏好数据集数据集

收藏数据集概述

基本信息

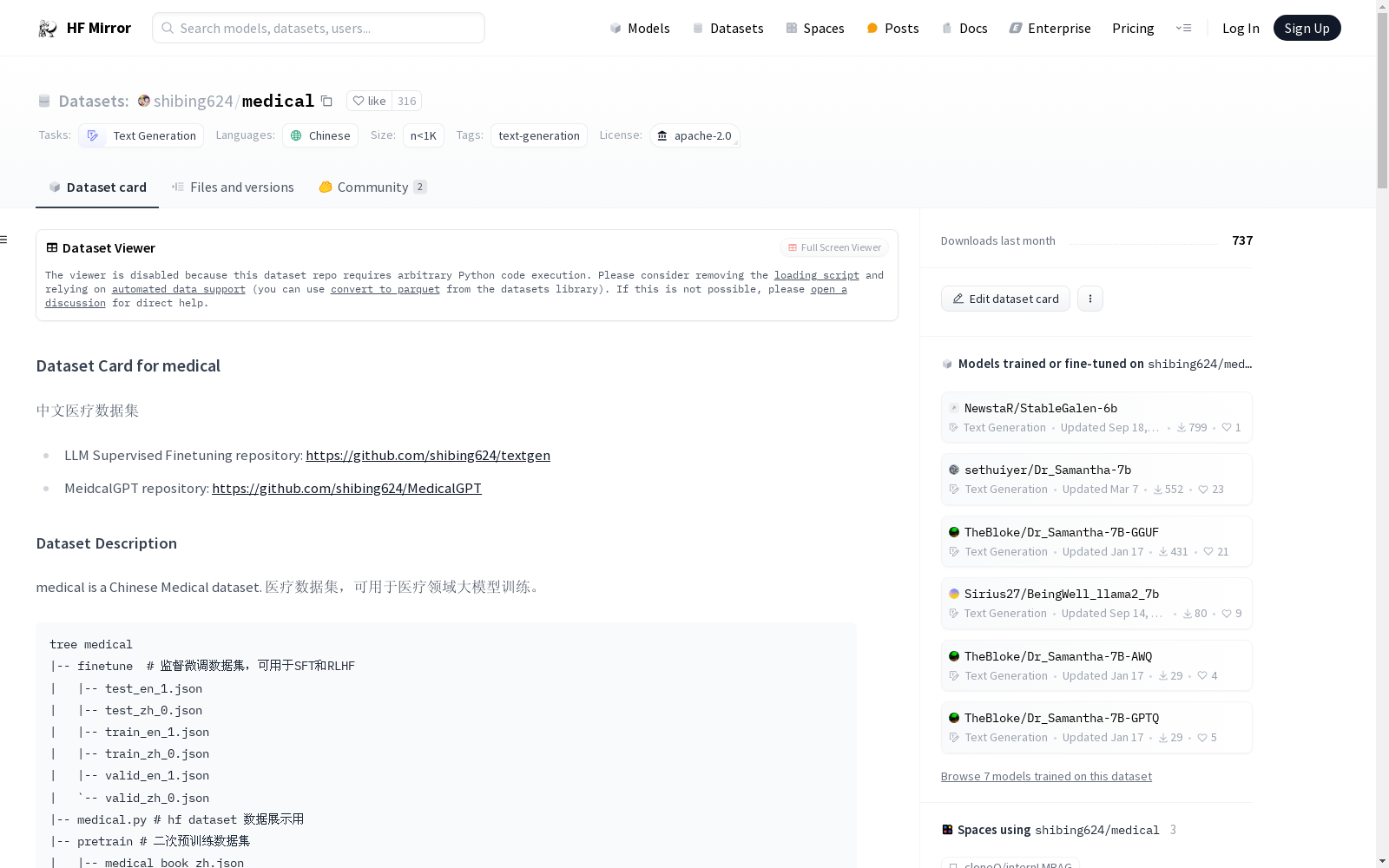

- 名称: medical

- 语言: 中文、英文

- 标签: text-generation

- 任务类别: text-generation

- 大小: 1M<n<10M

- 许可证: Apache-2.0

数据集描述

- 用途: 医疗领域大模型训练

- 数据来源:

- 监督微调数据集来自中文医疗对话数据集和在线医疗百科。

- 二次预训练数据集来自医疗教材和医疗百科数据。

- 奖励模型数据集来自中文医疗对话数据集。

数据集结构

- 预训练数据集:

- 字段: text

- 指令微调数据集:

- 字段: instruction, input, output

- 奖励模型数据集:

- 字段: question, response_chosen, response_rejected

数据集细分

- 预训练数据集:

- train_encyclopedia.json: 361420条

- medical_book_zh.json: 8475条

- 指令微调数据集:

- train_zh_0.json: 1949972条

- train_en_1.json: 116617条

- 奖励模型数据集:

- train.json: 3800条

许可证信息

- 许可证: Apache 2.0

引用信息

- 主要参考来源包括医疗对话数据集和医疗百科数据集的GitHub和Hugging Face链接。

GME Data

关于2021年GameStop股票活动的数据,包括每日合并的GME短期成交量数据、每日失败交付数据、可借股数、期权链数据以及不同时间框架的开盘/最高/最低/收盘/成交量条形图。

github 收录

BANTH

BANTH数据集是由Penta Global Limited和Islamic University of Technology合作创建的,专门用于检测和分类转写孟加拉语中的仇恨言论。该数据集包含37,350条样本,主要来源于YouTube评论,涵盖新闻与政治、人物与博客、娱乐等多个类别。数据集的创建过程包括数据抓取、过滤、清洗和多轮人工标注与验证,确保了数据的高质量和准确性。BANTH数据集的应用领域主要集中在多标签仇恨言论检测,旨在解决低资源语言中仇恨言论自动检测的挑战,并为未来的跨语言和多标签分类研究奠定基础。

arXiv 收录

OpenSonarDatasets

OpenSonarDatasets是一个致力于整合开放源代码声纳数据集的仓库,旨在为水下研究和开发提供便利。该仓库鼓励研究人员扩展当前的数据集集合,以增加开放源代码声纳数据集的可见性,并提供一个更容易查找和比较数据集的方式。

github 收录

Oxford 102 Flowers

牛津102花卉数据集是一个主要用于图像分类的花卉集合数据集,分为102个类别,共102种花卉,其中每个类别包含40到258幅图像。 该数据集由牛津大学工程科学系2008年在相关论文 “大量类别上的自动花分类” 中发布

OpenDataLab 收录

PDT Dataset

PDT数据集是由山东计算机科学中心(国家超级计算济南中心)和齐鲁工业大学(山东省科学院)联合开发的无人机目标检测数据集,专门用于检测树木病虫害。该数据集包含高分辨率和低分辨率两种版本,共计5775张图像,涵盖了健康和受病虫害影响的松树图像。数据集的创建过程包括实地采集、数据预处理和人工标注,旨在为无人机在农业中的精准喷洒提供高精度的目标检测支持。PDT数据集的应用领域主要集中在农业无人机技术,旨在提高无人机在植物保护中的目标识别精度,解决传统检测模型在实际应用中的不足。

arXiv 收录