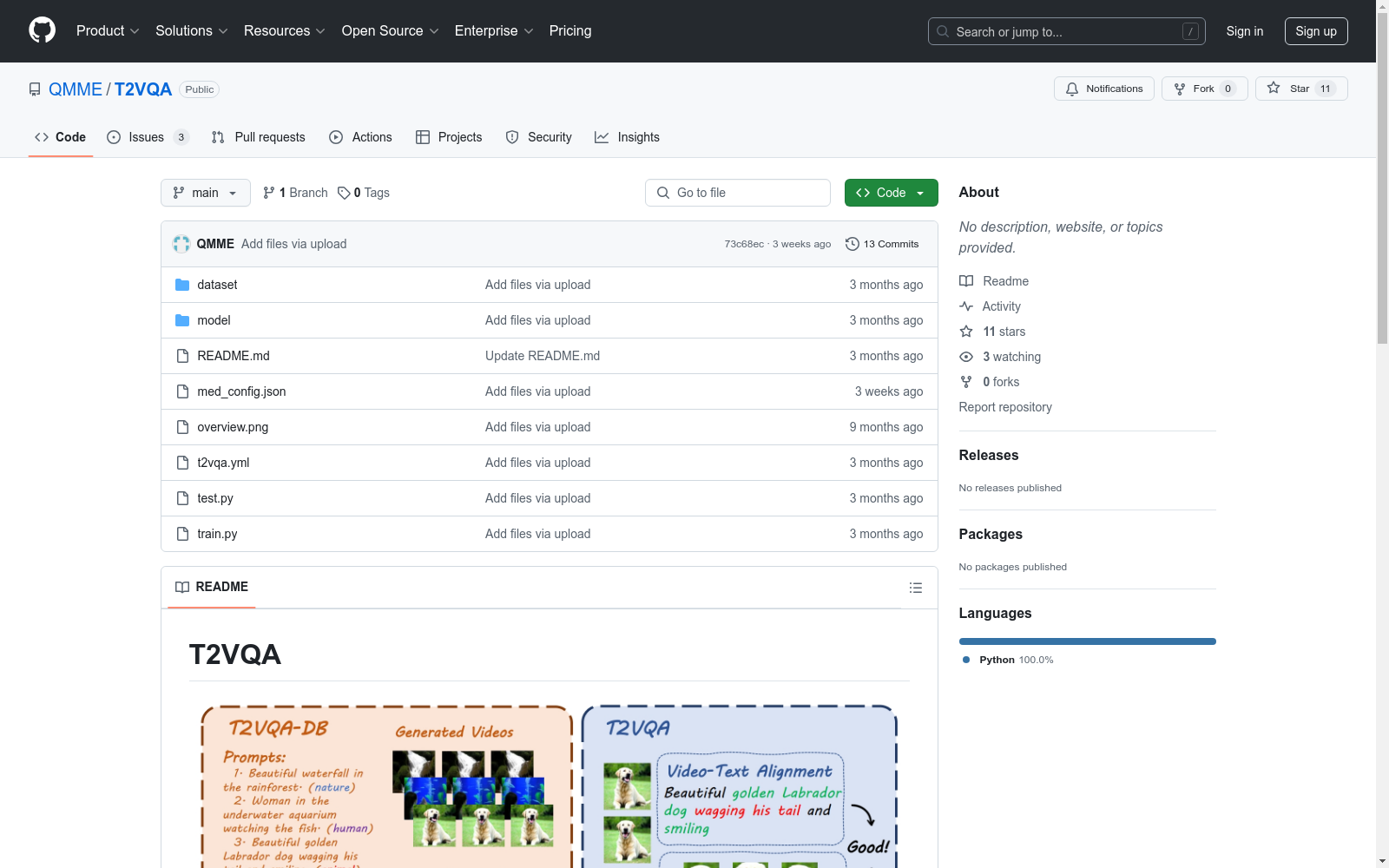

Text-to-Video Quality Assessment DataBase (T2VQA-DB)|文本到视频质量评估数据集|视频质量分析数据集

收藏

- 1Subjective-Aligned Dataset and Metric for Text-to-Video Quality Assessment上海交通大学 · 2024年

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

CliMedBench

CliMedBench是一个大规模的中文医疗大语言模型评估基准,由华东师范大学等机构创建。该数据集包含33,735个问题,涵盖14个核心临床场景,主要来源于顶级三级医院的真实电子健康记录和考试练习。数据集的创建过程包括专家指导的数据选择和多轮质量控制,确保数据的真实性和可靠性。CliMedBench旨在评估和提升医疗大语言模型在临床决策支持、诊断和治疗建议等方面的能力,解决医疗领域中模型性能评估的不足问题。

arXiv 收录

Fruits-360

一个高质量的水果图像数据集,包含多种水果的图像,如苹果、香蕉、樱桃等,总计42345张图片,分为训练集和验证集,共有64个水果类别。

github 收录

MedChain

MedChain是由香港城市大学、香港中文大学、深圳大学、阳明交通大学和台北荣民总医院联合创建的临床决策数据集,包含12,163个临床案例,涵盖19个医学专科和156个子类别。数据集通过五个关键阶段模拟临床工作流程,强调个性化、互动性和顺序性。数据来源于中国医疗网站“iiYi”,经过专业医生验证和去识别化处理,确保数据质量和患者隐私。MedChain旨在评估大型语言模型在真实临床场景中的诊断能力,解决现有基准在个性化医疗、互动咨询和顺序决策方面的不足。

arXiv 收录