UCSC-VLAA/HQ-Edit|图像编辑数据集|人工智能数据集

收藏数据集概述

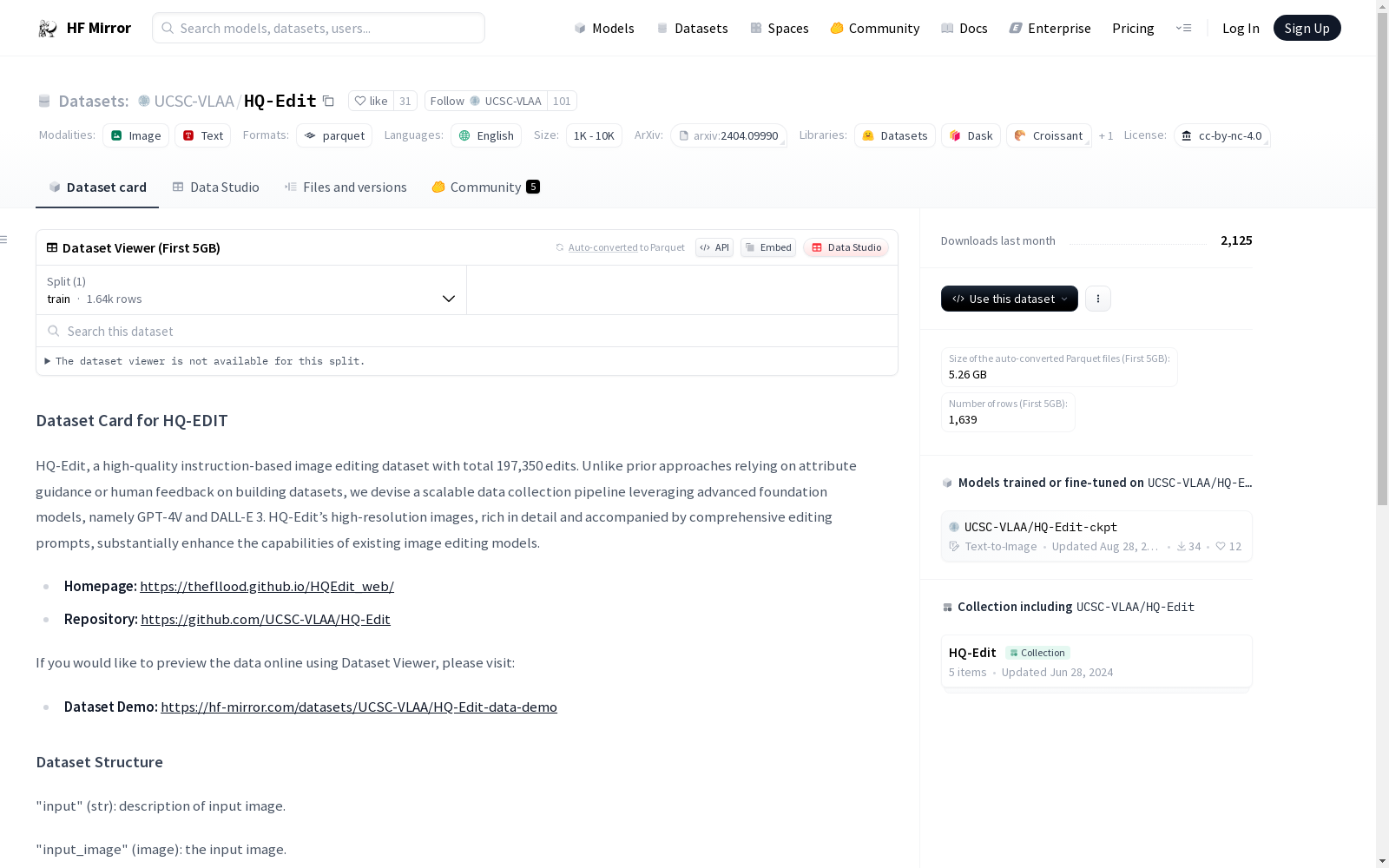

名称: HQ-Edit

描述: HQ-Edit是一个高质量的基于指令的图像编辑数据集,包含197,350次编辑。该数据集利用先进的模型GPT-4V和DALL-E 3构建,提供高分辨率图像和详细的编辑指令,显著增强了现有图像编辑模型的能力。

语言: 英语(en)

规模: 10万<n<100万

许可: CC-BY-NC-4.0

数据集结构

- input (字符串): 输入图像的描述。

- input_image (图像): 输入图像。

- edit (字符串): 将输入图像转换为输出图像的编辑指令。

- inverse_edit (字符串): 将输出图像转换回输入图像的逆向编辑指令。

- output (字符串): 输出图像的描述。

- output_image (图像): 输出图像。

数据集分割

- 训练集: 包含98,675个示例。

引用信息

若使用此数据集,请引用以下论文:

@article{hui2024hq, title = {HQ-Edit: A High-Quality Dataset for Instruction-based Image Editing}, author = {Hui, Mude and Yang, Siwei and Zhao, Bingchen and Shi, Yichun and Wang, Heng and Wang, Peng and Zhou, Yuyin and Xie, Cihang}, journal = {arXiv preprint arXiv:2404.09990}, year = {2024} }

中国劳动力动态调查

“中国劳动力动态调查” (China Labor-force Dynamics Survey,简称 CLDS)是“985”三期“中山大学社会科学特色数据库建设”专项内容,CLDS的目的是通过对中国城乡以村/居为追踪范围的家庭、劳动力个体开展每两年一次的动态追踪调查,系统地监测村/居社区的社会结构和家庭、劳动力个体的变化与相互影响,建立劳动力、家庭和社区三个层次上的追踪数据库,从而为进行实证导向的高质量的理论研究和政策研究提供基础数据。

中国学术调查数据资料库 收录

China Health and Nutrition Survey (CHNS)

China Health and Nutrition Survey(CHNS)是一项由美国北卡罗来纳大学人口中心与中国疾病预防控制中心营养与健康所合作开展的长期开放性队列研究项目,旨在评估国家和地方政府的健康、营养与家庭计划政策对人群健康和营养状况的影响,以及社会经济转型对居民健康行为和健康结果的作用。该调查覆盖中国15个省份和直辖市的约7200户家庭、超过30000名个体,采用多阶段随机抽样方法,收集了家庭、个体以及社区层面的详细数据,包括饮食、健康、经济和社会因素等信息。自2011年起,CHNS不断扩展,新增多个城市和省份,并持续完善纵向数据链接,为研究中国社会经济变化与健康营养的动态关系提供了重要的数据支持。

www.cpc.unc.edu 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录

WET (Channel 1) 287 - 00047.tif

:unav

DataCite Commons 收录

CASIA v1.0, CASIA v2.0, Columbia Gray, Columbia Color, NIST 2016(Nimble Challenge 2016 (NC16)), NC17, MFC18, Fantastic Reality, Carvalho, Realistic Tampering, COVERAGE, CoMoFoD

本仓库收集了多个用于图像篡改检测和定位的数据集,包括CASIA v1.0、CASIA v2.0等,这些数据集涵盖了不同的篡改类型和处理方式,用于训练和测试图像篡改检测方法。

github 收录