Dense Material Segmentation dataset (DMS)|材料分割数据集|场景解析数据集

收藏arXiv2022-07-22 更新2024-06-21 收录

下载链接:

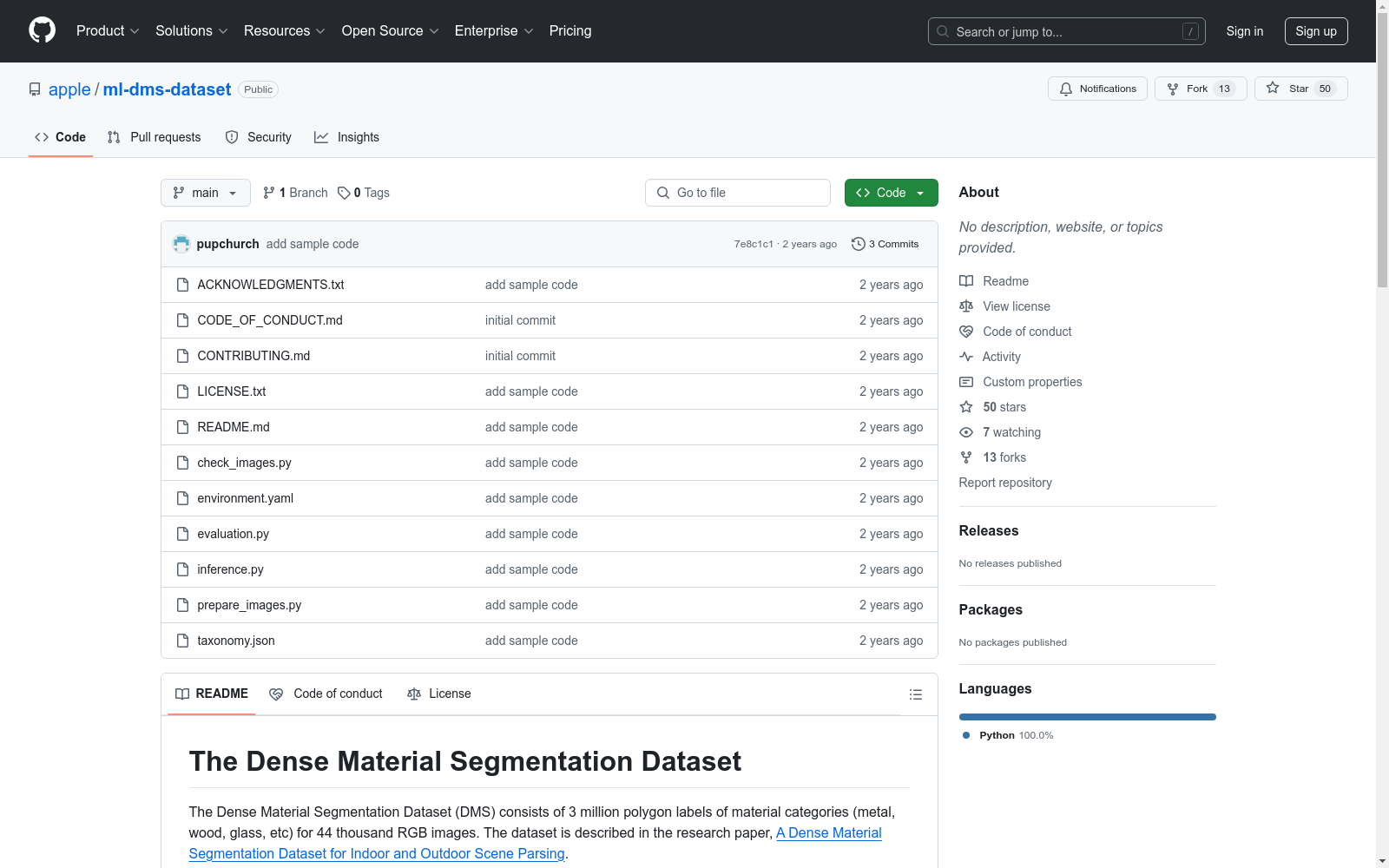

https://github.com/apple/ml-dms-dataset

下载链接

链接失效反馈资源简介:

Dense Material Segmentation dataset (DMS) 是由苹果公司创建的一个大规模室内外场景解析材料分割数据集。该数据集包含44,560张图像,共计320万个密集标注的材料段,覆盖了更广泛的场景、物体、视角和材料类型。DMS数据集旨在通过提供丰富的材料标注,推动材料识别技术的发展,特别是在室内外场景解析领域。数据集的创建过程涉及详细的图像选择、人工标注和多轮验证,确保了标注的准确性和一致性。DMS数据集的应用领域广泛,包括机器人导航、材料分配、触觉模拟和上下文感知混合现实等,旨在解决现有模型在特定环境下性能不足的问题。

提供机构:

苹果公司

创建时间:

2022-07-22

AI搜集汇总

数据集介绍

构建方式

Dense Material Segmentation dataset (DMS) 的构建基于大规模的室内外场景解析需求,通过收集和标注44,560张图像,生成了320万个密集的材料分割标注。数据集的构建过程包括定义52种材料标签,通过人工和算法筛选图像,进行全场景的密集标注,并最终通过多轮标注和融合生成最终的标签图。这一过程确保了数据集的高质量和多样性,涵盖了广泛的场景、物体、视角和材料类型。

特点

DMS 数据集的显著特点在于其大规模和多样性。它包含了比现有数据集多23倍的材料分割标注,覆盖了更广泛的室内外场景、物体和材料类型。此外,数据集在皮肤类型的分布上更加公平,有助于训练出更公正的模型。DMS 还引入了九种摄影类型,以揭示模型在不同设置下的性能,从而提供更全面的评估基准。

使用方法

DMS 数据集可用于训练和评估室内外场景解析模型,特别是在材料分割任务中。用户可以通过加载数据集中的图像和标注,使用深度学习模型进行训练。数据集提供了详细的材料标签和密集的分割标注,适合于需要高精度材料识别的应用,如机器人导航、触觉反馈和虚拟现实。此外,DMS 还提供了一个基准测试,用户可以在此基础上进行模型的性能比较和改进。

背景与挑战

背景概述

在计算机视觉领域,材料分割作为理解世界的关键算法,通过为每个像素分配标签(如金属、玻璃等)来识别物体的材质。尽管现有数据集在某些场景下表现不佳,但Dense Material Segmentation dataset (DMS)的出现填补了这一空白。该数据集由Apple Inc.的Paul Upchurch和Ransen Niu领导创建,包含了320万个密集片段,覆盖了44,560张室内外图像,是现有数据集的23倍。DMS不仅在场景、物体、视角和材料上更加多样化,还包含了更公平的皮肤类型分布。通过在DMS上训练的模型,研究人员展示了其在多个数据集和视角上的优越性能,推动了场景解析技术的发展。

当前挑战

DMS数据集在构建过程中面临多重挑战。首先,如何确保数据集的多样性和公平性,特别是在皮肤类型分布上,是一个重要问题。其次,数据集的构建需要高效的标注工具和大量的标注工作,以确保每个像素的标签准确性。此外,如何在室内外不同场景下保持模型的一致性和高性能,也是研究人员需要解决的难题。最后,随着数据集规模的扩大,如何有效地管理和利用这些数据,以推动计算机视觉技术的发展,是当前和未来需要持续关注的问题。

常用场景

经典使用场景

Dense Material Segmentation dataset (DMS) 的经典使用场景在于室内外场景解析中的材料分割任务。该数据集通过为每个像素分配材料标签(如金属、玻璃等),显著提升了模型在复杂环境中的表现。其高密度的标注和广泛的场景覆盖,使得模型能够在不同视角和光照条件下识别和分割材料,从而为计算机视觉中的场景理解提供了强有力的支持。

解决学术问题

DMS 数据集解决了现有数据集在材料分割任务中表现不佳的问题,特别是在室内外场景的泛化能力上。通过提供320万个密集标注的材料分割,DMS 数据集显著提升了模型的准确性和鲁棒性,特别是在处理多样化的场景、物体、视角和材料时。这不仅推动了材料分割技术的发展,也为相关领域的研究提供了新的基准和挑战。

衍生相关工作

DMS 数据集的发布催生了一系列相关研究工作,特别是在深度学习和计算机视觉领域。例如,基于 DMS 数据集的材料分割模型被用于改进机器人对环境的理解和交互能力,以及在增强现实中的应用。此外,DMS 数据集还激发了对多任务场景解析模型的研究,这些模型能够同时处理物体识别、材料分割和场景理解等多个任务,从而进一步提升系统的整体性能和应用范围。

以上内容由AI搜集并总结生成