有没有相关的论文或文献参考?

这个数据集是基于什么背景创建的?

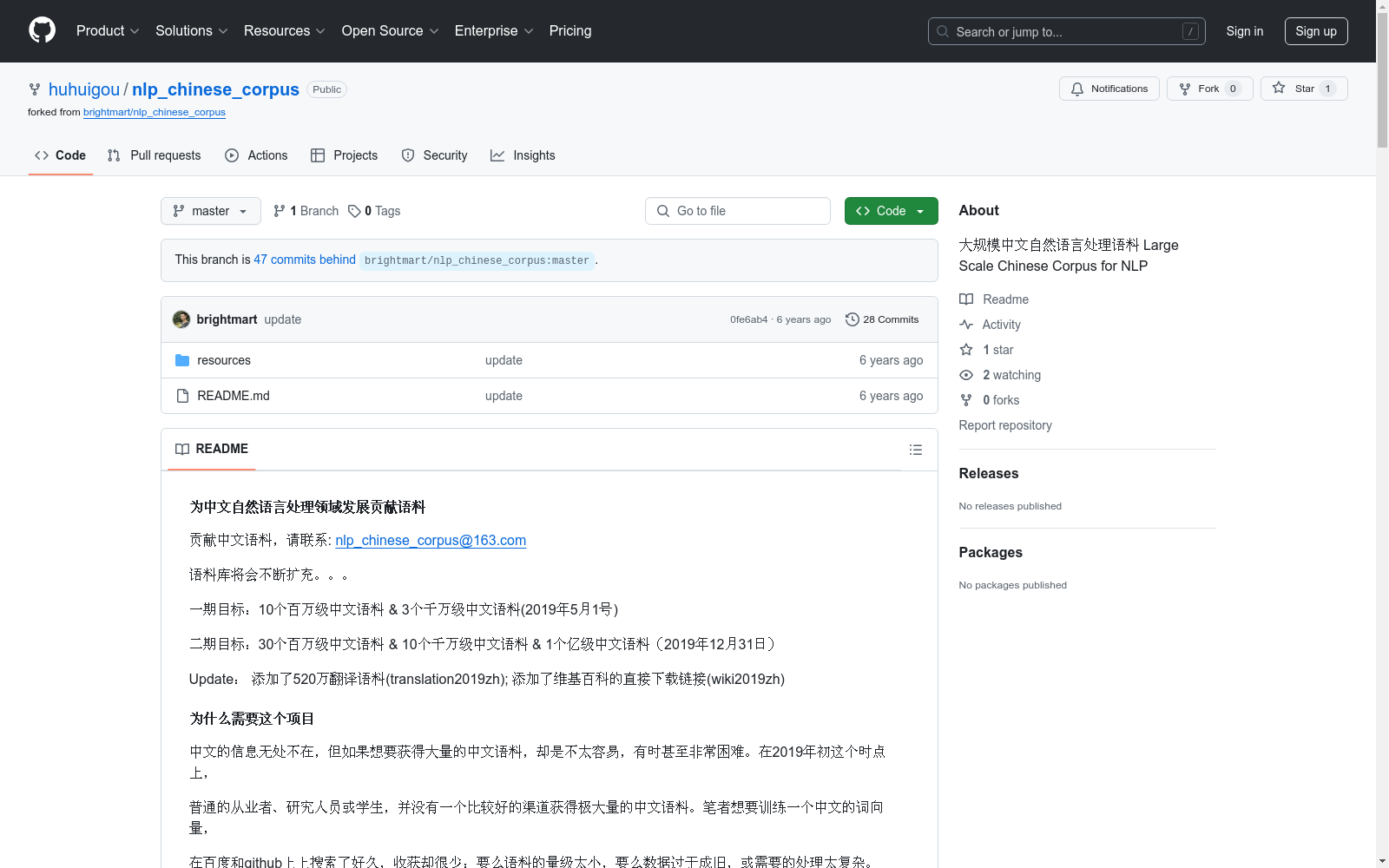

数据集的作者是谁?

能帮我联系到这个数据集的作者吗?

这个数据集如何下载?

id, url, title, text。news_id, title, content, source, time, keywords, desc。qid, category, title, desc, answer。english, chinese。

中国区域交通网络数据集

该数据集包含中国各区域的交通网络信息,包括道路、铁路、航空和水路等多种交通方式的网络结构和连接关系。数据集详细记录了各交通节点的位置、交通线路的类型、长度、容量以及相关的交通流量信息。

data.stats.gov.cn 收录

FER2013

FER2013数据集是一个广泛用于面部表情识别领域的数据集,包含28,709个训练样本和7,178个测试样本。图像属性为48x48像素,标签包括愤怒、厌恶、恐惧、快乐、悲伤、惊讶和中性。

github 收录

PCLT20K

PCLT20K数据集是由湖南大学等机构创建的一个大规模PET-CT肺癌肿瘤分割数据集,包含来自605名患者的21,930对PET-CT图像,所有图像都带有高质量的像素级肿瘤区域标注。该数据集旨在促进医学图像分割研究,特别是在PET-CT图像中肺癌肿瘤的分割任务。

arXiv 收录

Breast Ultrasound Images (BUSI)

小型(约500×500像素)超声图像,适用于良性和恶性病变的分类和分割任务。

github 收录

LIDC-IDRI

LIDC-IDRI 数据集包含来自四位经验丰富的胸部放射科医师的病变注释。 LIDC-IDRI 包含来自 1010 名肺部患者的 1018 份低剂量肺部 CT。

OpenDataLab 收录