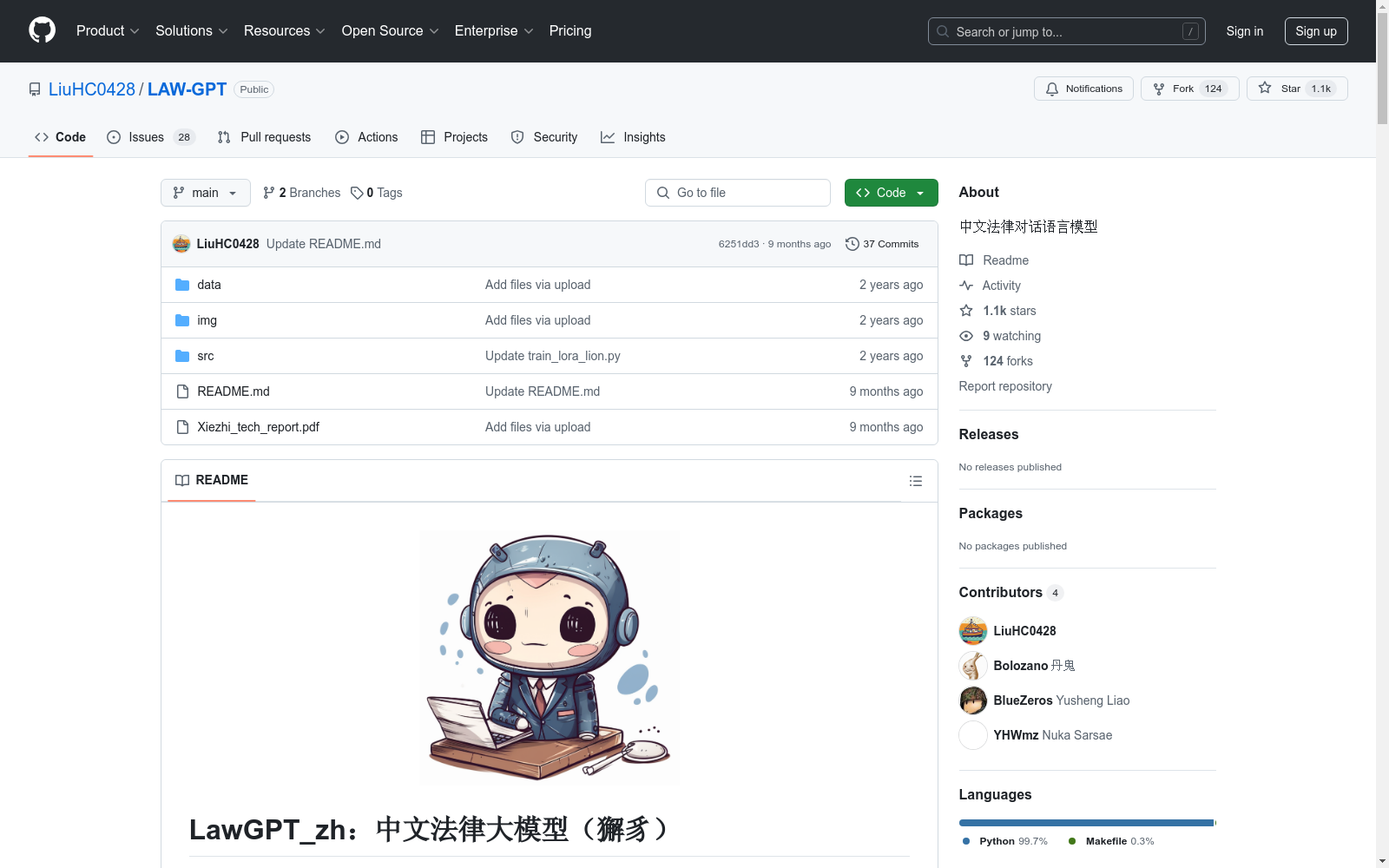

LawGPT_zh|法律对话数据集|法律知识问答数据集

收藏LawGPT_zh:中文法律大模型(獬豸)

项目简介

- 目标:为公众提供专业可靠的法律问题解答,推动法律服务的普及和法治社会的构建。

- 模型基础:基于ChatGLM-6B LoRA 16-bit指令微调的中文法律通用模型。

- 数据集特点:结合法律问答数据集和基于法条及真实案例的self-Instruct高质量法律文本问答,提升模型在法律领域的专业性和可靠性。

数据集详情

数据构成

-

情景对话

- 来源:真实律师用户问答数据,来自CrimeKgAssitant收集的200k条情景对话。

- 处理:利用ChatGPT清洗得到52k单轮问答,语言更规范详细。

-

带有法律依据的情景问答

- 来源:基于《中华人民共和国法律手册》9k核心法条,通过ChatGPT生成92k条情景问答。

- 特点:每条问答包含具体法律依据,格式为JSON,含问题、答案和相关法条引用。

-

知识问答(计划中)

- 内容:法律教科书、经典案例等,构建法律专业知识数据库。

- 方法:基于特定知识的Reliable-Self-Instruction,确保回答准确性。

数据统计

| 数据类型 | 数量 | 占比(%) |

|---|---|---|

| 情景对话 | 200k | 100 |

| 知识问答 | Coming soon | 0 |

| 总计 | 200k | 100 |

模型特点

- 输出示例:模型回答包含法条依据,提高可靠性。

- 对比测试:与ChatGLM相比,LawGPT_zh在法律领域表现更专业,回答更具法律依据。

训练与使用

-

训练步骤:

- 下载数据集。

- 配置train_lora.py参数。

- 运行训练脚本(需4张3090显卡,模型并行算法)。

-

使用步骤:

- 配置环境,安装依赖。

- 下载模型参数(ChatGLM-6B、检索模型、text2vec-base-chinese)。

- 运行交互脚本(单卡显存>=15G)。

免责声明

- 模型可能存在偏差和错误,仅供研究参考,不保证准确性和可靠性,使用者需自行承担风险。

引用

latex @misc{LAWGPT-zh, author={Hongcheng Liu, Yusheng Liao, Yutong Meng, Yuhao Wang}, title = {XieZhi: Chinese Law Large Language Model}, year = {2023}, publisher = {GitHub}, journal = {GitHub repository}, howpublished = {url{https://github.com/LiuHC0428/LAW_GPT}}, }

MultiTalk

MultiTalk数据集是由韩国科学技术院创建,包含超过420小时的2D视频,涵盖20种不同语言,旨在解决多语言环境下3D说话头生成的问题。该数据集通过自动化管道从YouTube收集,每段视频都配有语言标签和伪转录,部分视频还包含伪3D网格顶点。数据集的创建过程包括视频收集、主动说话者验证和正面人脸验证,确保数据质量。MultiTalk数据集的应用领域主要集中在提升多语言3D说话头生成的准确性和表现力,通过引入语言特定风格嵌入,使模型能够捕捉每种语言独特的嘴部运动。

arXiv 收录

China Health and Nutrition Survey (CHNS)

China Health and Nutrition Survey(CHNS)是一项由美国北卡罗来纳大学人口中心与中国疾病预防控制中心营养与健康所合作开展的长期开放性队列研究项目,旨在评估国家和地方政府的健康、营养与家庭计划政策对人群健康和营养状况的影响,以及社会经济转型对居民健康行为和健康结果的作用。该调查覆盖中国15个省份和直辖市的约7200户家庭、超过30000名个体,采用多阶段随机抽样方法,收集了家庭、个体以及社区层面的详细数据,包括饮食、健康、经济和社会因素等信息。自2011年起,CHNS不断扩展,新增多个城市和省份,并持续完善纵向数据链接,为研究中国社会经济变化与健康营养的动态关系提供了重要的数据支持。

www.cpc.unc.edu 收录

VoxBox

VoxBox是一个大规模语音语料库,由多样化的开源数据集构建而成,用于训练文本到语音(TTS)系统。

github 收录

PDT Dataset

PDT数据集是由山东计算机科学中心(国家超级计算济南中心)和齐鲁工业大学(山东省科学院)联合开发的无人机目标检测数据集,专门用于检测树木病虫害。该数据集包含高分辨率和低分辨率两种版本,共计5775张图像,涵盖了健康和受病虫害影响的松树图像。数据集的创建过程包括实地采集、数据预处理和人工标注,旨在为无人机在农业中的精准喷洒提供高精度的目标检测支持。PDT数据集的应用领域主要集中在农业无人机技术,旨在提高无人机在植物保护中的目标识别精度,解决传统检测模型在实际应用中的不足。

arXiv 收录

TCIA

TCIA(The Cancer Imaging Archive)是一个公开的癌症影像数据集,包含多种癌症类型的医学影像数据,如CT、MRI、PET等。这些数据通常与临床和病理信息相结合,用于癌症研究和临床试验。

www.cancerimagingarchive.net 收录