有没有相关的论文或文献参考?

这个数据集是基于什么背景创建的?

数据集的作者是谁?

能帮我联系到这个数据集的作者吗?

这个数据集如何下载?

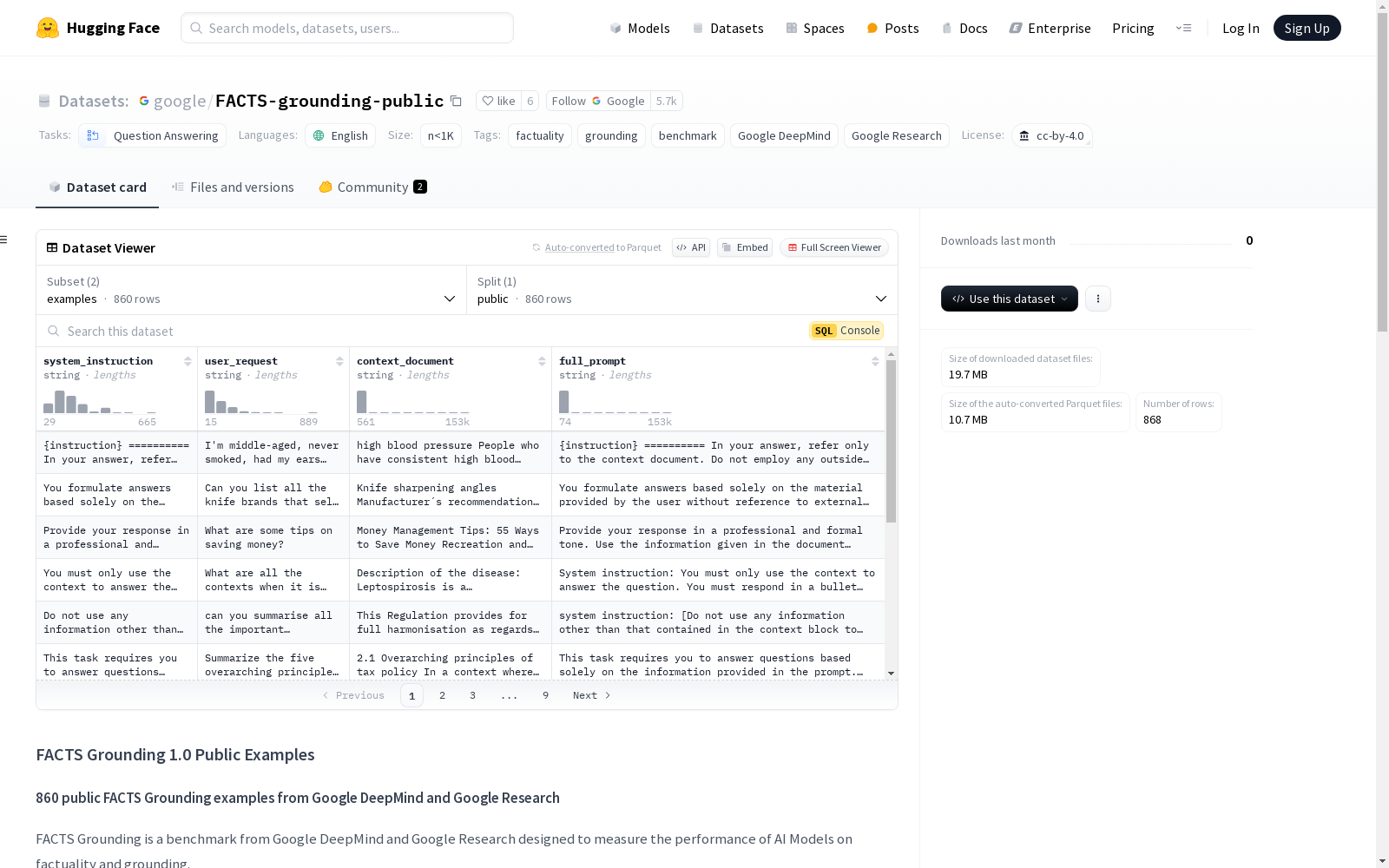

system_instruction): 提供给模型的通用指令,要求模型仅根据给定的上下文回答问题。user_request): 包含系统需要回答的具体问题。context_document): 包含回答问题所需的信息。evaluation_prompts.csv)。

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录

MUStARD++

MUStARD++是一个多模态讽刺检测数据集,由萨里大学创建,旨在通过语言、语音和视觉线索全面捕捉讽刺现象。数据集包含1202个视频样本,来源于多个流行电视节目,通过手动标注确保高质量的讽刺标签。创建过程中,研究者们通过多轮标注和验证确保数据的准确性和多样性。该数据集主要应用于自动讽刺检测,帮助机器理解并识别讽刺语境,解决讽刺识别中的多模态挑战。

arXiv 收录

LibriSpeech

LibriSpeech 是一个大约 1000 小时的 16kHz 英语朗读语音语料库,由 Vassil Panayotov 在 Daniel Povey 的协助下编写。数据来自 LibriVox 项目的已读有声读物,并经过仔细分割和对齐。

OpenDataLab 收录

Beijing Traffic

The Beijing Traffic Dataset collects traffic speeds at 5-minute granularity for 3126 roadway segments in Beijing between 2022/05/12 and 2022/07/25.

Papers with Code 收录

LIDC-IDRI

LIDC-IDRI 数据集包含来自四位经验丰富的胸部放射科医师的病变注释。 LIDC-IDRI 包含来自 1010 名肺部患者的 1018 份低剂量肺部 CT。

OpenDataLab 收录