RoboMIND|机器人操作数据集|多体智能数据集

收藏arXiv2024-12-18 更新2024-12-20 收录

下载链接:

https://x-humanoid-robomind.github.io/

下载链接

链接失效反馈加速链接:

资源简介:

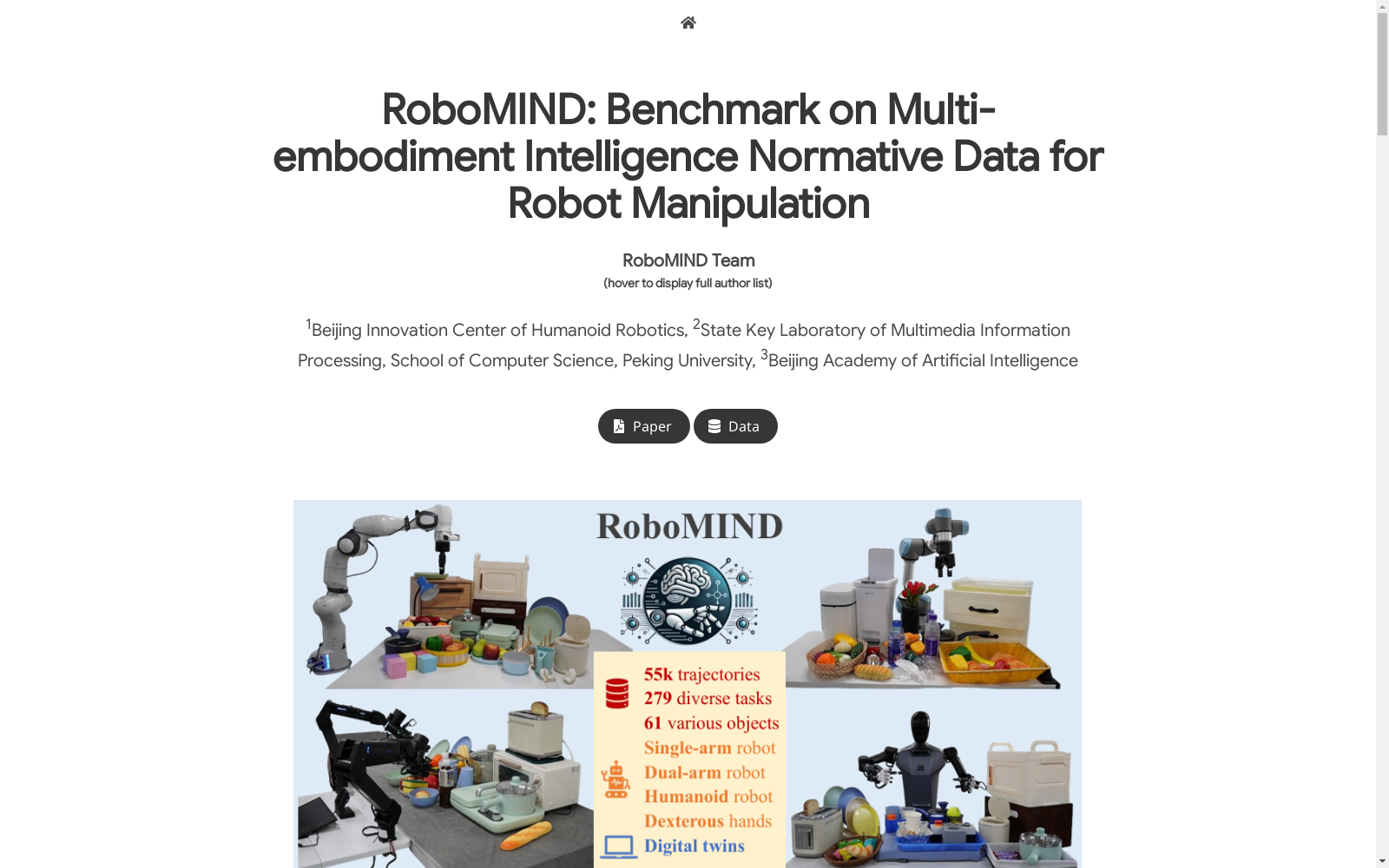

RoboMIND是由北京创新中心人形机器人和北京大学多媒体信息处理国家重点实验室联合创建的多体智能规范数据集,专注于机器人操作任务。该数据集包含55,000条真实世界的演示轨迹,涵盖279个多样化的任务和61种不同的物体类别。数据集通过人工远程操作收集,确保了数据的一致性和可靠性。RoboMIND不仅包括多视角RGB-D图像、机器人本体状态信息、末端执行器细节和任务语言描述,还创建了一个数字孪生环境,用于低成本的数据收集和高效评估。该数据集旨在解决机器人操作中的泛化问题,支持多种机器人形态的学习和应用。

提供机构:

北京创新中心人形机器人

创建时间:

2024-12-18

AI搜集汇总

数据集介绍

构建方式

RoboMIND数据集通过人工远程操作的方式构建,涵盖了55,000条真实世界的演示轨迹,涉及279个多样化的任务和61种不同的物体类别。数据集的收集遵循统一的数据采集标准,确保了数据的一致性和可靠性。具体来说,数据集包括多视角的RGB-D图像、机器人本体感知状态信息、末端执行器细节以及任务的语言描述。此外,数据集还通过Nvidia Isaac Sim模拟器创建了数字孪生环境,以低成本生成额外的训练数据,并支持高效的评估。

特点

RoboMIND数据集的显著特点在于其多样化的机器人形态和任务覆盖。数据集涵盖了四种不同的机器人形态,包括单臂机器人、双臂机器人、人形机器人和灵巧手,以及数字孪生环境中的模拟数据。任务类型涵盖了从基础操作到复杂的长时序任务,涉及61种不同的物体类别,涵盖了家庭、工业、厨房、办公室和零售等多个场景。此外,数据集不仅包含了成功的操作轨迹,还记录了5,000条失败案例,为机器人模型的改进提供了宝贵的学习资源。

使用方法

RoboMIND数据集可用于多种机器人学习任务,特别是模仿学习和视觉语言动作模型的训练。研究者可以使用该数据集进行单任务模仿学习,如ACT和BAKU算法的训练,或用于多任务视觉语言动作模型(如RDT-1B和OpenVLA)的预训练和微调。数据集的多视角图像、深度信息和语言描述为机器人理解环境和执行任务提供了丰富的输入。此外,数据集中的失败案例轨迹可以帮助模型识别和改进操作中的错误,提升其在真实世界中的表现。

背景与挑战

背景概述

RoboMIND数据集由北京创新中心人形机器人实验室、北京大学多媒体信息处理国家重点实验室和北京人工智能研究院联合开发,旨在解决机器人操作领域中通用性和多样性不足的问题。该数据集于2024年发布,包含了55,000条真实世界的演示轨迹,涵盖279个多样化的任务和61种不同的物体类别。RoboMIND通过人工远程操作收集数据,并采用统一的数据收集标准,确保了数据的一致性和可靠性。该数据集不仅涵盖了单臂、双臂和人形机器人等多种机器人形态,还提供了多视角RGB-D图像、机器人本体状态信息和任务描述等丰富的数据类型。RoboMIND的发布为机器人操作策略的训练提供了高质量的数据支持,推动了机器人操作领域的研究进展。

当前挑战

RoboMIND数据集的构建面临多重挑战。首先,机器人数据集的收集不同于视觉或语言数据,无法通过互联网爬取,而是需要在受控环境中进行详细的观察和操作记录,这需要大量的硬件和软件基础设施投入。其次,现有数据集在任务多样性、场景多样性和机器人形态多样性方面存在不足,而RoboMIND通过涵盖多种机器人形态和多样化的任务,解决了这一问题。此外,数据集的构建过程中还面临数据一致性和可靠性的挑战,RoboMIND通过标准化数据收集协议和质量保证流程,确保了数据的高质量。最后,机器人操作策略的训练需要处理复杂的任务和环境变化,如何通过RoboMIND数据集提升模型的泛化能力和任务成功率,是当前研究面临的主要挑战。

常用场景

经典使用场景

RoboMIND 数据集的经典使用场景主要集中在机器人操作任务的模仿学习中。该数据集包含了 55,000 条真实世界的演示轨迹,涵盖了 279 种多样化的任务和 61 种不同的物体类别。通过这些数据,研究人员可以训练机器人模型,使其能够在不同的机器人形态(如单臂、双臂、人形机器人等)下执行复杂的操作任务。RoboMIND 数据集的多样性和标准化收集流程使其成为模仿学习算法的重要基准,尤其是在多任务和多机器人形态的场景中。

解决学术问题

RoboMIND 数据集解决了机器人操作领域中常见的学术研究问题,特别是在机器人模型的泛化能力方面。现有的机器人数据集通常缺乏多样性,尤其是在任务、场景和机器人形态上的覆盖不足。RoboMIND 通过提供多样化的任务和机器人形态,帮助研究人员训练出更具泛化能力的机器人模型,使其能够在不同的环境、物体和机器人形态下执行任务。此外,RoboMIND 还通过记录失败案例,为研究人员提供了改进机器人操作策略的重要参考。

衍生相关工作

RoboMIND 数据集的发布催生了一系列相关的经典工作,特别是在机器人模仿学习和多模态学习领域。例如,基于 RoboMIND 数据集,研究人员开发了多种模仿学习算法,如 ACT、BAKU 和 Diffusion Policy,这些算法在多任务和多机器人形态的场景中表现出色。此外,RoboMIND 还推动了视觉-语言-动作(VLA)模型的研究,如 OpenVLA 和 RDT-1B,这些模型通过结合视觉、语言和动作信息,显著提升了机器人在复杂任务中的表现。RoboMIND 的成功应用也为其他机器人数据集的开发提供了参考,推动了机器人操作领域的标准化和多样化发展。

以上内容由AI搜集并总结生成