X-SRL|跨语言标注数据集|语义角色标注数据集

收藏arXiv2020-10-05 更新2024-06-21 收录

下载链接:

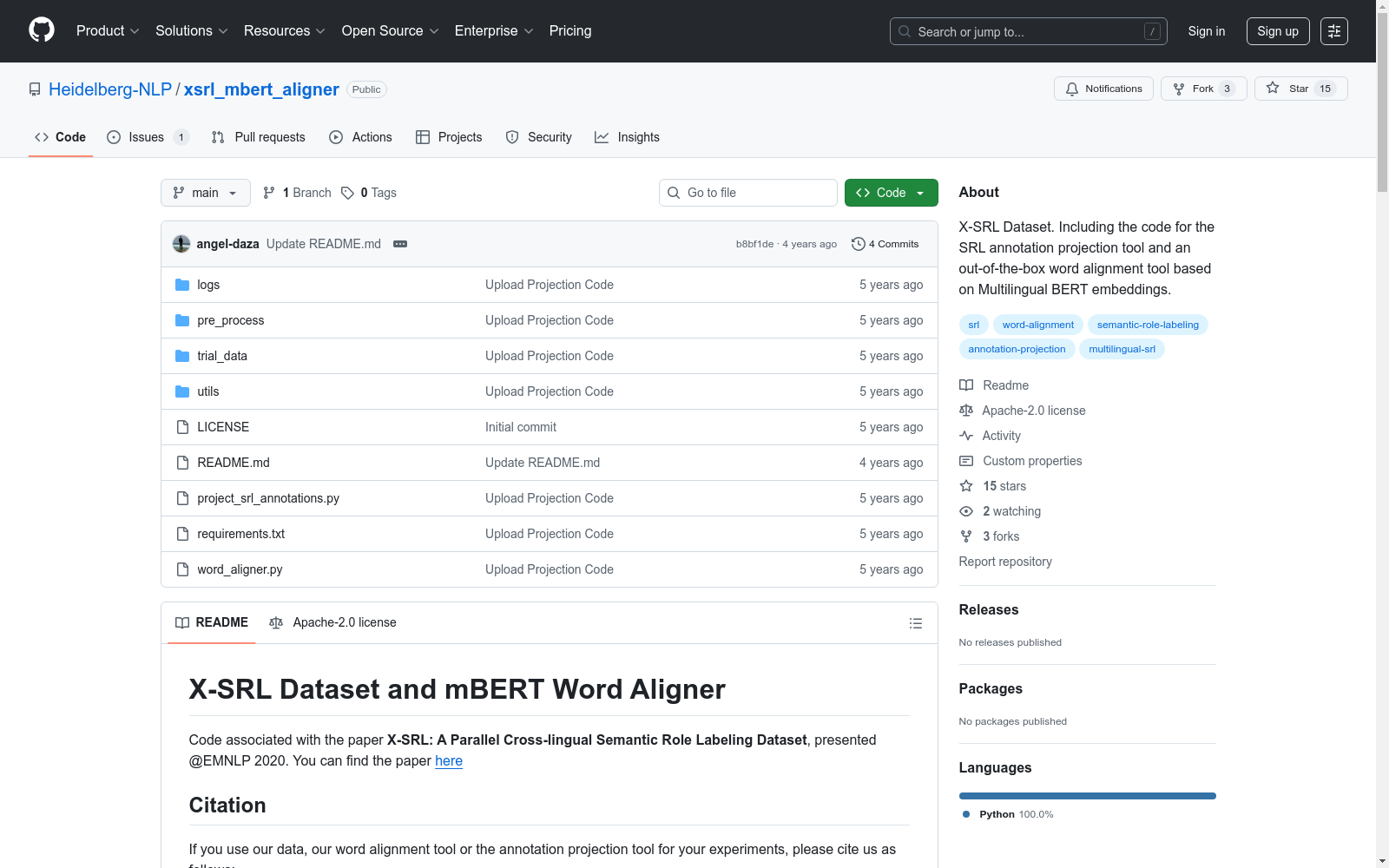

https://github.com/Heidelberg-NLP/xsrl_mbert_aligner

下载链接

链接失效反馈资源简介:

X-SRL是一个跨语言的语义角色标注平行数据集,由莱布尼茨科学校园“实证语言学与计算语言建模”创建。该数据集包含英语、法语、德语和西班牙语四种语言,每种语言都有统一的谓词和角色标注,确保了跨语言的可比性。数据集的创建过程利用了高质量的机器翻译和多语言BERT模型,将英语CoNLL-09数据集的标注自动投影到目标语言。此外,数据集还包括人工验证的测试集,用于评估标注投影的质量。X-SRL数据集的应用领域包括提高多语言SRL模型的性能,尤其是在资源较少的语言上。

提供机构:

莱布尼茨科学校园“实证语言学与计算语言建模”

创建时间:

2020-10-05

AI搜集汇总

数据集介绍

构建方式

X-SRL 数据集的构建方式主要分为三个步骤:首先,利用 DeepL 高质量机器翻译系统将英语 CoNLL-09 数据集中的句子翻译成德语、西班牙语和法语;其次,通过多语言 BERT 模型进行标签投影,将英语的标注信息自动映射到目标语言的句子中;最后,由人工验证测试集中的标注质量,并选择合适的谓词和目标词,以确保标注的准确性和一致性。

使用方法

X-SRL 数据集的使用方法主要包括以下几个方面:首先,可以使用该数据集进行单语和跨语言的 SRL 模型训练和评估;其次,可以利用该数据集进行 SRL 标注的自动投影,并通过人工验证测试集来评估投影的准确性;最后,可以使用该数据集来研究跨语言 SRL 的语法和语义差异,并探索 SRL 系统的性能提升方法。

背景与挑战

背景概述

语义角色标注(SRL)是自然语言处理(NLP)领域中的一个重要任务,旨在从句子中提取语义谓词-论元结构。尽管SRL已经在多种语言中得到研究,但主要的改进大多集中在英语上,因为英语拥有更多的资源。现有的多语言SRL数据集包含不同的注释风格或来自不同的领域,这阻碍了多语言学习中的泛化。在这项工作中,我们提出了一种自动构建SRL语料库的方法,该语料库在四种语言(英语、法语、德语、西班牙语)中是平行的,并且具有统一的谓词和角色注释,这些注释在语言之间是完全可比的。我们将高质量的机器翻译应用于英语CoNLL-09数据集,并使用多语言BERT将其高质量注释投射到目标语言。我们包括经过人工验证的测试集,我们使用这些测试集来衡量投影质量,并表明投影比强基线更密集、更精确。最后,我们在我们的新语料库上训练不同的SOTA模型进行单语言和多语言SRL,表明多语言注释提高了性能,特别是对于较弱的

当前挑战

尽管CoNLL-09SRL数据集已经涵盖了7种语言,但其他语言并没有得到同样的关注。这种情况可能是由于以下因素:i)缺乏足够的训练数据来成功应用一种语言不可知的DNN模型;ii)创建新的SRL数据集是资源消耗的;iii)当前的标签投影方法召回率低;最后,iv)即使在其他语言中也有可用的注释资源,通常它们是从独立的预存在注释方案自动转换的或使用自动方法标记的,导致数据质量和标记模式差异,阻碍了可以应用于多语言的统一模型的有效性。

常用场景

经典使用场景

在语义角色标注(SRL)领域,X-SRL 数据集被广泛用于训练和评估多语言 SRL 模型。该数据集包含了四个语言(英语、德语、法语和西班牙语)的平行语料库,其中包含了统一的谓词和角色标注,使得跨语言的学习和比较成为可能。X-SRL 数据集被用于训练各种最先进的 SRL 模型,包括单语言和多语言模型,以展示其在不同语言上的泛化能力。

解决学术问题

X-SRL 数据集解决了现有多语言 SRL 数据集在标注风格和领域上的不一致性,这限制了多语言学习中的泛化能力。通过自动构建一个平行语料库,并使用高质量机器翻译和多语言 BERT 进行标注投影,X-SRL 数据集提供了统一的标注方案,使得跨语言的学习和比较成为可能。此外,X-SRL 数据集还提供了人工验证的测试集,以评估标注投影的质量,并确保了 SRL 系统的可靠基准。

实际应用

X-SRL 数据集在实际应用中具有重要意义。它可以用于开发多语言的自然语言处理应用,例如机器翻译、文本摘要和信息抽取。通过训练多语言 SRL 模型,可以更好地理解不同语言之间的语义差异,并提高跨语言应用的性能。此外,X-SRL 数据集的构建方法也可以用于生成其他语言的 SRL 数据,为低资源语言的 NLP 研究和应用提供了新的可能性。

数据集最近研究

最新研究方向

X-SRL数据集的最新研究方向在于构建一个跨语言的语义角色标注数据集,以促进多语言学习中的泛化能力。该数据集通过高质量机器翻译将英语CoNLL-09数据集的标注投影到其他语言,并使用多语言BERT进行对齐,从而实现统一的语言和角色标注。研究结果表明,这种方法能够生成更密集、更精确的标注,并在多语言SRL任务中展现出良好的泛化能力。此外,该研究还探索了如何利用自动翻译和手动验证的方法创建高质量的测试集,以及如何通过BERT进行标注投影,以提高SRL系统的性能。

相关研究论文

- 1X-SRL: A Parallel Cross-Lingual Semantic Role Labeling Dataset莱布尼茨科学校园“实证语言学与计算语言建模” · 2020年

以上内容由AI搜集并总结生成