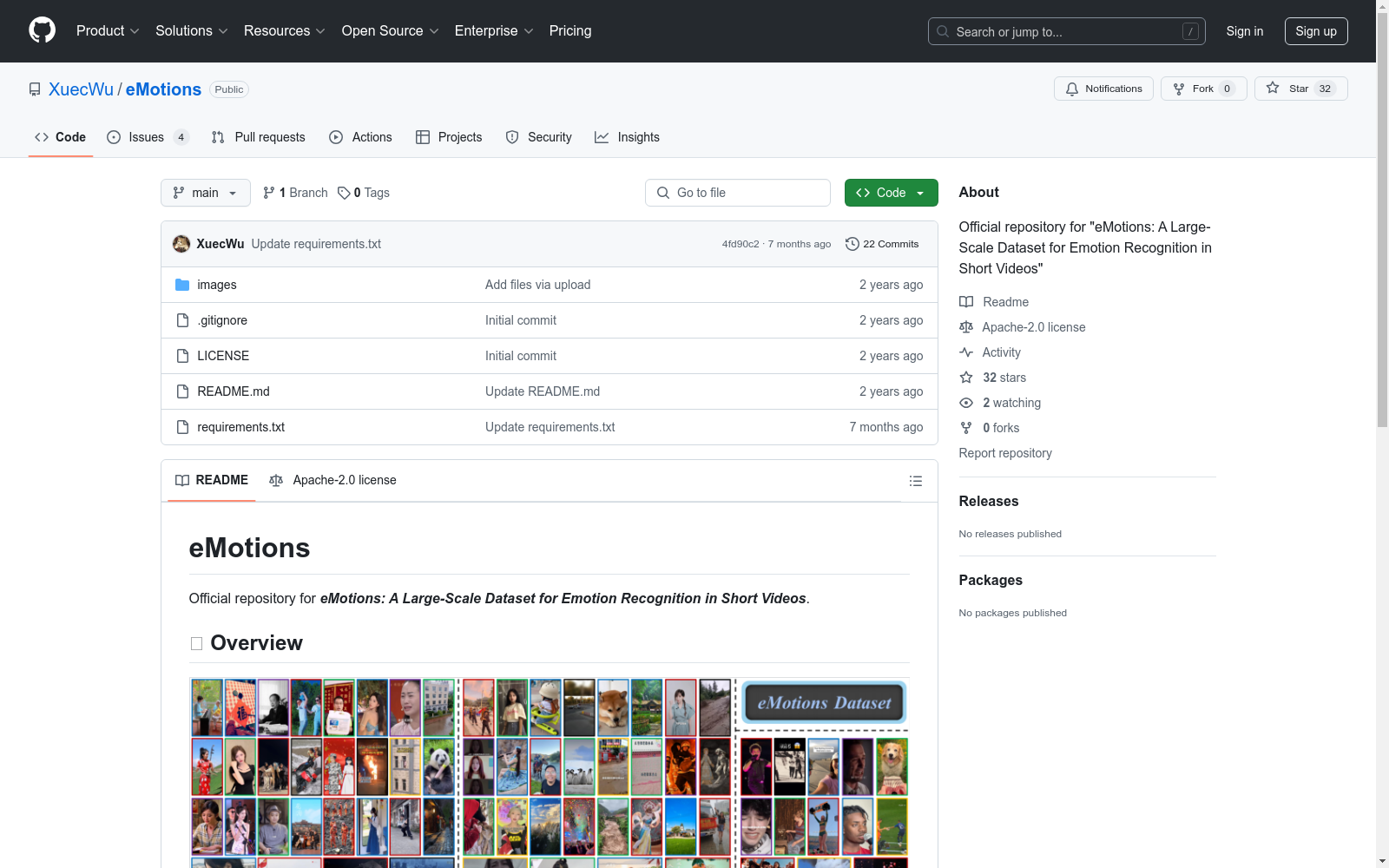

eMotions|情感识别数据集|短视频分析数据集

收藏eMotions 数据集概述

数据集特点

- 首个情感识别数据集:eMotions 是首个针对短视频(SVs)情感识别的大规模数据集。

- 高质量标注:数据集提供更可靠的情感标注,有助于推动该领域的未来研究。

- 模型开发:提出了有效的基准模型 AV-CPNet,用于短视频中的情感识别,并设计了相应的组件来互补地建模音视频相关性,利用情感极性信息指导模型优化。

- 实验验证:在九个数据集上进行了广泛的实验,验证了所提模型的优越性,并为未来的工作提供了不同方法和模态的详细见解。

使用限制

- 仅限学术研究:eMotions 及其两个变体未经允许不得转移给外部方,仅可用于学术研究目的。

- 非商业用途:不得作为任何机构商业软件包或产品的一部分。

引用信息

若您发现 eMotions 对您的研究和应用有帮助,请使用以下 BibTeX 进行引用:

bibtex @article{wu2023emotions, title={eMotions: A Large-Scale Dataset for Emotion Recognition in Short Videos}, author={Wu, Xuecheng and Sun, Heli and Xue, Junxiao and Zhai, Ruofan and Kong, Xiangyan and Nie, Jiayu and He, Liang}, journal={arXiv preprint arXiv:2311.17335}, year={2023} }

中国区域地面气象要素驱动数据集 v2.0(1951-2024)

中国区域地面气象要素驱动数据集(China Meteorological Forcing Data,以下简称 CMFD)是为支撑中国区域陆面、水文、生态等领域研究而研发的一套高精度、高分辨率、长时间序列数据产品。本页面发布的 CMFD 2.0 包含了近地面气温、气压、比湿、全风速、向下短波辐射通量、向下长波辐射通量、降水率等气象要素,时间分辨率为 3 小时,水平空间分辨率为 0.1°,时间长度为 74 年(1951~2024 年),覆盖了 70°E~140°E,15°N~55°N 空间范围内的陆地区域。CMFD 2.0 融合了欧洲中期天气预报中心 ERA5 再分析数据与气象台站观测数据,并在辐射、降水数据产品中集成了采用人工智能技术制作的 ISCCP-ITP-CNN 和 TPHiPr 数据产品,其数据精度较 CMFD 的上一代产品有显著提升。 CMFD 历经十余年的发展,其间发布了多个重要版本。2019 年发布的 CMFD 1.6 是完全采用传统数据融合技术制作的最后一个 CMFD 版本,而本次发布的 CMFD 2.0 则是 CMFD 转向人工智能技术制作的首个版本。此版本与 1.6 版具有相同的时空分辨率和基础变量集,但在其它诸多方面存在大幅改进。除集成了采用人工智能技术制作的辐射和降水数据外,在制作 CMFD 2.0 的过程中,研发团队尽可能采用单一来源的再分析数据作为输入并引入气象台站迁址信息,显著缓解了 CMFD 1.6 中因多源数据拼接和气象台站迁址而产生的虚假气候突变。同时,CMFD 2.0 数据的时间长度从 CMFD 1.6 的 40 年大幅扩展到了 74 年,并将继续向后延伸。CMFD 2.0 的网格空间范围虽然与 CMFD 1.6 相同,但其有效数据扩展到了中国之外,能够更好地支持跨境区域研究。为方便用户使用,CMFD 2.0 还在基础变量集之外提供了若干衍生变量,包括近地面相对湿度、雨雪分离降水产品等。此外,CMFD 2.0 摒弃了 CMFD 1.6 中通过 scale_factor 和 add_offset 参数将实型数据化为整型数据的压缩技术,转而直接将实型数据压缩存储于 NetCDF4 格式文件中,从而消除了用户使用数据时进行解压换算的困扰。 本数据集原定版本号为 1.7,但鉴于本数据集从输入数据到研制技术都较上一代数据产品有了大幅的改变,故将其版本号重新定义为 2.0。

国家青藏高原科学数据中心 收录

MeSH

MeSH(医学主题词表)是一个用于索引和检索生物医学文献的标准化词汇表。它包含了大量的医学术语和概念,用于描述医学文献中的主题和内容。MeSH数据集包括主题词、副主题词、树状结构、历史记录等信息,广泛应用于医学文献的分类和检索。

www.nlm.nih.gov 收录

AIS数据集

该研究使用了多个公开的AIS数据集,这些数据集经过过滤、清理和统计分析。数据集涵盖了多种类型的船舶,并提供了关于船舶位置、速度和航向的关键信息。数据集包括来自19,185艘船舶的AIS消息,总计约6.4亿条记录。

github 收录

UAVDT Dataset

The authors constructed a new UAVDT Dataset focused on complex scenarios with new level challenges. Selected from 10 hours raw videos, about 80, 000 representative frames are fully annotated with bounding boxes as well as up to 14 kinds of attributes (e.g., weather condition, flying altitude, camera view, vehicle category, and occlusion) for three fundamental computer vision tasks: object detection, single object tracking, and multiple object tracking.

datasetninja.com 收录

AgiBot World

为了进一步推动通用具身智能领域研究进展,让高质量机器人数据触手可及,作为上海模塑申城语料普惠计划中的一份子,智元机器人携手上海人工智能实验室、国家地方共建人形机器人创新中心以及上海库帕思,重磅发布全球首个基于全域真实场景、全能硬件平台、全程质量把控的百万真机数据集开源项目 AgiBot World。这一里程碑式的开源项目,旨在构建国际领先的开源技术底座,标志着具身智能领域 「ImageNet 时刻」已到来。AgiBot World 是全球首个基于全域真实场景、全能硬件平台、全程质量把控的大规模机器人数据集。相比于 Google 开源的 Open X-Embodiment 数据集,AgiBot World 的长程数据规模高出 10 倍,场景范围覆盖面扩大 100 倍,数据质量从实验室级上升到工业级标准。AgiBot World 数据集收录了八十余种日常生活中的多样化技能,从抓取、放置、推、拉等基础操作,到搅拌、折叠、熨烫等精细长程、双臂协同复杂交互,几乎涵盖了日常生活所需的绝大多数动作需求。

github 收录