zhihu_rlhf_3k|社交问答数据集|偏好数据集数据集

收藏github2024-04-10 更新2024-05-31 收录

下载链接:

https://github.com/xv44586/Chinese-instruction-datasets

下载链接

链接失效反馈资源简介:

3k+条基于知乎问答的人类偏好数据集,每个问题下给出了一对不同赞数的回答

A dataset comprising over 3,000 entries of human preference data based on Q&A from Zhihu, where each question is paired with two answers differing in the number of upvotes.

创建时间:

2023-04-25

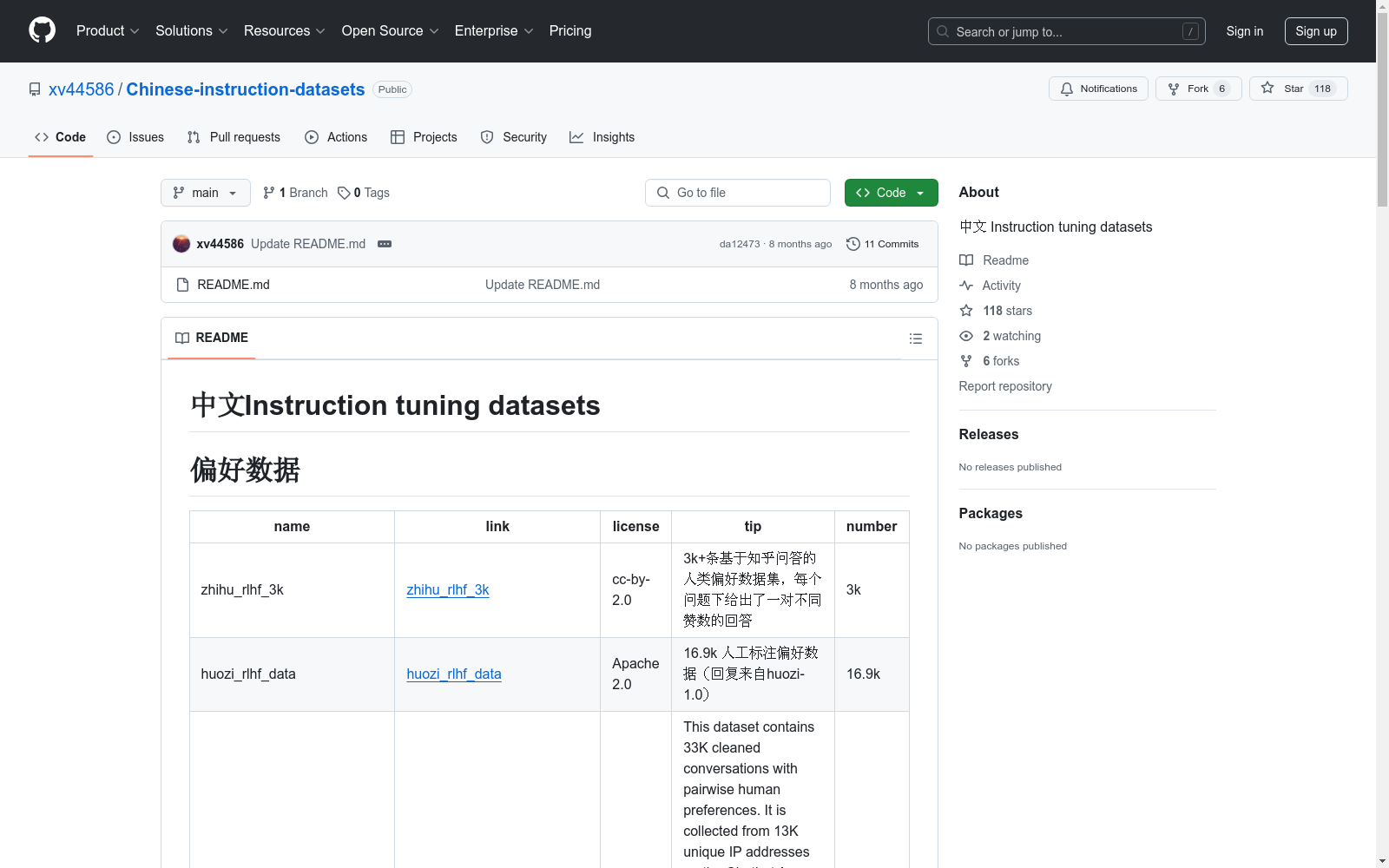

原始信息汇总

偏好数据

| 名称 | 许可证 | 描述 | 数量 |

|---|---|---|---|

| zhihu_rlhf_3k | cc-by-2.0 | 3k+条基于知乎问答的人类偏好数据集,每个问题下给出了一对不同赞数的回答 | 3k |

| huozi_rlhf_data | Apache 2.0 | 16.9k 人工标注偏好数据(回复来自huozi-1.0) | 16.9k |

| chatbot_arena_conversations | cc | 33K 清理后的对话,包含成对的人类偏好,收集自13K独特IP地址 | 33k |

人工标注

| 名称 | 许可证 | 描述 | 数量 |

|---|---|---|---|

| ruozhiba | Apache 2.0 | 受COIG-CQIA启发,构建类似数据集,答案风格更简洁 | 1.5k |

| COIG-CQIA | 开源高质量指令微调数据集,旨在为中文NLP社区提供高质量指令微调数据 | 46K | |

| OL-CC | Apache 2.0 | 以众包方式、人工生成的开源中文对话指令集,包含10k+“指令-回答”数据对 | 11.6K |

NLP 任务数据转换

| 名称 | 许可证 | 描述 | 数量 |

|---|---|---|---|

| firefly-train-1.1M | none | 23个常见中文数据集上由人工书写若干指令模板构造 | 110 万 |

| pCLUE | none | 单分类tnews/自然语言推理ocnli等9个数据集,73个prompt 转换而来 | 120 万 |

| xP3mt_zh | apache-2.0 | 原始xP3(英语)通过翻译得到的中文数据集 | 3571636 |

LLM 生成

| 名称 | 许可证 | 描述 | 数量 |

|---|---|---|---|

| alpaca_gpt4_data_zh_52k | Apache 2.0 | 由GPT-4使用中文提示生成数据 | 52k |

| alpaca_data_zh_51k | Apache 2.0 | 中文Alpaca数据,包含51k个从ChatGPT (gpt-3.5-turbo)爬取的指令数据 | 51k |

| BELLE | gpl-3.0 | 参考Stanford Alpaca生成的中文数据集 | 50万/100万/200万/1000万 |

| alpaca_chinese_dataset | MIT | 人工校验了21K左右的alpaca翻译数据集,并增加了许多中文特色数据集 | > 21 K |

| COIG | Apache 2.0/MIT/CC-BY-SA-4.0 | 包含多个子数据集,总计191,191个指令数据 | 191,191 |

| MOSS | cc-by-4.0 | moss-002-sft-data包含约59万条中文对话,moss-003-sft-data包含约110万条对话数据 | 59万/110万 |

| HC3-Chinese | cc-by-sa-4.0 | 人类-ChatGPT 对比语料 | 12853 |

| RefGPT-Fact-zh | Apache 2.0 | 包含5万个中文事实知识的多轮对话数据集 | 50k |

| Safety-Prompts | Apache 2.0 | 包含100k条中文安全场景的prompts和ChatGPT的回复 | 100k |

AI搜集汇总

数据集介绍

构建方式

zhihu_rlhf_3k数据集的构建基于知乎平台上的问答内容,通过收集3k+条具有不同赞数的人类偏好数据。每个问题下包含一对回答,这些回答根据用户的点赞数进行排序,从而形成偏好对比。数据集的构建过程中,确保了回答的多样性和质量,以反映真实用户在知乎社区中的互动行为。

特点

zhihu_rlhf_3k数据集的显著特点在于其高度聚焦于人类偏好,通过对比不同赞数的回答,能够有效捕捉用户对回答质量的直接反馈。此外,数据集的规模适中,适合用于小规模实验和模型微调,同时其内容来源于知乎这一中文社区,具有较高的语言和文化相关性。

使用方法

zhihu_rlhf_3k数据集适用于需要进行人类偏好建模和评估的自然语言处理任务,如强化学习中的奖励模型训练。用户可以通过访问提供的链接下载数据集,并将其用于模型训练、验证和测试。在使用过程中,建议结合具体的任务需求,对数据进行预处理和特征提取,以最大化数据集的价值。

背景与挑战

背景概述

zhihu_rlhf_3k数据集是由李宇成(Li Yucheng)创建,旨在为中文自然语言处理(NLP)领域提供高质量的人类偏好数据。该数据集包含了超过3000条基于知乎问答的人类偏好数据,每条数据包含一对不同赞数的回答,用于训练和评估模型在理解人类偏好方面的能力。这一数据集的创建对于推动中文NLP模型在指令微调(Instruction Tuning)和强化学习(Reinforcement Learning)中的应用具有重要意义,尤其是在理解和模拟人类偏好方面。

当前挑战

zhihu_rlhf_3k数据集在构建过程中面临的主要挑战包括数据收集的多样性和质量控制。首先,确保数据来源的多样性以覆盖广泛的用户偏好是一个重要问题。其次,数据的质量控制,包括去除噪声和确保数据的准确性,是另一个关键挑战。此外,如何在有限的资源下高效地标注和验证数据,以确保数据集的可靠性和实用性,也是该数据集面临的重要问题。这些挑战对于提升数据集的质量和应用价值至关重要。

常用场景

经典使用场景

zhihu_rlhf_3k数据集在自然语言处理领域中,主要用于训练和评估基于人类偏好的强化学习模型。该数据集通过收集知乎问答平台上用户对不同回答的点赞数,形成了一对对具有不同赞数的回答,从而为模型提供了明确的人类偏好信息。这种数据结构使得模型能够学习到在特定问题下,哪些回答更符合人类用户的偏好,进而优化其生成回答的质量。

实际应用

在实际应用中,zhihu_rlhf_3k数据集可以广泛应用于智能问答系统、聊天机器人和内容推荐系统等领域。通过利用该数据集训练的模型,能够生成更符合用户偏好的回答和推荐内容,从而提高用户体验和系统性能。例如,在智能客服系统中,模型可以根据用户的历史偏好,生成更准确和个性化的回答,提升用户满意度。

衍生相关工作

zhihu_rlhf_3k数据集的发布,激发了大量相关研究工作的开展。例如,研究人员基于该数据集开发了多种强化学习算法,以更好地捕捉和利用人类偏好信息。此外,该数据集还被用于构建和评估新的偏好学习模型,推动了自然语言处理领域在人类偏好建模方面的研究进展。同时,该数据集的成功应用也为其他领域提供了借鉴,促进了跨学科的研究合作。

以上内容由AI搜集并总结生成