NAVCON|视觉语言导航数据集|机器人导航数据集

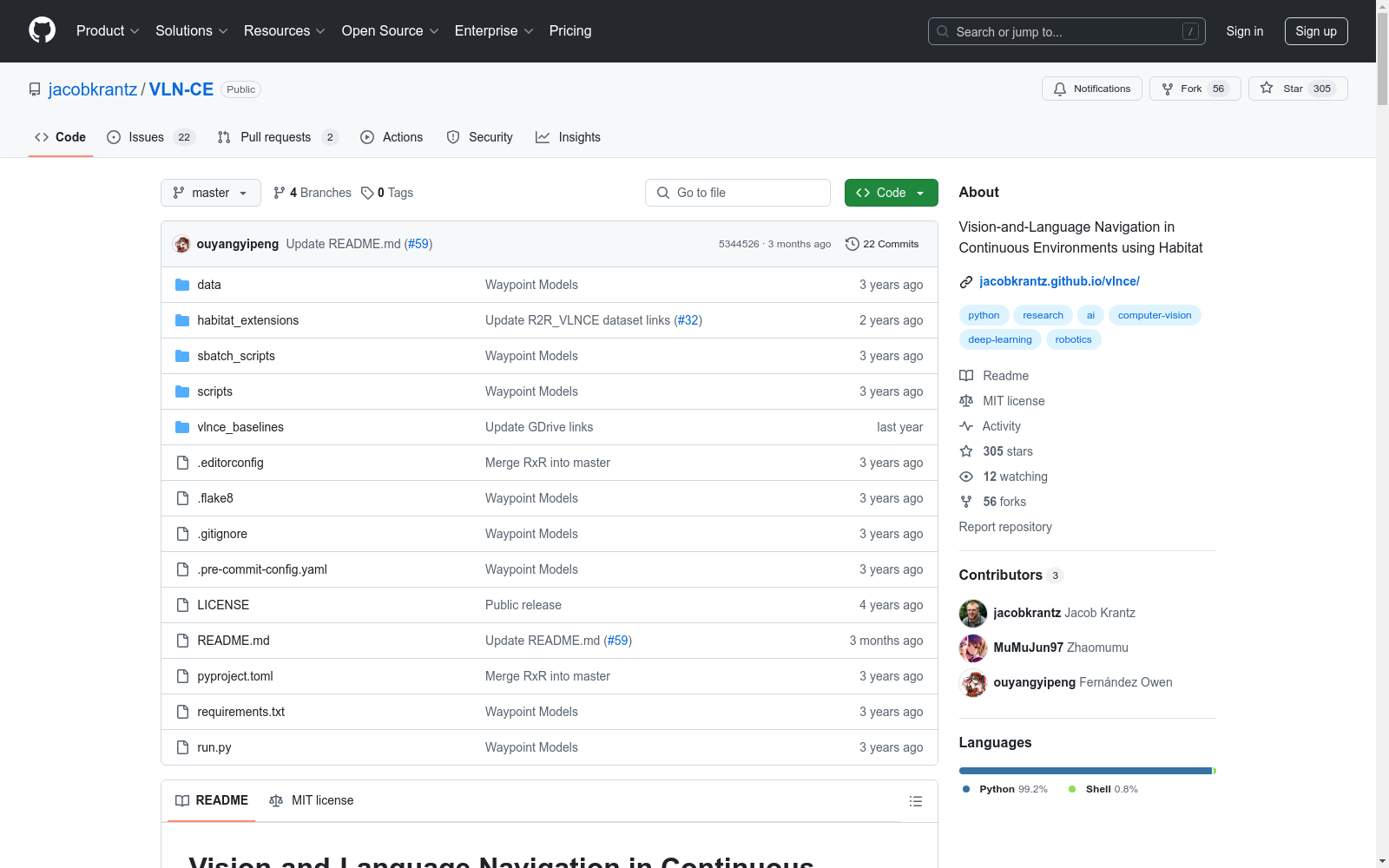

收藏Vision-and-Language Navigation in Continuous Environments (VLN-CE)

数据集概述

VLN-CE 是一个基于指令的导航任务,包含众包指令、真实环境以及不受限制的代理导航。该数据集支持 Room-to-Room (R2R) 和 Room-Across-Room (RxR) 数据集。

场景数据

- Matterport3D (MP3D):使用 Matterport3D 场景重建数据。场景数据可以通过 Matterport3D 的官方下载脚本获取,并解压到

data/scene_datasets/mp3d/{scene}/{scene}.glb路径下,共有 90 个场景。

任务数据

Room-to-Room (R2R)

- R2R_VLNCE_v1-3:R2R_VLNCE_v1-3 是 Room-to-Room (R2R) 数据集的移植版本,适用于 Matterport3DSimulator (MP3D-Sim)。数据集包含

R2R_VLNCE_v1-3和R2R_VLNCE_v1-3_preprocessed两个版本。- R2R_VLNCE_v1-3.zip:3 MB,解压路径为

data/datasets/R2R_VLNCE_v1-3。 - R2R_VLNCE_v1-3_preprocessed.zip:250 MB,解压路径为

data/datasets/R2R_VLNCE_v1-3_preprocessed。

- R2R_VLNCE_v1-3.zip:3 MB,解压路径为

Room-Across-Room (RxR)

- RxR_VLNCE_v0.zip:RxR 数据集包含多语言指令(英语、印地语、泰卢固语),路径多样,适用于连续环境。数据集包含

train、val_seen、val_unseen和test_challenge四个分割,结构如下: graphql data/datasets ├─ RxR_VLNCE_v0 | ├─ train | | ├─ train_guide.json.gz | | ├─ train_guide_gt.json.gz | | ├─ train_follower.json.gz | | ├─ train_follower_gt.json.gz | ├─ val_seen | | ├─ val_seen_guide.json.gz | | ├─ val_seen_guide_gt.json.gz | | ├─ val_seen_follower.json.gz | | ├─ val_seen_follower_gt.json.gz | ├─ val_unseen | | ├─ val_unseen_guide.json.gz | | ├─ val_unseen_guide_gt.json.gz | | ├─ val_unseen_follower.json.gz | | ├─ val_unseen_follower_gt.json.gz | ├─ test_challenge | | ├─ test_challenge_guide.json.gz | ├─ text_features | | ├─ ...

预训练模型权重

- ResNet 预训练权重:用于深度观察的 ResNet 预训练模型权重可以从 这里 下载,解压到

data/ddppo-models/{model}.pth。

数据集使用

安装依赖

- Python 3.6:建议使用 miniconda 或 anaconda 创建环境。

- Habitat-Sim 0.1.7:可以通过 conda 安装或从源码构建。

- Habitat-Lab 0.1.7:从源码安装。

数据集下载

- Matterport3D:使用

download_mp.py脚本下载场景数据。 - R2R_VLNCE_v1-3:通过

gdown命令下载。 - RxR_VLNCE_v0.zip:直接下载。

数据集结构

- R2R_VLNCE_v1-3:包含训练、验证和测试集。

- RxR_VLNCE_v0:包含多语言指令和轨迹数据。

引用

如果使用 VLN-CE 数据集,请引用以下论文:

tex @inproceedings{krantz_vlnce_2020, title={Beyond the Nav-Graph: Vision and Language Navigation in Continuous Environments}, author={Jacob Krantz and Erik Wijmans and Arjun Majundar and Dhruv Batra and Stefan Lee}, booktitle={European Conference on Computer Vision (ECCV)}, year={2020} }

如果使用 RxR-Habitat 数据,请额外引用以下论文:

tex @inproceedings{ku2020room, title={Room-Across-Room: Multilingual Vision-and-Language Navigation with Dense Spatiotemporal Grounding}, author={Ku, Alexander and Anderson, Peter and Patel, Roma and Ie, Eugene and Baldridge, Jason}, booktitle={Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP)}, pages={4392--4412}, year={2020} }

- 1NAVCON: A Cognitively Inspired and Linguistically Grounded Corpus for Vision and Language Navigation宾夕法尼亚大学 · 2024年

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

Interaction Dataset

Interaction Dataset是一个用于处理和可视化交通场景的数据集,支持轨迹预测挑战,包括三个不同的预测模型训练和测试轨道。

github 收录

paris2024-data

包含2024年巴黎奥运会和残奥会的数据集,包括奖牌列表、获奖运动员信息、国家和事件的详细数据。

github 收录

TT100K - Tsinghua-Tencent 100K

TT100K数据集是一个用于交通标志检测和识别的大规模数据集,包含100,000张标注的交通标志图像。该数据集主要用于计算机视觉和自动驾驶领域的研究。

cg.cs.tsinghua.edu.cn 收录