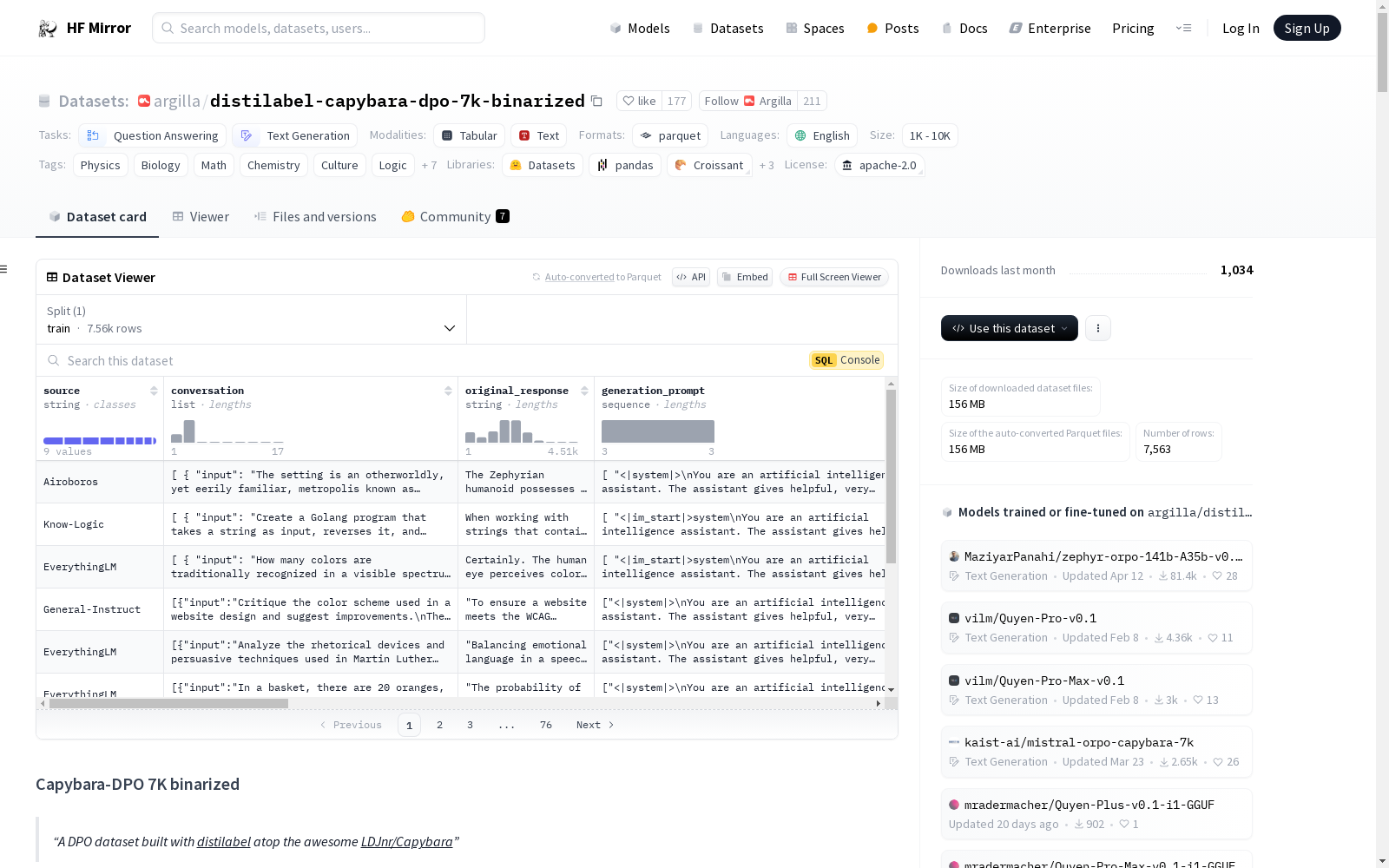

argilla/distilabel-capybara-dpo-7k-binarized|多轮对话数据集|偏好调整数据集

收藏hugging_face2024-07-16 更新2024-03-04 收录

下载链接:

https://hf-mirror.com/datasets/argilla/distilabel-capybara-dpo-7k-binarized

下载链接

链接失效反馈资源简介:

CapybaraDPO-7k是一个用于多轮对话偏好学习的数据集,旨在提升开源大型语言模型的聊天能力。数据集包含了用户和助手之间的多轮对话,每个对话的最后一条助手的回复被标记为‘chosen’或‘rejected’。数据集通过从三个不同的开源模型生成回复,并使用UltraFeedback模型进行偏好评分来构建。该数据集可以用于DPO(Direct Preference Optimization)微调,以改进模型在多轮对话中的表现。

CapybaraDPO-7k是一个用于多轮对话偏好学习的数据集,旨在提升开源大型语言模型的聊天能力。数据集包含了用户和助手之间的多轮对话,每个对话的最后一条助手的回复被标记为‘chosen’或‘rejected’。数据集通过从三个不同的开源模型生成回复,并使用UltraFeedback模型进行偏好评分来构建。该数据集可以用于DPO(Direct Preference Optimization)微调,以改进模型在多轮对话中的表现。

提供机构:

argilla

原始信息汇总

数据集概述

基本信息

- 数据集名称: CapybaraDPO-7k

- 许可证: Apache-2.0

- 语言: 英语 (en)

- 标签: Physics, Biology, Math, Chemistry, Culture, Logic, Roleplay, rlaif, rlhf, dpo, distilabel, synthetic

- 任务类别: Question-Answering, Text-Generation

- 大小范围: 1K<n<10K

数据集结构

- 特征:

- source: 字符串

- conversation:

- input: 字符串

- output: 字符串

- original_response: 字符串

- generation_prompt: 序列字符串

- raw_generation_responses: 序列字符串

- new_generations: 序列字符串

- prompt: 字符串

- chosen:

- content: 字符串

- role: 字符串

- rejected:

- content: 字符串

- role: 字符串

- rating_chosen: 整数64位

- rating_rejected: 整数64位

- chosen_model: 字符串

- rejected_model: 字符串

数据集分割

- 训练集:

- 字节数: 348791651

- 示例数: 7563

- 下载大小: 155776049

- 数据集大小: 348791651

配置

- 默认配置:

- 数据文件:

- 分割: 训练

- 路径: data/train-*

- 数据文件:

使用方法

- 数据集用途: 用于提升开源LLMs的聊天能力,特别是通过多轮对话偏好数据进行微调。

- 数据集格式: 遵循OpenAI的对话格式,包含用户和助手之间的多轮对话。

- 使用示例: 通过过滤和格式化数据,准备用于DPO微调的数据集。

构建方法

- 响应生成: 使用三种不同的开源模型生成响应。

- 偏好数据生成: 使用

UltraFeedback.for_overall_quality()模型评估响应质量。

基准测试结果

- 测试模型: CapybaraHermes-2.5-Mistral-7B

- 测试工具: MTBench, AGIEval, GPT4All, TruthfulQA, Bigbench

- 性能提升: 在MTBench Second Turn评分中表现显著提升。

AI搜集汇总

数据集介绍

构建方式

该数据集通过使用[distilabel](https://github.com/argilla-io/distilabel)工具,基于[LDJnr/Capybara](https://huggingface.co/datasets/LDJnr/Capybara)数据集构建。首先,利用三个开源的7B模型(Notus7B, NeuralBeagle, OpenHermes-2.5)生成对用户消息的响应。随后,使用distilabel的`UltraFeedback.for_overall_quality()`模型对这些响应进行质量评估,生成偏好数据集。这一过程确保了数据集的高质量和对多轮对话的适应性。

特点

该数据集的主要特点在于其多轮对话的偏好数据结构,适用于强化学习从人类反馈(RLHF)和直接偏好优化(DPO)任务。数据集包含了用户与助手之间的多轮对话,每轮对话都有多个生成的响应,并附有评分和偏好标签。此外,数据集还提供了详细的模型生成信息和原始对话内容,便于研究人员进行深入分析和模型训练。

使用方法

使用该数据集时,首先加载数据并筛选出评分较高的对话。接着,将对话格式化为适合模型输入的格式,并提取出最后一轮助手的响应作为`chosen`和`rejected`标签。最后,将处理后的数据用于DPO模型的微调。建议结合其他数据集如[dpo mix 7k](https://huggingface.co/datasets/argilla/dpo-mix-7k)以获得更好的训练效果。

背景与挑战

背景概述

在自然语言处理领域,多轮对话数据的构建与优化一直是提升聊天模型性能的关键。Capybara-DPO 7K binarized数据集由Argilla团队基于Distilabel工具构建,旨在填补开源社区中多轮对话偏好数据集的空白。该数据集的核心研究问题是如何通过多轮对话数据来提升开源语言模型的聊天能力,特别是通过直接偏好优化(DPO)和强化学习从人类反馈(RLHF)的方法。该数据集的创建不仅为开源AI社区提供了宝贵的资源,还为后续研究提供了基准,尤其是在多轮对话场景下的模型性能评估。

当前挑战

Capybara-DPO 7K binarized数据集在构建过程中面临多项挑战。首先,多轮对话数据的生成和标注需要高度的自动化和精确性,以确保数据的质量和一致性。其次,数据集的多样性要求涵盖多个领域,如物理、生物、数学等,这增加了数据收集和处理的复杂性。此外,该数据集在训练7B模型时表现出较高的学习难度,表明在模型微调过程中需要结合其他数据集以达到最佳效果。最后,数据集的评估和验证需要跨多个基准测试,以确保其在实际应用中的有效性和可靠性。

常用场景

经典使用场景

CapybaraDPO-7k数据集的经典使用场景主要集中在多轮对话模型的微调上。该数据集通过提供多轮对话中的用户与助手之间的交互,以及每个对话轮次的最佳和最差响应,帮助模型学习如何在多轮对话中生成更高质量的文本。这种数据集特别适用于开发和优化开源的大型语言模型(LLMs),尤其是在需要增强模型在复杂对话场景中的表现时。

衍生相关工作

CapybaraDPO-7k数据集的发布催生了一系列相关工作,特别是在开源对话模型的优化和评估方面。例如,基于该数据集,研究人员开发了如CapybaraHermes-2.5-Mistral-7B等模型,这些模型在多轮对话性能上表现出色。此外,该数据集还被用于构建混合数据集,如dpo-mix-7k,进一步推动了对话系统领域的研究和发展。

数据集最近研究

最新研究方向

在自然语言处理领域,Capybara-DPO 7K binarized数据集的最新研究方向主要集中在多轮对话模型的优化与评估。该数据集通过引入多轮对话的偏好数据,为开源语言模型(LLMs)的微调提供了宝贵的资源。研究者们利用此数据集进行直接偏好优化(DPO)和强化学习从人类反馈(RLHF),旨在提升模型在复杂对话场景中的表现。此外,该数据集的构建方法和评估结果也为未来多轮对话数据集的设计和应用提供了重要的参考,特别是在提升模型在多轮对话中的连贯性和用户满意度方面。

以上内容由AI搜集并总结生成