Vchitect T2V DataVerse|视频生成数据集|文本到视频数据集

收藏LiteGen 数据集概述

数据集简介

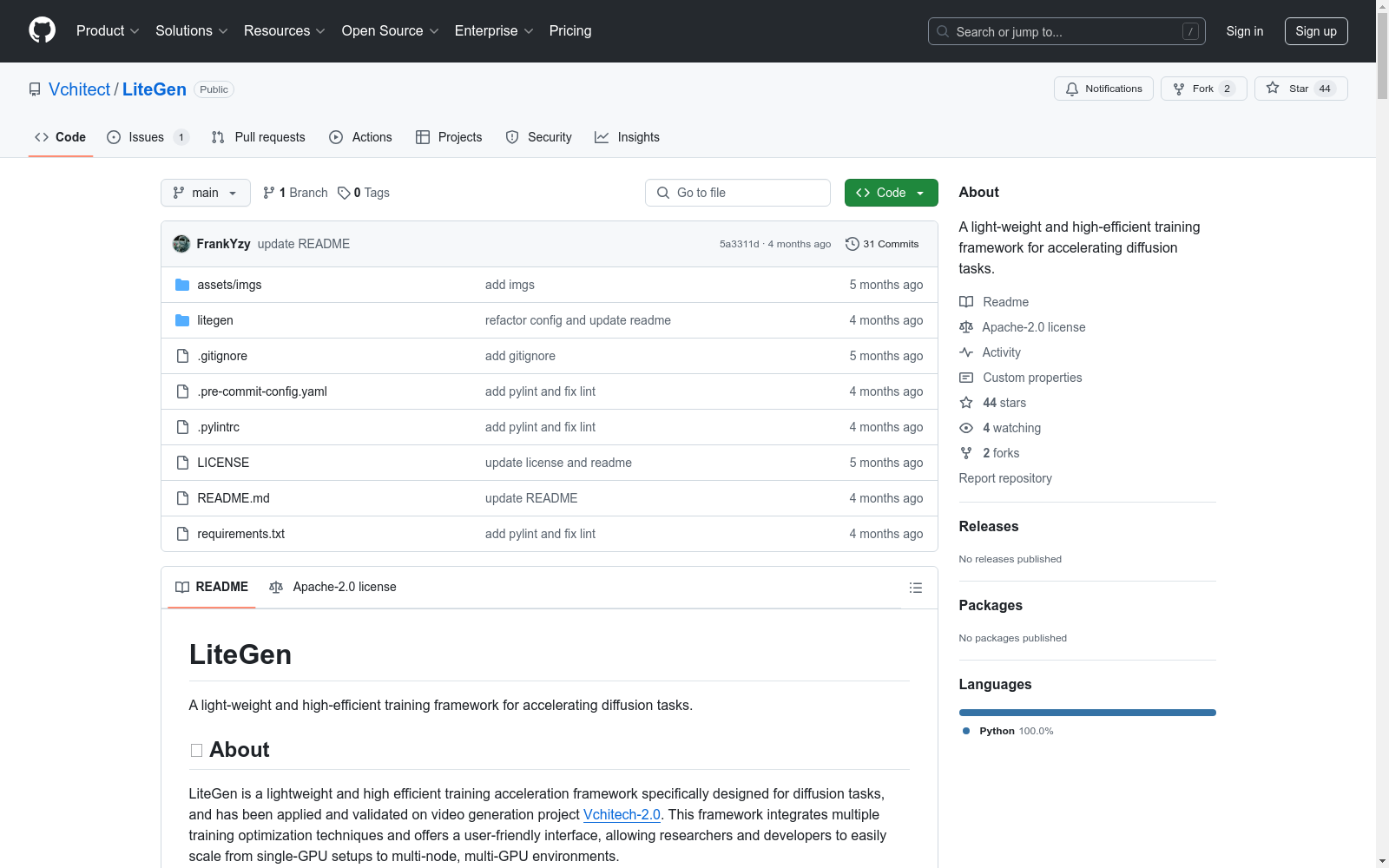

LiteGen 是一个轻量级且高效的训练加速框架,专门为扩散任务设计。该框架已在视频生成项目 Vchitech-2.0 中应用和验证。LiteGen 集成了多种训练优化技术,并提供了用户友好的接口,使研究人员和开发者能够轻松地从单 GPU 设置扩展到多节点、多 GPU 环境。

主要特性

- VAE 支持:

- DP VAE

- Sliced VAE

- VAE.encode 编译

- EMA 模型:

- 分片 EMA(指数移动平均)

- 文本编码器:

- 分片文本编码器

- 分布式优化:

- DDP

- ZeRO1,2,3

- 序列并行(Ulysses 实现,适用于 Vchitect-2.0 模型)

- 内存优化:

- 梯度激活检查点

- 选择性检查点

使用方法

快速开始指南

-

创建 LiteGen 实例: python from litegen import LiteGen gen = LiteGen(config)

-

初始化组件: python model, optimizer, text_encoder, dataloader, vae_encode = gen.initialize( model, # 可训练模型 optimizer, # 模型优化器 text_encoder, # 不可训练模型(如扩散任务中的编码器) dataset, # 数据集 vae.encode # 计算函数(如 VAE 编码) )

优化配置

- DDP 或 ZeRO 优化:

- 通过

zero_degree字段选择 DDP 或 ZeRO 阶段。

- 通过

- 选择性激活检查点:

- 通过

selective_ratio配置选择性应用激活检查点。

- 通过

- 激活卸载:

- 通过

ac_offload启用 CPU 卸载以节省 GPU 内存。

- 通过

- 序列并行:

- 通过

sp_size配置序列并行度。

- 通过

- 分片编码器:

- 通过

encoder.fsdp和encoder.group配置参数分片。

- 通过

- EMA 模型:

- 通过

ema.enable和ema.sharded配置 EMA 模型及其分片。

- 通过

性能

LiteGen 实现了序列并行和激活卸载技术,有效减少了内存使用,并支持在长序列上进行扩散任务的训练。在 NVIDIA A100 GPU 上进行的测试表明,LiteGen 支持在 8x NVIDIA A100 GPU 上训练长达 163 万个令牌的序列,相当于 760x460 分辨率的 150 秒视频。

许可证

LiteGen 采用 Apache-2.0 许可证,完全开放用于学术研究,并允许免费商业使用。如需申请商业许可证或有其他问题或合作,请联系 yangzhenyu@pjlab.org.cn。

- 1Vchitect-2.0: Parallel Transformer for Scaling Up Video Diffusion Models南洋理工大学S实验室,上海人工智能实验室,香港中文大学 · 2025年

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio 收录

Global Solar Dataset

在快速扩展的太阳能领域,找到全面的国家规模光伏(PV)数据集可能具有挑战性。资源通常分散在多个网站和API中,质量和可访问性差异显著。该仓库旨在通过将这些数据集的位置集中到一个位置来简化对这些数据集的访问,从而支持研究并促进新旧市场中太阳能预测模型的开发。

github 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

LIDC-IDRI

LIDC-IDRI 数据集包含来自四位经验丰富的胸部放射科医师的病变注释。 LIDC-IDRI 包含来自 1010 名肺部患者的 1018 份低剂量肺部 CT。

OpenDataLab 收录

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录