togethercomputer/RedPajama-Data-V2|文本处理数据集|语言模型训练数据集

收藏数据集概述

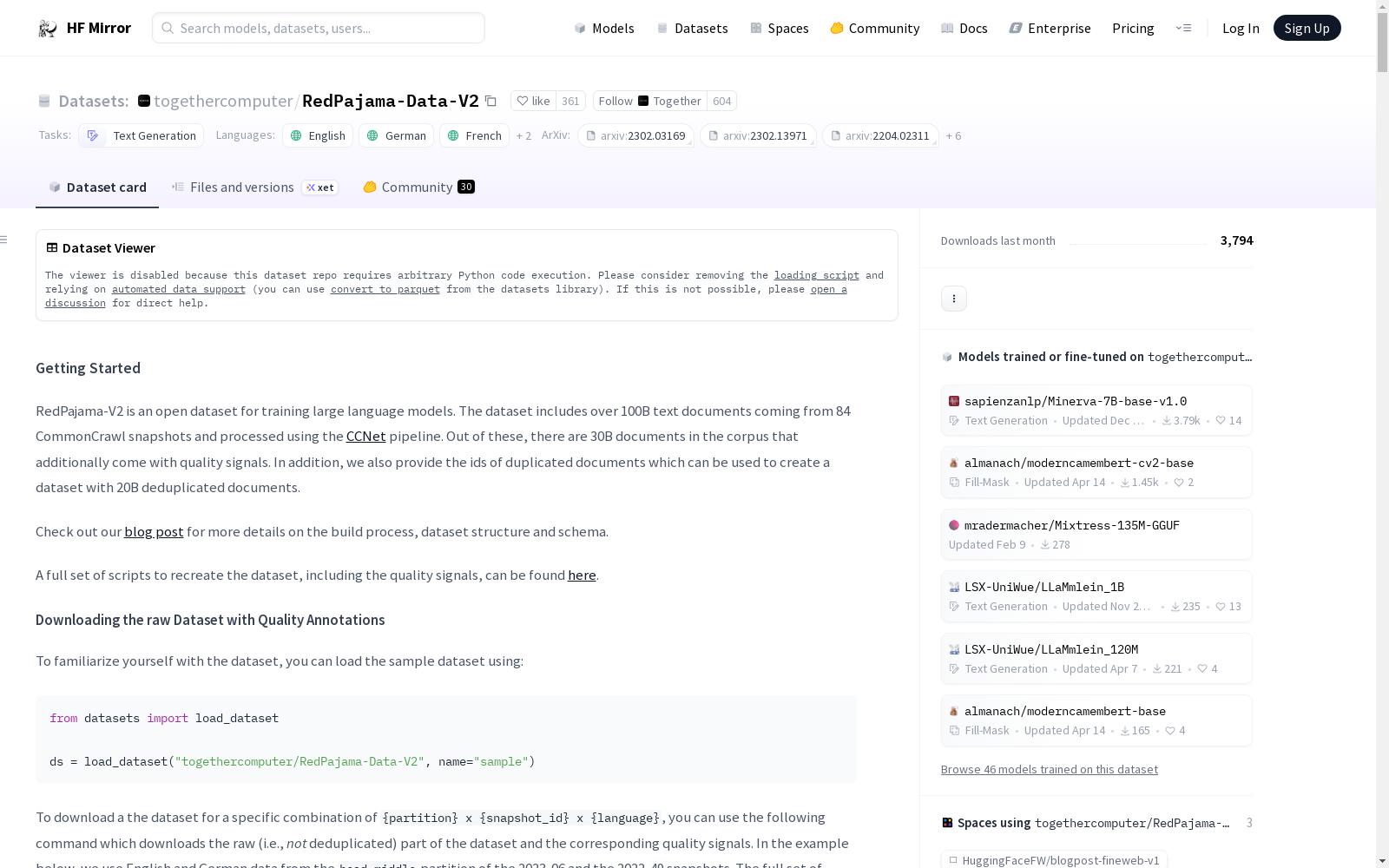

名称: Red Pajama V2 Dataset

任务类别: 文本生成

语言: 英语(en)、德语(de)、法语(fr)、西班牙语(es)、意大利语(it)

数据集大小: 包含超过1000亿文本文档,其中300亿文档带有质量信号,200亿文档为去重后的唯一文档。

数据集内容

- 来源: 来自84个CommonCrawl快照,通过CCNet管道处理。

- 质量信号: 提供文档的质量信号,用于过滤和优化数据集。

- 去重: 提供重复文档的ID,可用于创建200亿去重文档的数据集。

数据集下载

-

示例数据集: python from datasets import load_dataset ds = load_dataset("togethercomputer/RedPajama-Data-V2", name="sample")

-

特定组合数据集: python from datasets import load_dataset ds = load_dataset("togethercomputer/RedPajama-Data-V2", name="default", partition="head_middle", snapshots=["2023-06", "2022-49"], languages=["en", "de"])

-

通过wget下载: bash wget "https://data.together.xyz/redpajama-data-v2/v1.0.0/urls/document-urls.txt" -O "document-urls.txt" wget "https://data.together.xyz/redpajama-data-v2/v1.0.0/urls/quality_signals-urls.txt" -O "quality_signals-urls.txt" wget "https://data.together.xyz/redpajama-data-v2/v1.0.0/urls/duplicates-urls.txt" -O "duplicates-urls.txt" wget "https://data.together.xyz/redpajama-data-v2/v1.0.0/urls/minhash-urls.txt" -O "minhash-urls.txt"

质量注释

| 注释标签 | 描述 | 类别 | 参考 |

|---|---|---|---|

| ccnet_bucket | 困惑度得分的头部、中部或尾部桶 | CCNet | CCNet |

| ccnet_language_score | 语言识别模型的得分 | CCNet | CCNet |

| ccnet_length | 字符数量 | CCNet | CCNet |

| ccnet_nlines | 行数 | CCNet | CCNet |

| ccnet_original_length | 行级去重前的字符数量 | CCNet | CCNet |

| ccnet_original_nlines | 行级去重前的行数 | CCNet | CCNet |

| ccnet_perplexity | 基于维基百科训练的语言模型的困惑度 | CCNet | CCNet |

| rps_doc_books_importance | 基于书籍的{1,2}-词组模型与源域模型之间的文档比率的对数 | ML Heuristics | Importance Resampling (Xie et al.) |

| rps_doc_openwebtext_importance | 基于OpenWebText的{1,2}-词组模型与源域模型之间的文档比率的对数 | ML Heuristics | Importance Resampling (Xie et al.) |

| rps_doc_wikipedia_importance | 基于维基百科文章的{1,2}-词组模型与源域模型之间的文档比率的对数 | ML Heuristics | Importance Resampling (Xie et al.) |

| rps_doc_ml_wikiref_score | 文档为维基百科参考的Fasttext分类器预测 | ML Heuristics | LLaMA, RedPajama-1T |

| rps_doc_ml_palm_score | 文档为维基百科文章、OpenWebText样本或RedPajama-V1书籍的Fasttext分类器预测 | ML Heuristics | PALM, GLaM |

| rps_doc_ml_wikipedia_score | 文档为维基百科文章的Fasttext分类器预测(非英语数据) | ML Heuristics | - |

| rps_doc_curly_bracket | 原始文本中{或}的出现次数与字符总数的比率 | Natural Language | C4 |

| rps_doc_frac_all_caps_words | 内容中仅包含大写字母的单词的比例 | Natural Language | Pretrainer’s Guide |

| rps_doc_frac_lines_end_with_ellipsis | 以省略号结尾的行的比例,省略号定义为"..."或"…" | Natural Language | RefinedWeb, Gopher |

| rps_doc_frac_no_alph_words | 不包含字母字符的单词的比例 | Natural Language | RefinedWeb, Gopher |

| rps_doc_lorem_ipsum | 规范化后内容中lorem ipsum的出现次数与字符总数的比率 | Natural Language | C4 |

| rps_doc_mean_word_length | 规范化后内容中单词的平均长度 | Natural Language | RefinedWeb, Gopher |

| rps_doc_stop_word_fraction | 文档中停用词与总词数的比率 | Natural Language | Pretrainer’s Guide |

网易云音乐数据集

该数据集包含了网易云音乐平台上的歌手信息、歌曲信息和歌单信息,数据通过爬虫技术获取并整理成CSV格式,用于音乐数据挖掘和推荐系统构建。

github 收录

Beijing Traffic

The Beijing Traffic Dataset collects traffic speeds at 5-minute granularity for 3126 roadway segments in Beijing between 2022/05/12 and 2022/07/25.

Papers with Code 收录

CHARLS

中国健康与养老追踪调查(CHARLS)数据集,旨在收集反映中国45岁及以上中老年人家庭和个人的高质量微观数据,用以分析人口老龄化问题,内容包括健康状况、经济状况、家庭结构和社会支持等。

charls.pku.edu.cn 收录

OpenSonarDatasets

OpenSonarDatasets是一个致力于整合开放源代码声纳数据集的仓库,旨在为水下研究和开发提供便利。该仓库鼓励研究人员扩展当前的数据集集合,以增加开放源代码声纳数据集的可见性,并提供一个更容易查找和比较数据集的方式。

github 收录

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录