chatgpt-corpus|自然语言处理数据集|数据训练数据集

收藏数据集概述

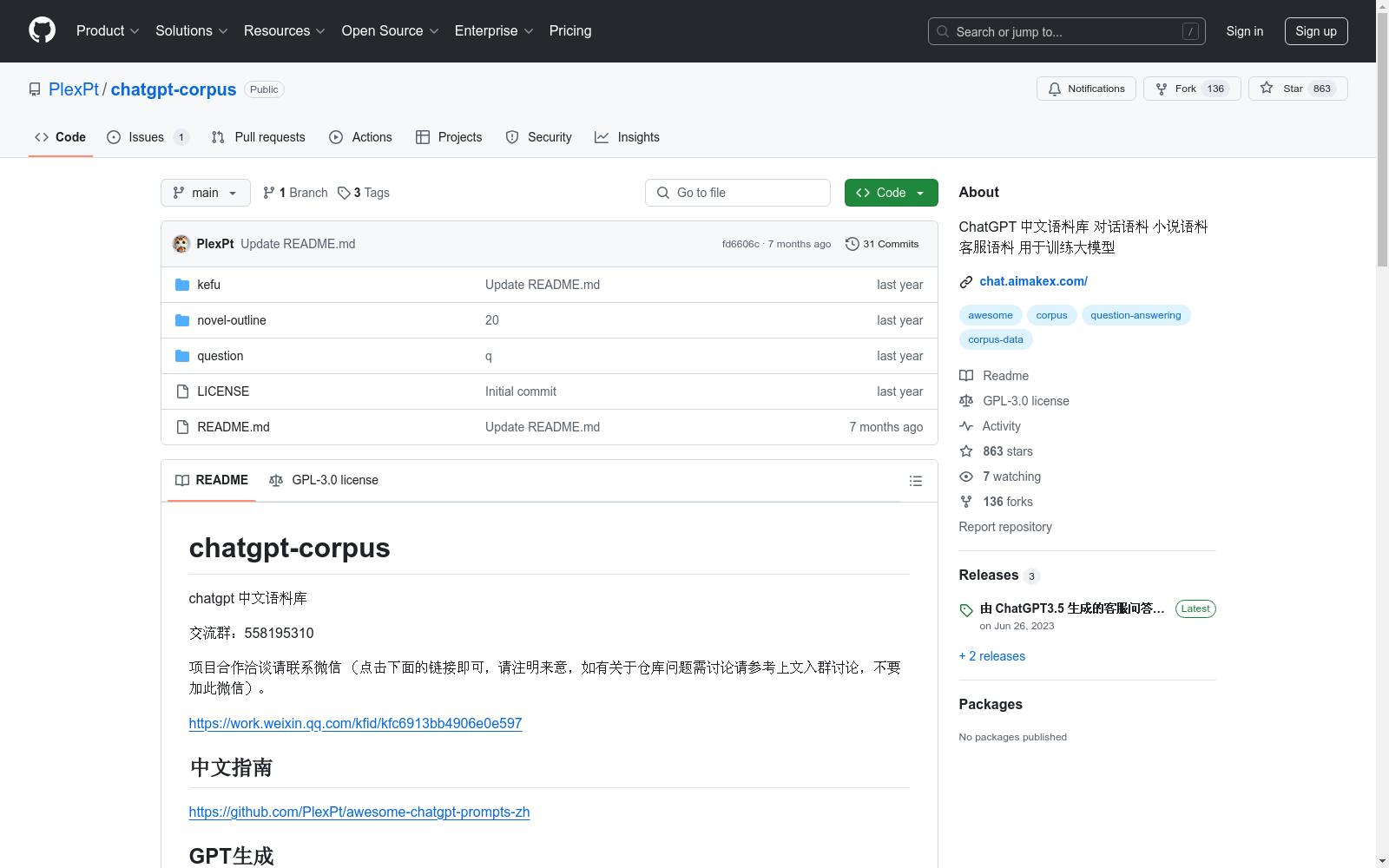

1. 数据集名称

- chatgpt-corpus

2. 数据集内容

- GPT生成问题表:由ChatGPT3.5生成,包含约67万个中文问题。

- 300万GPT3.5自问自答数据:下载地址为https://github.com/PlexPt/chatgpt-corpus/releases/tag/3。

- 客服语料:由ChatGPT3.5生成的客服问答,总数约200万条,预览和下载地址为https://github.com/PlexPt/chatgpt-corpus/tree/main/kefu。

- ChatGPT3.5生成的小说和小说大纲:

3. 数据集用途

- 主要用于中文语料的训练和研究,特别是用于“炼丹”(机器学习模型的训练)。

4. 数据集更新状态

- 更多语料正在清洗中,未来将进行更新。

OpenPose

OpenPose数据集包含人体姿态估计的相关数据,主要用于训练和评估人体姿态检测算法。数据集包括多视角的图像和视频,标注了人体关键点位置,适用于研究人体姿态识别和动作分析。

github.com 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录

HIT-UAV

HIT-UAV数据集包含2898张红外热成像图像,这些图像从43,470帧无人机拍摄的画面中提取。数据集涵盖了多种场景,如学校、停车场、道路和游乐场,在不同的光照条件下,包括白天和夜晚。

github 收录

DAT

DAT是一个统一的跨场景跨领域基准,用于开放世界无人机主动跟踪。它提供了24个视觉复杂的场景,以评估算法的跨场景和跨领域泛化能力,并具有高保真度的现实机器人动力学建模。

github 收录

专精特新“小巨人”合肥企业名单(第一批~第四批)

根据工信部的定义,专精特新“小巨人”企业是“专精特新”中小企业中的佼佼者,是专注于细分市场、创新能力强、市场占有率高、掌握关键核心技术、质量效益优的排头兵企业。 截止第四批,目前,全市“小巨人”企业总数达140户,占全国的1.6%,在全国城市及省会城市排名各进一位,位居全国城市第十四,省会城市第五。 2022 年 6 月,合肥市发布《专精特新中小企业倍增培育行动计划》,到2025年,合肥计划培育省级专精特新冠军企业和国家级专精特新“小巨人”企业300家,推动50家专精特新中小企业上市挂牌。接下来,合肥还将支持地方国有金融机构设立专精特新专项融资产品,力争每条产业链培育一批国家级专精特新“小巨人”企业。

合肥数据要素流通平台 收录