InternVid - 高质量大规模视频-文本数据集|视频-文本数据集数据集|多模态学习数据集

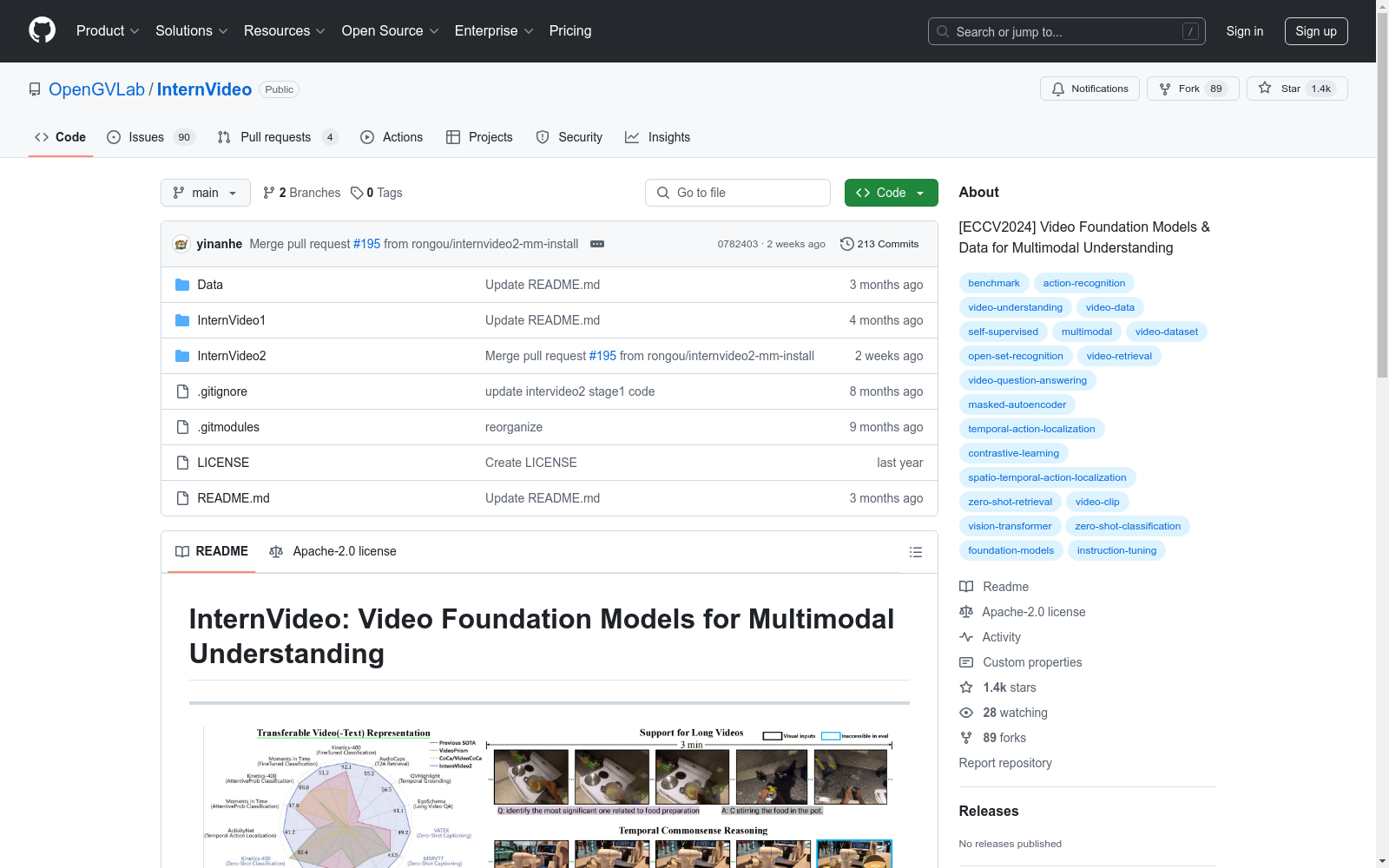

收藏InternVideo: 视频基础模型用于多模态理解

数据集概述

- InternVideo: 通过生成和判别学习实现的通用视频基础模型。

- InternVideo2: 用于多模态视频理解的大规模视频基础模型。

- InternVid: 用于多模态理解和生成的大规模视频-文本数据集。

更新记录

2024.07: 发布了InternVid2的视频标注数据集(HuggingFace)。2024.06: 发布了InternVid的完整视频标注数据集(2.3亿视频-文本对)(OpenDataLab | HuggingFace)。2024.04: 发布了InternVideo2的模型检查点和脚本(HuggingFace)。2024.03: 发布了InternVideo2的技术报告(arXiv)。2024.01: InternVid数据集被接受为ICLR 2024的亮点展示。2023.07: 发布了用于促进多模态理解和生成的视频-文本数据集InternVid(Data/InternVid)。2023.05: 发布了用于调优端到端视频为中心的多模态对话系统的视频指令数据(Data/instruction_data)。2023.01: 发布了InternVideo的代码和模型(InternVideo1)。2022.12: 发布了InternVideo的技术报告(arXiv)。

联系信息

- 如有任何问题或建议,欢迎加入我们的微信群讨论。

- 如果您对在上海人工智能实验室的通用视觉组工作感兴趣,请联系Yi Wang (wangyi@pjlab.org.cn)。

CatMeows

该数据集包含440个声音样本,由21只属于两个品种(缅因州库恩猫和欧洲短毛猫)的猫在三种不同情境下发出的喵声组成。这些情境包括刷毛、在陌生环境中隔离和等待食物。每个声音文件都遵循特定的命名约定,包含猫的唯一ID、品种、性别、猫主人的唯一ID、录音场次和发声计数。此外,还有一个额外的zip文件,包含被排除的录音(非喵声)和未剪辑的连续发声序列。

huggingface 收录

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

中国区域环境数据库

该数据集包含中国各区域的环境数据,涵盖空气质量、水质、土壤污染等多个方面的指标。数据以时间序列的形式记录,便于进行长期的环境变化分析。

www.mee.gov.cn 收录

Beijing Traffic

The Beijing Traffic Dataset collects traffic speeds at 5-minute granularity for 3126 roadway segments in Beijing between 2022/05/12 and 2022/07/25.

Papers with Code 收录