dclm-baseline-1.0-parquet|预训练数据集数据集|自然语言处理数据集

收藏huggingface2024-07-02 更新2024-12-12 收录

下载链接:

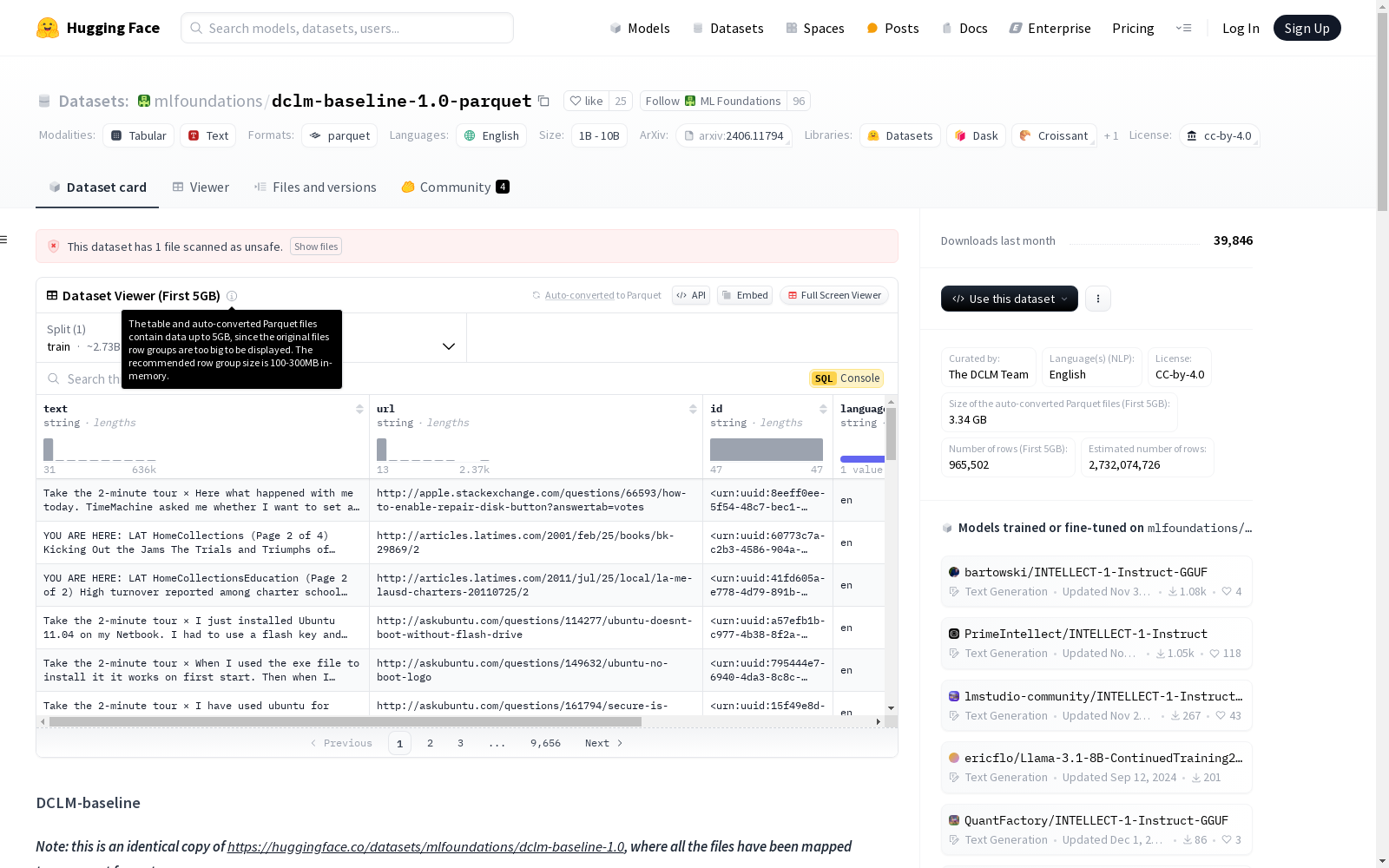

https://huggingface.co/datasets/mlfoundations/dclm-baseline-1.0-parquet

下载链接

链接失效反馈资源简介:

DCLM-baseline 是一个包含4万亿个标记和30亿个文档的预训练数据集,由DCLM团队精心策划,使用英语,并根据CC-by-4.0许可证发布。该数据集源自Common Crawl,经过一系列清洗、过滤和去重步骤处理,特别适用于作为DCLM基准的研究基线。

创建时间:

2024-07-01

原始信息汇总

数据集概述

基本信息

- 名称: DCLM-baseline

- 语言: 英语

- 许可: CC-by-4.0

- 大小: 4T token / 3B document

数据集描述

DCLM-baseline 是一个用于预训练语言模型的大型数据集,包含4万亿个token和30亿个文档,旨在为语言模型基准测试提供强大的性能。

数据集来源

- 团队: DCLM Team

- 来源: Common Crawl

- 论文: DataComp-LM: In search of the next generation of training sets for language models

- 代码: GitHub

使用场景

- 直接使用: 作为DCLM基准测试的研究基线,展示数据筛选在训练高性能语言模型中的重要性。

- 非适用场景: 不适用于训练生产就绪模型或特定领域(如代码和数学)的模型。

数据集创建

- 创建目的: 展示DCLM测试床在开发高质量训练集方面的有效性,作为数据筛选策略的证明。

- 数据处理: 通过一系列清洗、过滤和去重步骤从原始Common Crawl数据(DCLM-Pool)中创建。

偏见、风险和限制

数据集可能包含Common Crawl数据中的偏见,且在代码和数学任务上的表现有限。仅适用于研究目的。

引用

bibtex @misc{li2024datacomplm, title={DataComp-LM: In search of the next generation of training sets for language models}, author={Jeffrey Li and others}, year={2024}, eprint={2406.11794}, archivePrefix={arXiv}, primaryClass={cs.LG} }

AI搜集汇总

数据集介绍

构建方式

DCLM-baseline数据集是通过对Common Crawl原始数据进行一系列清洗、过滤和去重步骤构建而成。具体步骤包括启发式清洗和过滤、使用Bloom过滤器进行去重,以及基于fastText分类器的模型过滤。这些步骤旨在提升数据质量,确保数据集适用于语言模型的训练与研究。

特点

DCLM-baseline数据集包含4万亿个标记和30亿个文档,旨在为语言模型基准测试提供高质量的训练数据。其特点在于通过严格的数据筛选和去重策略,显著提升了数据的纯净度和多样性,使其在语言理解任务中表现出色。此外,该数据集以开放许可发布,支持研究社区的自由使用与探索。

使用方法

DCLM-baseline数据集主要用于语言模型的研究与基准测试,特别适合用于验证数据筛选策略对模型性能的影响。用户可通过Hugging Face平台直接访问该数据集,并利用其进行模型训练与评估。需要注意的是,该数据集不适用于生产级模型的训练,也不推荐用于特定领域(如代码和数学)的任务。

背景与挑战

背景概述

DCLM-baseline数据集由DCLM团队于2024年创建,旨在为语言模型训练提供一个高质量的研究基准。该数据集基于Common Crawl的原始数据,经过一系列清洗、过滤和去重处理,最终生成了包含4万亿个标记和30亿个文档的预训练数据集。DCLM-baseline的构建展示了数据筛选策略在提升语言模型性能中的重要性,并为DCLM基准测试提供了一个强有力的研究工具。该数据集的出现推动了语言模型训练数据的标准化和优化,尤其是在开放数据集与封闭数据集的性能对比研究中,DCLM-baseline为学术界提供了重要的参考依据。

当前挑战

DCLM-baseline数据集在构建过程中面临多重挑战。首先,数据清洗和过滤的复杂性极高,需要设计高效的启发式方法和模型驱动的筛选策略,以确保数据质量。其次,去重处理需要借助Bloom过滤器等技术,以应对海量数据的存储和计算压力。此外,数据集可能继承了Common Crawl中的偏见,这对模型的公平性和泛化能力提出了挑战。在应用层面,DCLM-baseline虽然在语言理解任务上表现优异,但在代码和数学等特定领域的性能有限,这限制了其在实际生产环境中的应用范围。因此,该数据集主要适用于研究场景,而非直接用于生产模型的训练。

常用场景

经典使用场景

DCLM-baseline数据集在自然语言处理领域中被广泛用于语言模型的预训练和基准测试。其庞大的数据规模和高质量的数据筛选机制,使其成为评估和比较不同语言模型性能的理想选择。研究人员可以通过该数据集验证模型在语言理解、生成和推理任务中的表现,从而推动语言模型技术的发展。

衍生相关工作

DCLM-baseline数据集催生了一系列相关研究工作,特别是在语言模型训练数据集的优化和评估方面。例如,基于该数据集的研究提出了新的数据筛选和去重策略,进一步提升了模型性能。此外,该数据集还被用于探索多模态语言模型的训练方法,为未来语言模型的发展提供了新的研究方向。

数据集最近研究

最新研究方向

在自然语言处理领域,DCLM-baseline数据集的最新研究方向聚焦于如何通过高效的数据筛选和去重策略,提升大规模语言模型的预训练效果。该数据集通过从Common Crawl中提取并经过多步清洗、过滤和去重处理,形成了一个包含4万亿标记和30亿文档的高质量预训练数据集。研究表明,基于DCLM-baseline训练的模型在多个基准测试中表现出色,尤其是在CORE、MMLU和EXTENDED等任务上,显著优于其他开放数据集训练的模型。这一成果不仅验证了数据质量对模型性能的关键影响,也为未来语言模型的训练数据优化提供了新的思路。此外,DCLM-baseline的开源特性使其成为研究社区中的重要资源,推动了开放数据与开放模型的发展趋势。

以上内容由AI搜集并总结生成