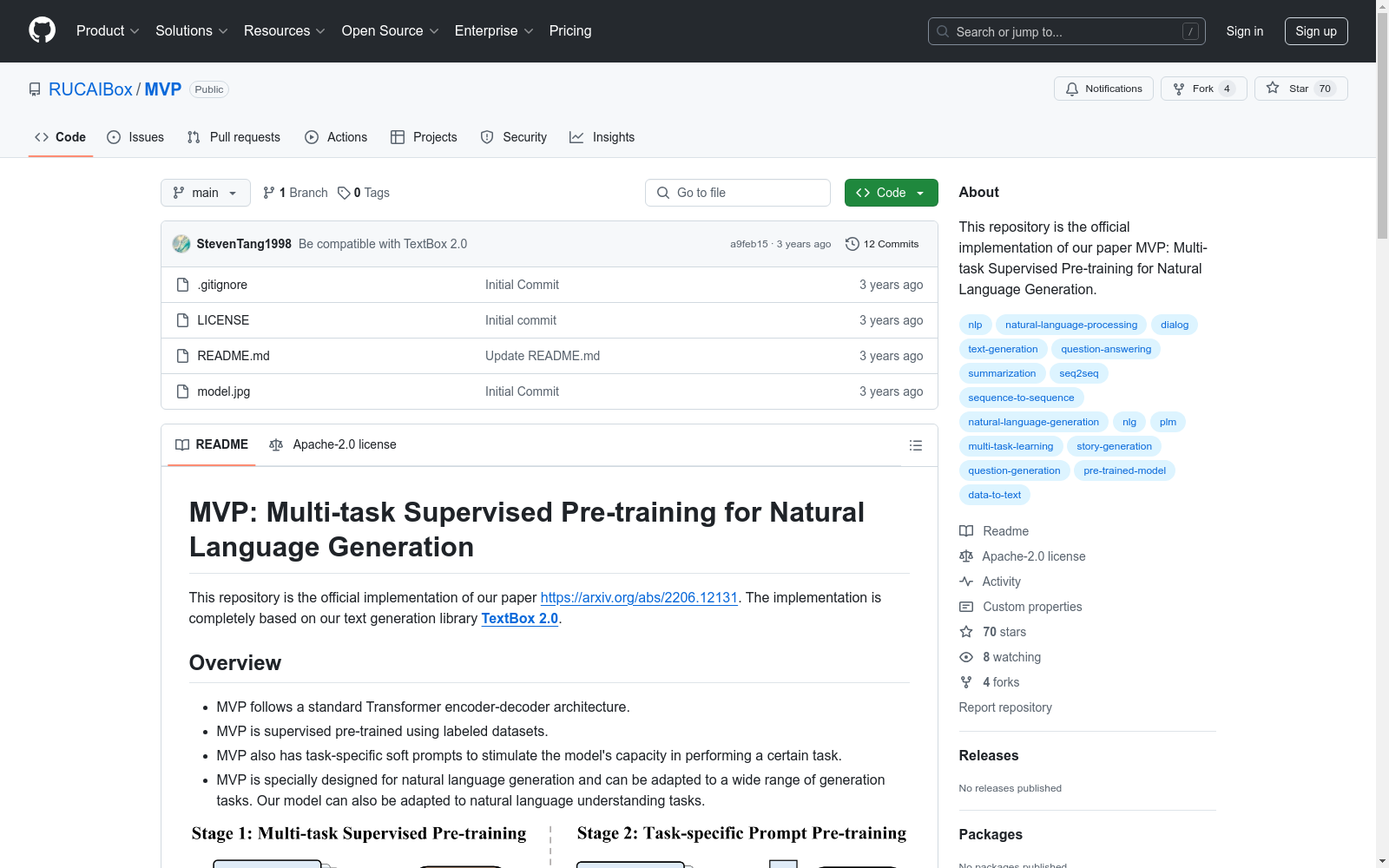

MVPCorpus|自然语言生成数据集|多任务学习数据集

收藏MVP数据集概述

数据集基本信息

- 名称:MVP (Multi-task Supervised Pre-training for Natural Language Generation)

- 架构:标准Transformer编码器-解码器结构

- 类型:监督预训练自然语言生成模型

- 特色:包含任务特定软提示(prompt)设计

支持任务与对应数据集

文本摘要

- CNN/Daily Mail (cnndm)

- XSum (xsum)

- SAMSum (samsum)

- WLE (wle)

开放式对话系统

- PersonaChat (pc)

- DailyDialog (dd)

- DSTC7-AVSD (da)

- SGD (sgd)

数据到文本生成

- WebNLG v2.1 (webnlg)

- WebNLG v3.0 (webnlg2)

- WikiBio (wikibio)

- E2E (e2e)

- DART (dart)

- ToTTo (totto)

问题生成

- SQuAD (squadqg)

- CoQA (coqaqg)

故事生成

- ROCStories (roc)

- WritingPrompts (wp)

问答系统

- SQuAD (squad)

- CoQA (coqa)

任务导向对话系统

- MultiWOZ 2.0 (multiwoz)

常识生成

- CommonGen (cg)

文本简化

- WikiAuto + Turk/ASSET (wia)

释义生成

- Quora (quora)

文本风格转换

- GYAFC-E&M (gyafc_em)

- GYAFC-F&R (gyafc_fr)

模型获取方式

- 基础模型:

RUCAIBox/mvp - 任务特定提示模型:

RUCAIBox/mvp-[task_name] - 多任务预训练变体:

RUCAIBox/mvp-multi-task

相关资源

- 论文地址:https://arxiv.org/abs/2206.12131

- 模型仓库:https://huggingface.co/models?filter=mvp

- 数据集下载:https://huggingface.co/RUCAIBox

giovannidemuri__sharegpt-ex50000-seed5_llama8b-er-v573-seed2-hx_256_ngt0.7_tp0.9

该数据集包含了用户与助手之间的对话,其中包含两个字段:用户发言和助手回应,均为字符串类型。训练集大小为38646852字节,共有44096条对话记录。

huggingface 收录

stanford_cars

该数据集是一个包含多个汽车品牌和型号的图片数据集,每个图片样本都标记有相应的汽车品牌和型号信息。数据集适用于图像识别和分类任务,特别是汽车品牌和型号的识别。

huggingface 收录

Granary

Granary是一个包含25种欧洲语言的大规模语音识别和翻译数据集,由NVIDIA等多家机构联合创建。数据集通过伪标签技术生成,旨在解决低资源语言的语音处理问题。数据集包含约643,237.57小时的语音数据,经过精心筛选和处理,旨在提高数据质量并减少数据中的错误。该数据集可用于自动语音识别(ASR)和自动语音翻译(AST)等领域的研究,有助于提高语音模型在低资源语言上的准确性和鲁棒性。

arXiv 收录

ShapeNet

ShapeNet 是由斯坦福大学、普林斯顿大学和美国芝加哥丰田技术研究所的研究人员开发的大型 3D CAD 模型存储库。该存储库包含超过 3 亿个模型,其中 220,000 个模型被分类为使用 WordNet 上位词-下位词关系排列的 3,135 个类。 ShapeNet Parts 子集包含 31,693 个网格,分为 16 个常见对象类(即桌子、椅子、平面等)。每个形状基本事实包含 2-5 个部分(总共 50 个部分类)。

OpenDataLab 收录

Spambase

Spambase数据集是一个垃圾邮件数据集,包含57个属性和4601个实例。该数据集主要用于垃圾邮件的识别和分类。垃圾邮件的资源都来自邮件管理员和提交垃圾邮件的个人。可用于构建垃圾邮件过滤器。 该数据集由惠普实验室在1999年7月发布,马克·霍普金斯、埃里克·里伯、乔治·福尔曼和雅普·苏蒙德为主要贡献者。

OpenDataLab 收录