BERT_Journalism_Sentiment|情感分析数据集|自然语言处理数据集

收藏BERT Journalism Sentiment 数据集

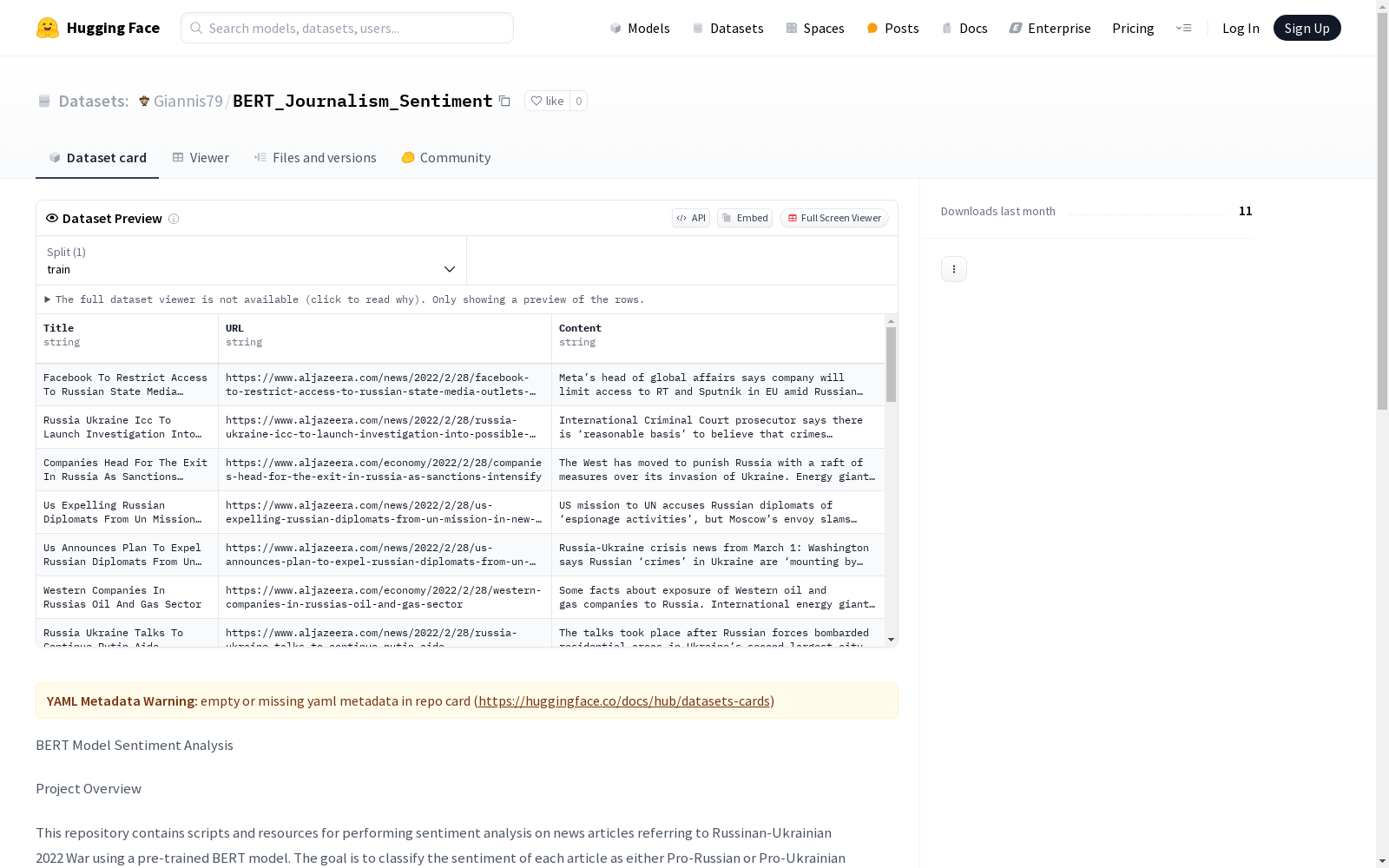

项目概述

该数据集用于对涉及2022年俄乌战争的新闻文章进行情感分析,使用预训练的BERT模型。目标是根据文章的情感将其分类为亲俄或亲乌,并计算情感得分。

数据集创建步骤

- 抓取新闻文章:使用

Python_Scraper.py脚本从网站档案中抓取新闻文章,生成一个包含标题、URL和内容的大数据集。抓取的文章标题中包含关键词"Russia"、"Ukraine"、"Zelensky"、"Putin"。 - 创建训练数据集:创建一个包含亲乌和亲俄句子的CSV文件,例如

narratives.csv,包含四列:text, label, narrative_category, message_type。 - 训练模型:使用

BERT_Trainner.py脚本基于narratives.csv训练BERT模型,生成一个AI模型。 - 评估模型效率:使用

BERT_Model_Evaluator.py脚本评估模型的情感分析效果,输出每个句子的情感得分,得分范围为0到10,0表示极端亲俄,5表示中立,10表示极端亲乌。 - 评估文章情感:使用

BERT_Article_Evaluator.py脚本评估文章的情感,生成一个包含情感、得分和月份的CSV文件。

数据集结构

- 抓取的新闻文章CSV:包含三列:Title, URL, Content。

- 训练数据集CSV:包含四列:text, label, narrative_category, message_type。

- 模型评估CSV:包含两列:pro-Ukrainian和pro-Russian的句子。

- 文章情感评估CSV:包含三列:Sentiment, Score, Month。

中国1km分辨率逐月降水量数据集(1901-2023)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2023.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

Awesome JSON Datasets

一个精选的无需认证的JSON数据集列表。

github 收录

PlantVillage

在这个数据集中,39 种不同类别的植物叶子和背景图像可用。包含 61,486 张图像的数据集。我们使用了六种不同的增强技术来增加数据集的大小。这些技术是图像翻转、伽玛校正、噪声注入、PCA 颜色增强、旋转和缩放。

OpenDataLab 收录

网易云音乐数据集

该数据集包含了网易云音乐平台上的歌手信息、歌曲信息和歌单信息,数据通过爬虫技术获取并整理成CSV格式,用于音乐数据挖掘和推荐系统构建。

github 收录