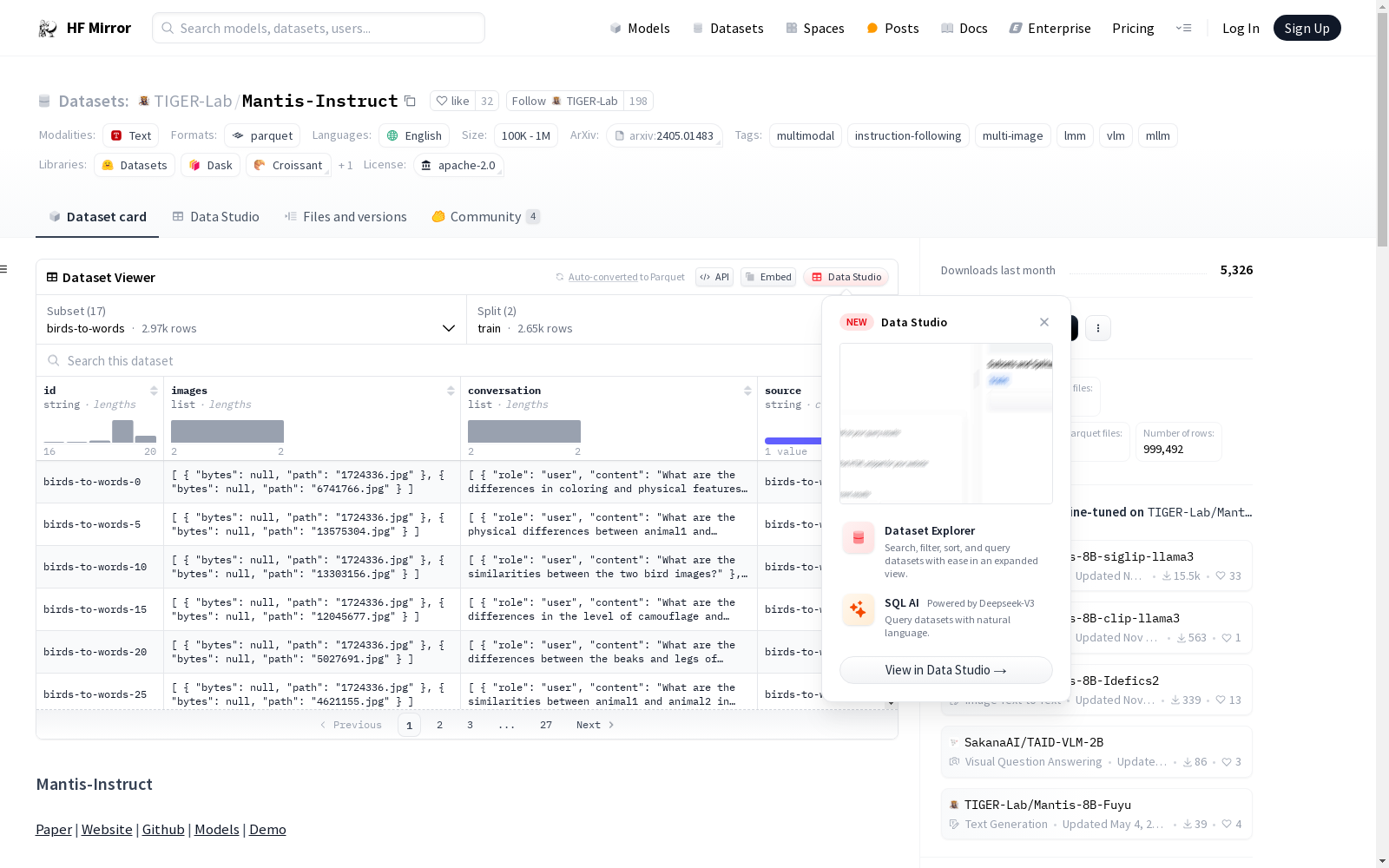

TIGER-Lab/Mantis-Instruct|多模态学习数据集|图像理解数据集

收藏数据集概述

数据集配置列表

| 配置名称 | 特征描述 | 分割信息 | 下载大小 | 数据集大小 |

|---|---|---|---|---|

| birds-to-words | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 981828 bytes, 2649 examples<br>- val: 114375 bytes, 322 examples | 2294357 | 1096203 |

| chartqa | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 4748298 bytes, 28299 examples<br>- val: 320087 bytes, 1920 examples | 2426916 | 5068385 |

| coinstruct | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 197520925 bytes, 150918 examples | 64198480 | 197520925 |

| contrastive_caption | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 134399182 bytes, 35984 examples | 64112628 | 134399182 |

| docvqa | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 6597409 bytes, 39463 examples | 2770464 | 6597409 |

| dreamsim | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 6577989 bytes, 15941 examples<br>- val: 809546 bytes, 1958 examples | 1051358 | 7387535 |

| dvqa | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 239538206 bytes, 200000 examples | 44772738 | 239538206 |

| iconqa | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 20700263 bytes, 64462 examples | 5304186 | 20700263 |

| imagecode | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 19215257 bytes, 16594 examples | 3033029 | 19215257 |

| llava_665k_multi | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 607836814 bytes, 312611 examples | 209201688 | 607836814 |

| lrv_multi | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 72060224 bytes, 8453 examples | 30088343 | 72060224 |

| nextqa | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 7539318 bytes, 3870 examples | 3445284 | 7539318 |

| nlvr2 | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 30889488 bytes, 86373 examples<br>- val: 2465147 bytes, 6982 examples | 18014755 | 33354635 |

| spot-the-diff | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 3779184 bytes, 8007 examples | 1207995 | 3779184 |

| star | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 8370531 bytes, 3032 examples | 1890570 | 8370531 |

| multi_vqa | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 24396128 bytes, 4993 examples | 10885960 | 24396128 |

| visual_story_telling | - id: string<br>- images: list<br> - bytes: binary<br> - path: string<br>- conversation: list<br> - role: string<br> - content: string<br>- source: string | - train: 18468574 bytes, 6661 examples | 8019828 | 18468574 |

数据集加载方法

-

手动下载和处理图像: python import datasets dataset = datasets.load_dataset("TIGER-Lab/Mantis-Instruct", "multi_vqa")

-

自动下载和处理图像: python import datasets dataset = datasets.load_dataset("TIGER-Lab/Mantis-Instruct", "multi_vqa", revision="script")

-

加载所有子集: python from datasets import get_dataset_config_names, load_dataset config_dataset = {} for config_name in get_dataset_config_names(): config_dataset[config_name] = load_dataset("TIGER-Lab/Mantis-Instruct", config_name)

-

自动下载所有子集: python from datasets import get_dataset_config_names, load_dataset config_dataset = {} for config_name in get_dataset_config_names(): config_dataset[config_name] = load_dataset("TIGER-Lab/Mantis-Instruct", config_name, revision="script")

BrowseComp-ZH

BrowseComp-ZH 是一个为全面评估大型语言模型(LLM)在中国网络上的浏览能力而设计的基准数据集。该数据集由289个多跳问题组成,涵盖了11个不同的领域,每个问题都经过逆向工程,从一个简短、客观且易于验证的答案(如日期、数字或专有名词)出发。为了确保问题的难度和答案的唯一性,采用了两阶段的质量控制协议。数据集旨在评估LLM在多跳检索、事实推理和在线信息整合方面的能力。数据集、构建指南和基准结果已公开发布。

arXiv 收录

中国行政区划数据

本项目为中国行政区划数据,包括省级、地级、县级、乡级和村级五级行政区划数据。数据来源于国家统计局,存储格式为sqlite3 db文件,支持直接使用数据库连接工具打开。

github 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

Materials Project

材料项目是一组标有不同属性的化合物。数据集链接: MP 2018.6.1(69,239 个材料) MP 2019.4.1(133,420 个材料)

OpenDataLab 收录

BBGRE

The Brain & Body Genetic Resource Exchange (BBGRE) provides a resource for investigating the genetic basis of neurodisability. It combines phenotype information from patients with neurodevelopmental and behavioural problems with clinical genetic data, and displays this information on the human genome map.

国家生物信息中心 收录