layoffs|裁员数据集|公司数据数据集

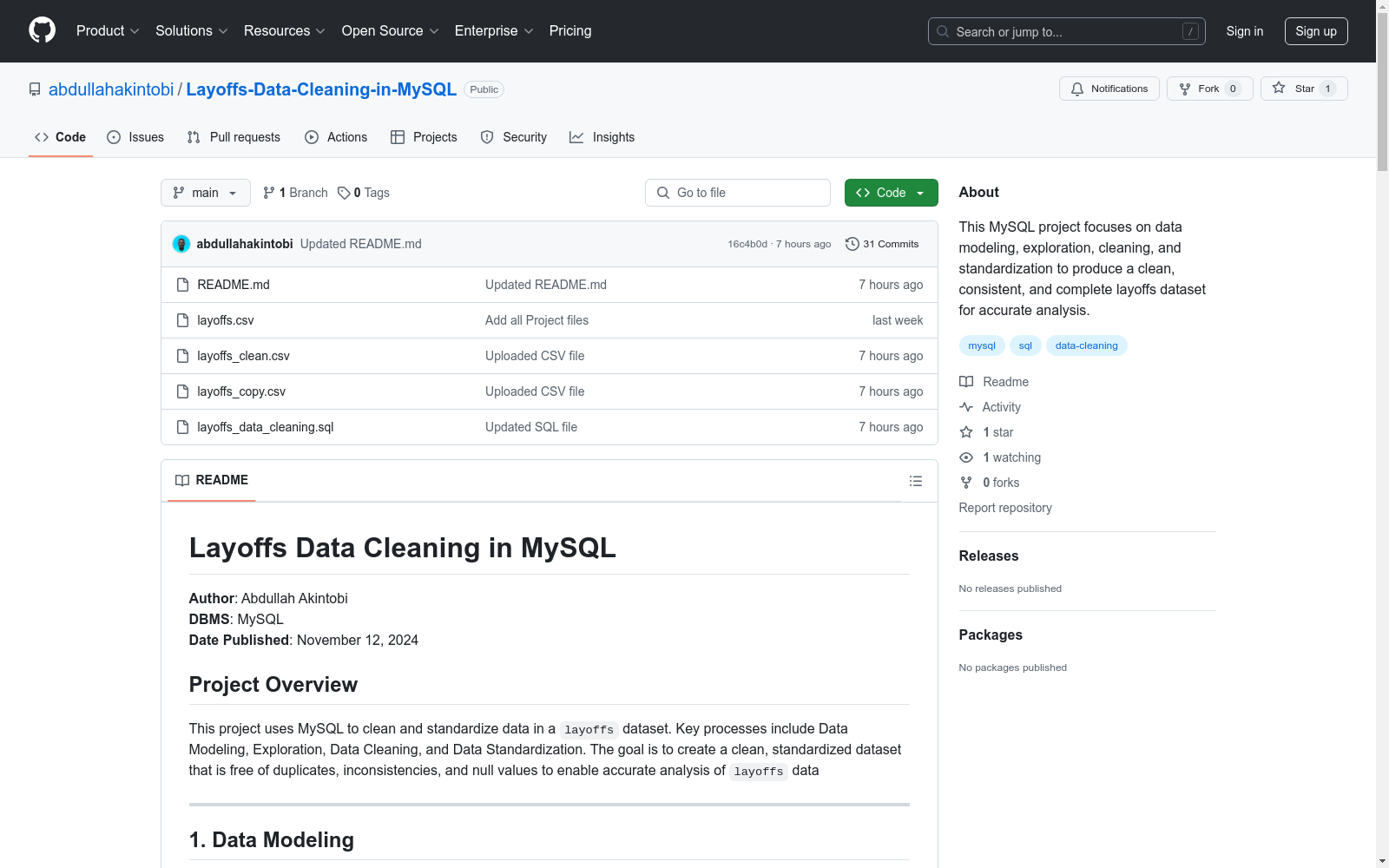

收藏Layoffs Data Cleaning in MySQL

数据集概述

作者

- 作者: Abdullah Akintobi

- 数据库管理系统: MySQL

- 发布日期: 2024年11月12日

项目目标

- 使用MySQL清理和标准化

layoffs数据集。 - 主要过程包括数据建模、数据探索、数据清理和数据标准化。

- 目标是创建一个干净、标准化的数据集,消除重复、不一致和空值,以便进行准确的裁员数据分析。

数据建模

数据库和表创建

-

数据库: 创建了一个名为

world_layoffs的专用数据库。 sql CREATE DATABASE world_layoffs; -

表结构: 创建了一个名为

layoffs的表,包含以下列:company: 公司名称location: 公司所在地industry: 行业total_laid_off: 裁员人数percentage_laid_off: 裁员百分比date: 裁员日期stage: 公司阶段country: 公司所在国家funds_raised_millions: 筹集资金(百万) sql CREATE TABLE layoffs (companyTEXT,locationTEXT,industryTEXT,total_laid_offINT DEFAULT NULL,percentage_laid_offFLOAT DEFAULT NULL,dateTEXT,stageTEXT,countryTEXT,funds_raised_millionsINT DEFAULT NULL );

-

数据备份: 在任何转换之前,将原始数据集备份到

layoffs_copy表中。 sql CREATE TABLE layoffs_copy LIKE layoffs; INSERT INTO layoffs_copy SELECT * FROM layoffs;

数据探索

基本数据洞察

-

随机样本预览: 选择10个随机行以了解数据布局。 sql SELECT * FROM layoffs_copy ORDER BY RAND() LIMIT 10;

-

行数验证: 验证总行数。 sql SELECT COUNT(*) AS row_num FROM layoffs_copy;

-

重复检查: 使用窗口函数基于关键字段识别重复行。 sql WITH duplicate AS ( SELECT *, ROW_NUMBER() OVER ( PARTITION BY

company,location,industry,total_laid_off,percentage_laid_off,date,stage,country,funds_raised_millions) AS dub_row_num FROM layoffs_copy ) SELECT * FROM duplicate WHERE dub_row_num > 1;

数据清理

重复删除和列调整

-

创建清理表: 创建新表

layoffs_clean,并添加行号以识别重复。 sql CREATE TABLE layoffs_clean AS SELECT *, ROW_NUMBER() OVER ( PARTITION BYcompany,location,industry,total_laid_off,percentage_laid_off,date,stage,country,funds_raised_millions) AS dub_row_num FROM layoffs_copy; -

删除重复记录: 删除已识别的重复记录。 sql DELETE FROM layoffs_clean WHERE dub_row_num > 1;

-

结构清理: 删除临时重复标识符列。 sql ALTER TABLE layoffs_clean DROP COLUMN dub_row_num;

数据标准化

数据一致性和空值处理

-

公司名称: 去除公司名称中的空白。 sql UPDATE layoffs_clean SET company = TRIM(company);

-

行业名称: 标准化行业分类。 sql UPDATE layoffs_clean SET industry = Crypto WHERE industry IN (Crypto Currency, CryptoCurrency);

-

国家名称: 修正国家名称格式。 sql UPDATE layoffs_clean SET country = TRIM(TRAILING . FROM country) WHERE country LIKE United States%;

-

日期格式: 标准化日期格式和数据类型。 sql UPDATE layoffs_clean SET

date= STR_TO_DATE(date, %m/%d/%Y); ALTER TABLE layoffs_clean MODIFY COLUMNdateDATE;

空值处理

-

行业空值: 将空行业值标准化为NULL,并使用公司和位置匹配填充。 sql UPDATE layoffs_clean SET industry = NULL WHERE industry = ; UPDATE layoffs_clean AS t1 INNER JOIN layoffs_clean AS t2 ON t1.company = t2.company AND t1.location = t2.location SET t1.industry = t2.industry WHERE t1.industry IS NULL AND t2.industry IS NOT NULL;

-

不完整记录: 删除缺乏必要裁员信息的记录。 sql DELETE FROM layoffs_clean WHERE total_laid_off IS NULL AND percentage_laid_off IS NULL;

总结洞察

- 数据质量: 识别并删除重复记录以确保数据完整性。

- 标准化: 实施公司名称、行业和国家的一致格式。

- 缺失数据: 制定处理关键字段中空值的策略。

- 日期格式: 将字符串日期转换为适当的日期格式以进行更好的分析。

- 数据完整性: 删除缺乏必要裁员信息的记录。

结论

- 该项目展示了在MySQL中进行数据清理的系统方法,实施了各种技术以确保数据质量和一致性。

- 清理后的数据集现在已正确结构化,可用于进一步分析,具有标准化的格式和减少的空值。

- SQL查询模块化,为类似的数据清理任务提供了可重用的框架。

UAVDT

UAVDT是一个用于目标检测任务的数据集。

github 收录

中国近海台风路径集合数据集(1945-2024)

1945-2024年度,中国近海台风路径数据集,包含每个台风的真实路径信息、台风强度、气压、中心风速、移动速度、移动方向。 数据源为获取温州台风网(http://www.wztf121.com/)的真实观测路径数据,经过处理整合后形成文件,如使用csv文件需使用文本编辑器打开浏览,否则会出现乱码,如要使用excel查看数据,请使用xlsx的格式。

国家海洋科学数据中心 收录

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

中国区域交通网络数据集

该数据集包含中国各区域的交通网络信息,包括道路、铁路、航空和水路等多种交通方式的网络结构和连接关系。数据集详细记录了各交通节点的位置、交通线路的类型、长度、容量以及相关的交通流量信息。

data.stats.gov.cn 收录

China Health and Nutrition Survey (CHNS)

China Health and Nutrition Survey(CHNS)是一项由美国北卡罗来纳大学人口中心与中国疾病预防控制中心营养与健康所合作开展的长期开放性队列研究项目,旨在评估国家和地方政府的健康、营养与家庭计划政策对人群健康和营养状况的影响,以及社会经济转型对居民健康行为和健康结果的作用。该调查覆盖中国15个省份和直辖市的约7200户家庭、超过30000名个体,采用多阶段随机抽样方法,收集了家庭、个体以及社区层面的详细数据,包括饮食、健康、经济和社会因素等信息。自2011年起,CHNS不断扩展,新增多个城市和省份,并持续完善纵向数据链接,为研究中国社会经济变化与健康营养的动态关系提供了重要的数据支持。

www.cpc.unc.edu 收录