english-word-10000|英语学习数据集|语言分析数据集

收藏数据集概述

数据集名称

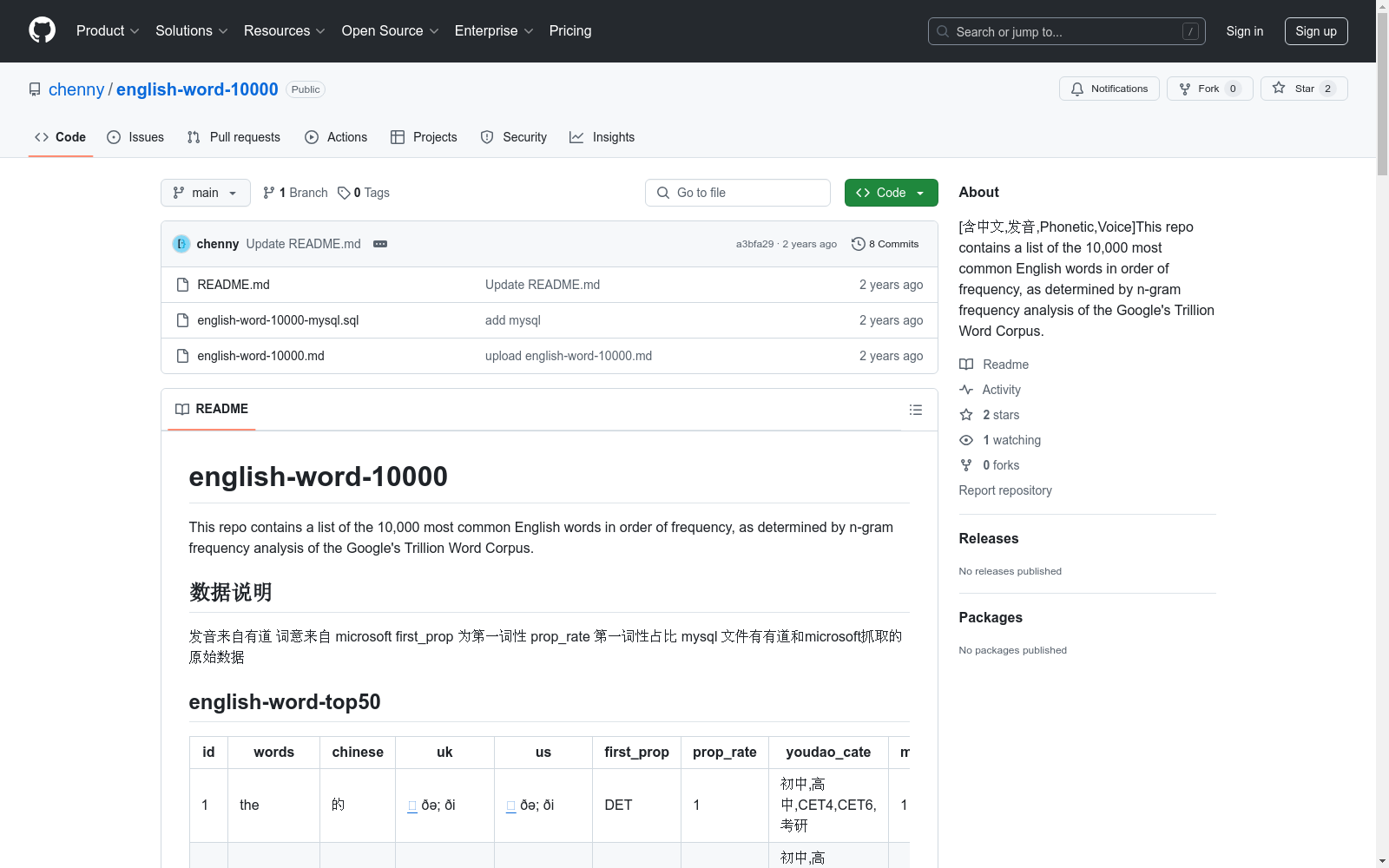

- 名称: english-word-10000

数据集内容

- 描述: 包含10,000个最常见的英语单词,按频率排序,数据来源于Google的Trillion Word Corpus的n-gram频率分析。

数据集结构

- 字段:

- id: 单词ID

- words: 英文单词

- chinese: 中文翻译

- uk: 英式发音链接

- us: 美式发音链接

- first_prop: 第一词性

- prop_rate: 第一词性占比

- youdao_cate: 有道词典分类

- means: 词意

数据来源

- 发音: 有道词典

- 词意: Microsoft

附加信息

- mysql文件: 包含从有道和Microsoft抓取的原始数据。

子数据集

- 名称: english-word-top50

- 描述: 包含前50个最常见的英语单词及其详细信息。

MeSH

MeSH(医学主题词表)是一个用于索引和检索生物医学文献的标准化词汇表。它包含了大量的医学术语和概念,用于描述医学文献中的主题和内容。MeSH数据集包括主题词、副主题词、树状结构、历史记录等信息,广泛应用于医学文献的分类和检索。

www.nlm.nih.gov 收录

RAVDESS

情感语音和歌曲 (RAVDESS) 的Ryerson视听数据库包含7,356个文件 (总大小: 24.8 GB)。该数据库包含24位专业演员 (12位女性,12位男性),以中性的北美口音发声两个词汇匹配的陈述。言语包括平静、快乐、悲伤、愤怒、恐惧、惊讶和厌恶的表情,歌曲则包含平静、快乐、悲伤、愤怒和恐惧的情绪。每个表达都是在两个情绪强度水平 (正常,强烈) 下产生的,另外还有一个中性表达。所有条件都有三种模态格式: 纯音频 (16位,48kHz .wav),音频-视频 (720p H.264,AAC 48kHz,.mp4) 和仅视频 (无声音)。注意,Actor_18没有歌曲文件。

OpenDataLab 收录

中国省级灾害统计空间分布数据集(1999-2020年)

该数据集为中国省级灾害统计空间分布数据集,时间为1999-2020年。该数据集包含中国各省自然灾害、地质灾害、地震灾害、森林火灾、森林病虫鼠害、草原灾害六类灾害的详细数据。数据量为206MB,数据格式为excel。

国家地球系统科学数据中心 收录

Subway Dataset

该数据集包含了全球多个城市的地铁系统数据,包括车站信息、线路图、列车时刻表、乘客流量等。数据集旨在帮助研究人员和开发者分析和模拟城市交通系统,优化地铁运营和乘客体验。

www.kaggle.com 收录

Simulation of rear wheel steering in a vehicle towing a single axle trailer with variable load distribution

This is the dataset for a publication on the stability of automotive vehicles when towing single axle trailers. The loading of the trailer is critical for stability, if the load distribution is too far back, then the trailer will begin to sway uncontrollably, dictating the track of the vehicle.In this research, small proportional control of the rear wheel steering of a larger towing vehicle is shown to be able to further stabilize the system easily, thus improving the safety margin. This is based on control measurements of the yaw angle, either directly measured or inferred from rear camera / parking sensor measurements.The simulation environment is Simulink and all scripts are included to initialise and plot the results. The work is based on the built in example "Two axle vehicle towing one axle trailer" with modifications to enable control algorithms for rear wheel steering control and variable load distribution. Reference for the original model is available at:T. M. Inc., Vehicle dynamics blockset version: 2.0 (r2023a) (2022). https://www.mathworks.comT. M. Inc., Trailer body 3dof documentation (2020). https://uk.mathworks.com/help/vdynblks/ref/trailerbody3dof.html<br>

DataCite Commons 收录