CNN/Daily Mail|新闻文本数据集|文本摘要数据集

收藏数据集概述

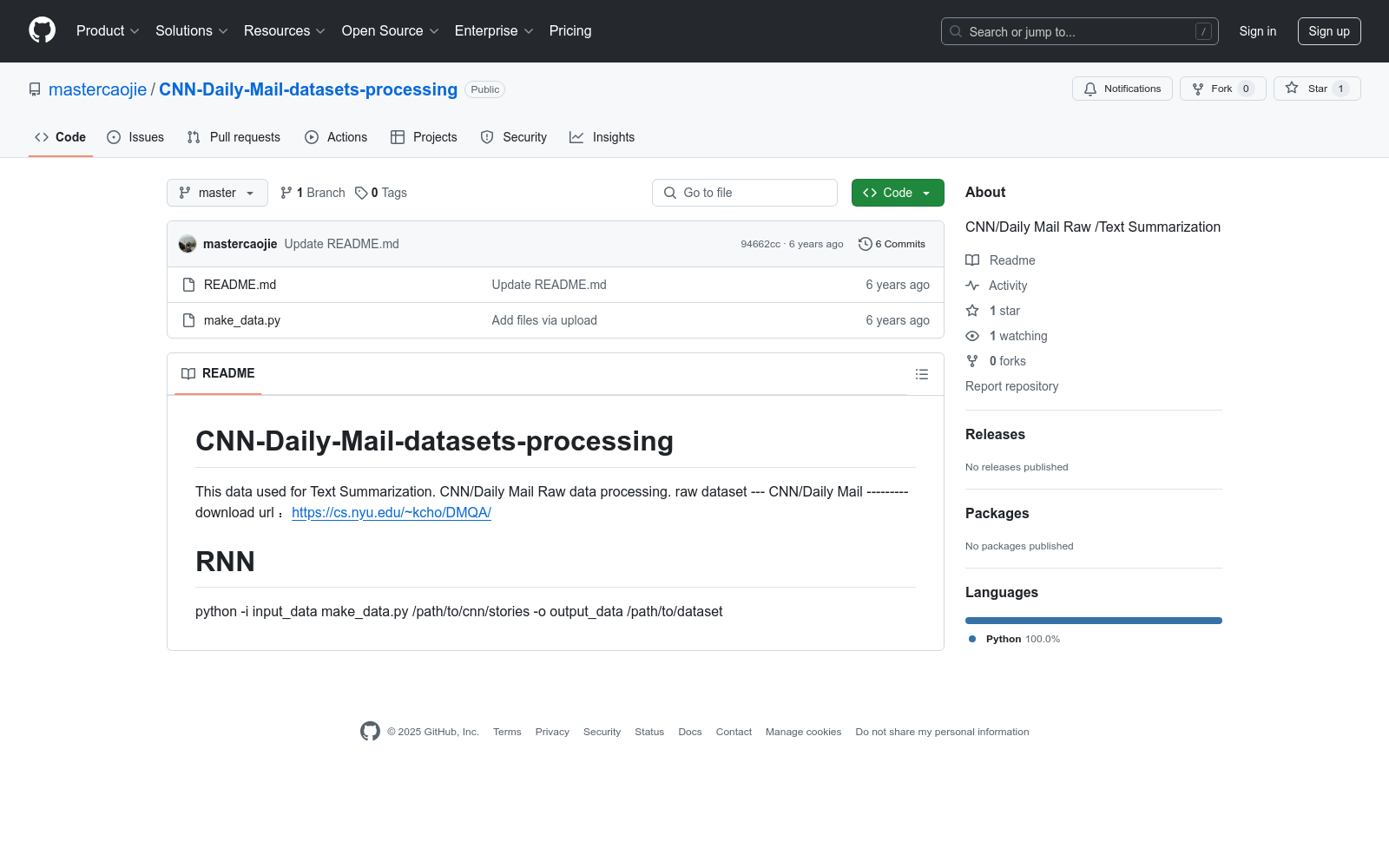

数据集名称

CNN/Daily Mail

数据集用途

用于文本摘要任务。

数据集来源

- 原始数据集下载链接:https://cs.nyu.edu/~kcho/DMQA/

数据处理命令

使用Python脚本进行数据处理,命令如下:

python -i input_data make_data.py /path/to/cnn/stories -o output_data /path/to/dataset

此命令用于从指定的CNN故事路径生成数据集输出。

poi

本项目收集国内POI兴趣点,当前版本数据来自于openstreetmap。

github 收录

CosyVoice 2

CosyVoice 2是由阿里巴巴集团开发的多语言语音合成数据集,旨在通过大规模多语言数据集训练,实现高质量的流式语音合成。数据集通过有限标量量化技术改进语音令牌的利用率,并结合预训练的大型语言模型作为骨干,支持流式和非流式合成。数据集的创建过程包括文本令牌化、监督语义语音令牌化、统一文本-语音语言模型和块感知流匹配模型等步骤。该数据集主要应用于语音合成领域,旨在解决高延迟和低自然度的问题,提供接近人类水平的语音合成质量。

arXiv 收录

中国行政区划shp数据

中国行政区划数据是重要的基础地理信息数据,目前不同来源的全国行政区划数据非常多,但能够开放获取的高质量行政区域数据少之又少。基于此,锐多宝的地理空间制作一套2013-2023年可开放获取的高质量行政区划数据。该套数据以2022年国家基础地理信息数据中的县区划数据作为矢量基础,辅以高德行政区划数据、天地图行政区划数据,参考历年来民政部公布的行政区划为属性基础,具有时间跨度长、属性丰富、国界准确、更新持续等特性。 中国行政区划数据统计截止时间是2023年2月12日,包含省、市、县、国界、九段线等矢量shp数据。该数据基于2020年行政区划底图,按时间顺序依次制作了2013-2023年初的行政区划数据。截止2023年1月1日,我国共有34个省级单位,分别是4个直辖市、23个省、5个自治区和2个特别行政区。截止2023年1月1日,我国共有333个地级单位,分别是293个地级市、7个地区、30个自治州和3个盟,其中38个矢量要素未纳入统计(比如直辖市北京等、特别行政区澳门等、省直辖县定安县等)。截止2023年1月1日,我国共有2843个县级单位,分别是1301个县、394个县级市、977个市辖区、117个自治县、49个旗、3个自治旗、1个特区和1个林区,其中9个矢量要素未纳入县级类别统计范畴(比如特别行政区香港、无县级单位的地级市中山市东莞市等)。

CnOpenData 收录

Arizona Cities by Population

A dataset listing Arizona cities by population for 2024.

www.arizona-demographics.com 收录

中国近海台风路径集合数据集(1945-2024)

1945-2024年度,中国近海台风路径数据集,包含每个台风的真实路径信息、台风强度、气压、中心风速、移动速度、移动方向。 数据源为获取温州台风网(http://www.wztf121.com/)的真实观测路径数据,经过处理整合后形成文件,如使用csv文件需使用文本编辑器打开浏览,否则会出现乱码,如要使用excel查看数据,请使用xlsx的格式。

国家海洋科学数据中心 收录