UltraFeedback|机器学习数据集|自然语言处理数据集

收藏数据集概述

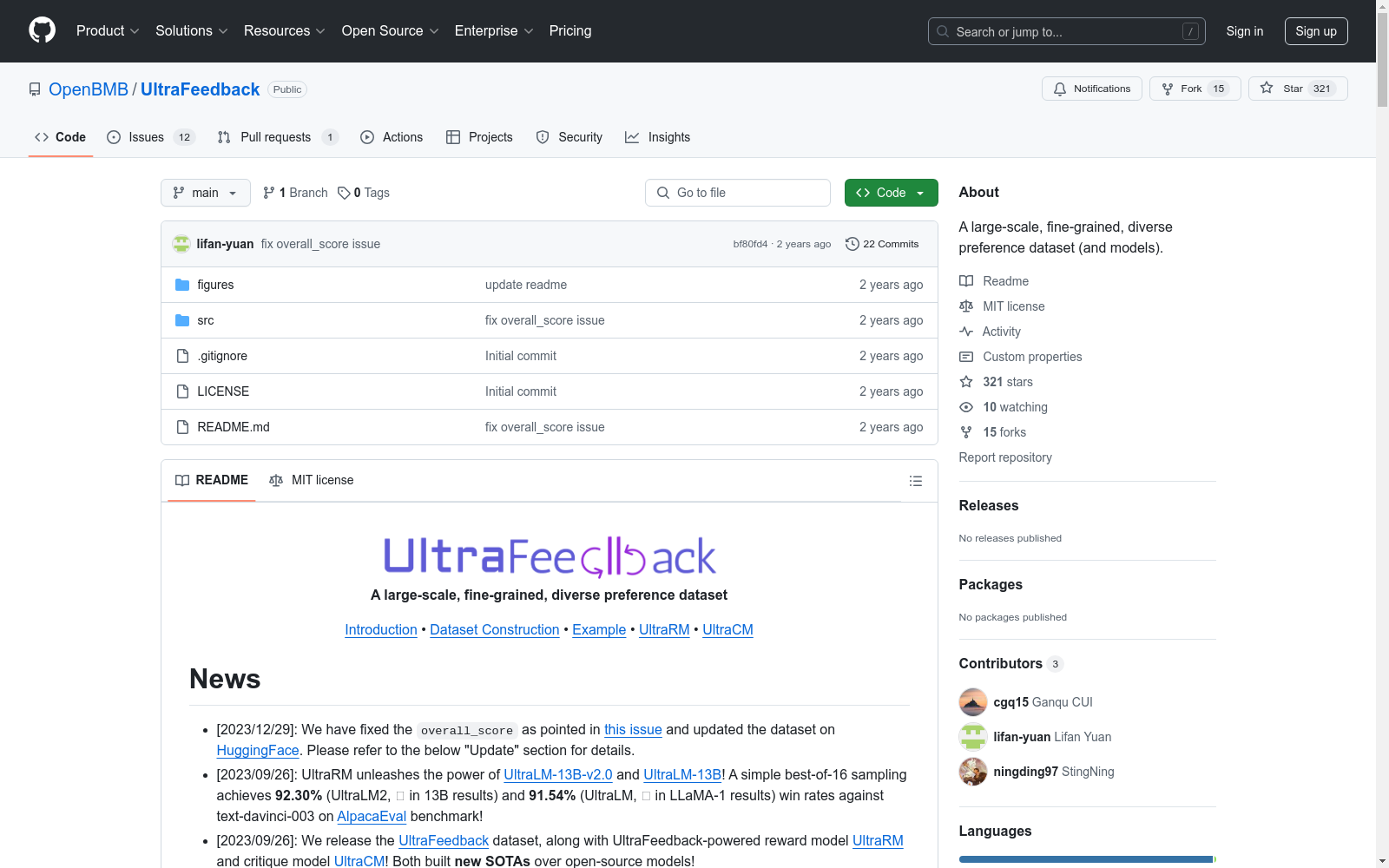

UltraFeedback 是一个大规模、细粒度、多样化的偏好数据集,用于训练强大的奖励模型和批评模型。该数据集收集了约64,000个来自多种资源(包括UltraChat、ShareGPT、Evol-Instruct、TruthfulQA、FalseQA和FLAN)的提示,并使用这些提示查询多个大型语言模型(LLMs),为每个提示生成4种不同的响应,总计256,000个样本。

数据集特点

- 规模:包含64,000个提示,256,000个响应和高质量的反馈。研究人员可以进一步构建约340,000个比较对来训练他们的奖励模型。

- 多样性:数据集从各种来源收集提示,并查询了一系列多样化的开源和知名模型。为了进一步增加多样性,选择了不同的基础模型,如LLaMA、Falcon、StarChat、MPT、GPT和Bard,并应用了多种原则来激发模型以不同方式完成指令。

- 高密度:提供数值和文本反馈,并编写了细粒度的注释文档,帮助在所有维度上评价响应。

数据集构造

- 指令采样:从6个公开可用的高质量数据集中采样了63,967个指令。

- 模型采样:为了防止奖励模型过度拟合到特定的文本风格或捕捉文本风格与奖励之间的虚假相关性,选择了不同级别、大小、架构和训练数据的不同基础模型来完成指令。

- 原则采样:定义了一组原则,以明确地从不同方面对齐模型行为。

数据集格式

数据集的每个样本包含来源、指令、模型、正确答案、错误答案和完成项。每个完成项包括模型、原则、自定义系统提示、响应和注释。

数据集应用

- UltraRM:基于UltraFeedback训练并发布了一个奖励模型,用于进一步促进对齐研究。

- UltraCM:基于UltraFeedback训练并发布了一个批评模型,用于自动批评生成。

数据集示例

提供了一个用户与四个不同助手之间的交互示例,展示了数据集中的样本结构和内容。

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

2017-2020年内蒙古当地杂豆的原料特性及生物活性物质分析数据集

参照国标对内蒙古当地的豌豆、赤小豆、绿豆、红芸豆及扁豆等五种杂豆的原料特性和生物活性物质含量进行测定,并进行对比分析。

国家农业科学数据中心 收录

WideIRSTD Dataset

WideIRSTD数据集包含七个公开数据集:SIRST-V2、IRSTD-1K、IRDST、NUDT-SIRST、NUDT-SIRST-Sea、NUDT-MIRSDT、Anti-UAV,以及由国防科技大学团队开发的数据集,包括模拟陆基和太空基数据,以及真实手动标注的太空基数据。数据集包含具有各种目标形状(如点目标、斑点目标、扩展目标)、波长(如近红外、短波红外和热红外)、图像分辨率(如256、512、1024、3200等)的图像,以及不同的成像系统(如陆基、空基和太空基成像系统)。

github 收录

Nexdata/chinese_dialect

该数据集包含25,000小时的中文方言语音数据,收集自多个方言区域的本地方言使用者,涵盖闽南语、粤语、四川话、河南话、东北话、上海话、维吾尔语和藏语等。数据格式为16kHz、16bit、未压缩的wav文件,单声道。句子准确率超过95%。数据集支持的任务包括自动语音识别(ASR)和音频说话人识别。

hugging_face 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录