ReferCOCO数据集|视觉定位数据集|对象识别数据集

收藏github2024-04-26 更新2024-05-31 收录

下载链接:

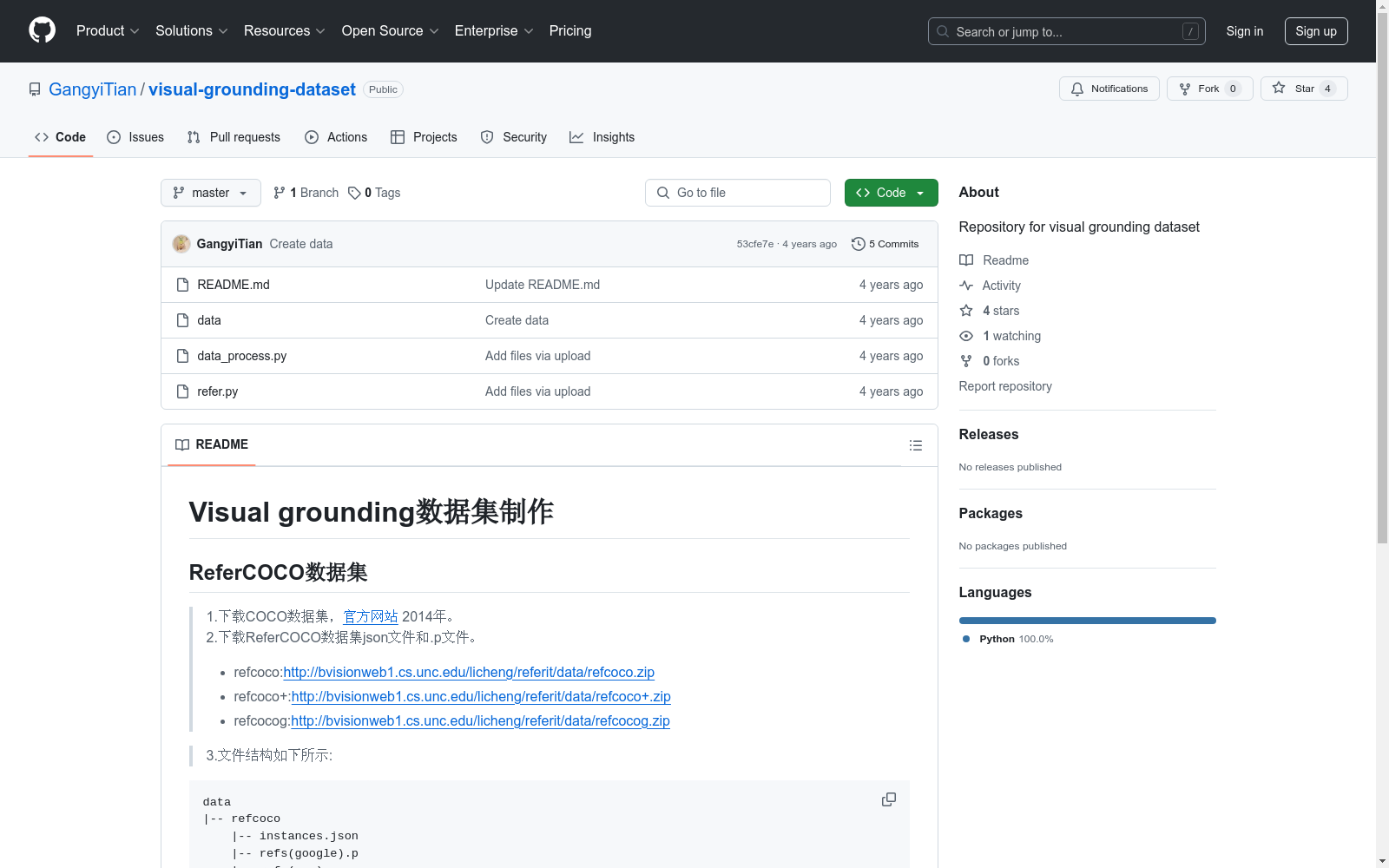

https://github.com/GangyiTian/visual-grounding-dataset

下载链接

链接失效反馈资源简介:

ReferCOCO数据集包括refcoco、refcoco+和refcocog三个子集,用于视觉定位任务。数据集包含图像和对应的描述性文本,用于训练和测试模型识别图像中特定对象的能力。

The ReferCOCO dataset comprises three subsets: refcoco, refcoco+, and refcocog, designed for visual grounding tasks. It includes images paired with descriptive texts, utilized for training and evaluating models' capabilities in identifying specific objects within images.

创建时间:

2020-03-27

原始信息汇总

数据集概述

数据集名称

ReferCOCO数据集

数据集组成

- refcoco:

- instances.json

- refs(google).p

- refs(unc).p

- refcoco+:

- instances.json

- refs(unc).p

- refcocog:

- instances.json

- refs(google).p

- refs(umd).p

- images:

- train2014

数据集处理命令

-

处理refcoco数据集:

python data_process.py --data_root data --output_dir data --dataset refcoco --split unc --generate_mask

-

处理refcoco+数据集:

python data_process.py --data_root data --output_dir data --dataset refcoco+ --split unc --generate_mask

-

处理refcocog数据集:

python data_process.py --data_root data --output_dir data --dataset refcocog --split umd --generate_mask

数据集处理结果

- 生成anns、masks文件夹

AI搜集汇总

数据集介绍

构建方式

ReferCOCO数据集的构建基于COCO 2014数据集,通过整合多个子集(refcoco、refcoco+、refcocog)来实现。首先,从COCO官方网站下载2014年的数据集,随后分别从指定链接获取refcoco、refcoco+和refcocog的json和p文件。这些文件包含了图像实例的详细信息和引用表达式。文件结构经过精心设计,确保了数据的有序存储和高效访问。通过执行特定的Python脚本,数据集被进一步处理,生成包含注释和掩码的文件夹,为后续的视觉定位任务提供了坚实的基础。

特点

ReferCOCO数据集的显著特点在于其多样的子集结构和丰富的引用表达式。该数据集不仅涵盖了refcoco、refcoco+和refcocog三个子集,每个子集还包含了不同来源的引用数据,如unc和google等。这种多样性使得数据集能够适应多种视觉定位任务的需求。此外,数据集中的引用表达式为图像中的特定对象提供了详细的语言描述,增强了模型的理解能力。通过生成的注释和掩码文件,数据集为研究人员提供了便捷的数据处理和分析工具。

使用方法

使用ReferCOCO数据集时,首先需下载COCO 2014数据集及各子集的json和p文件,并按照指定结构组织文件。随后,通过执行提供的Python脚本,对数据进行预处理,生成包含注释和掩码的文件夹。这些处理后的数据可直接用于训练和评估视觉定位模型。研究人员可以根据具体需求选择不同的子集和数据分割方式,利用生成的注释和掩码文件进行模型训练和测试。详细的处理步骤和代码实现可在作者的GitHub页面找到,确保了数据集的灵活使用和高效应用。

背景与挑战

背景概述

ReferCOCO数据集是基于COCO数据集(2014年发布)构建的视觉定位(Visual Grounding)数据集,由北卡罗来纳大学教堂山分校的研究团队主导开发。该数据集的核心研究问题是通过自然语言描述来定位图像中的特定对象,旨在推动图像与语言交叉领域的研究进展。ReferCOCO数据集包含三个子集:refcoco、refcoco+和refcocog,分别用于不同的视觉定位任务。其创建不仅丰富了视觉定位领域的数据资源,还为多模态学习提供了重要的基准数据集,对计算机视觉与自然语言处理的结合研究具有深远影响。

当前挑战

ReferCOCO数据集在构建过程中面临多重挑战。首先,如何将自然语言描述与图像中的具体对象准确对应,是视觉定位任务的核心难题,涉及语义理解与视觉信息的深度融合。其次,数据集的多样性和复杂性要求模型具备强大的跨模态推理能力,以应对不同场景和语言表达方式。此外,数据集的构建还需解决标注一致性、数据量扩展以及不同子集之间的差异性问题,确保数据集的可靠性和广泛适用性。这些挑战不仅推动了数据集的精细化设计,也对相关算法的研究提出了更高的要求。

常用场景

经典使用场景

ReferCOCO数据集在视觉定位领域中扮演着至关重要的角色,其经典使用场景主要集中在通过自然语言描述来定位图像中的特定对象。该数据集通过结合COCO数据集的图像与丰富的语言描述,使得研究者能够训练和评估模型在复杂场景中识别和定位目标对象的能力。这种结合语言与视觉信息的方式,为多模态学习提供了坚实的基础,特别是在图像描述与视觉问答等任务中展现了其独特的价值。

解决学术问题

ReferCOCO数据集在解决视觉定位这一学术难题上具有显著的意义。它通过提供精确的语言描述与对应的图像区域标注,帮助研究者克服了传统图像识别任务中对目标对象描述不足的问题。这一数据集的引入,不仅推动了多模态学习的发展,还为研究者提供了一个标准化的基准,用以评估和比较不同模型的性能,从而在学术界产生了深远的影响。

衍生相关工作

ReferCOCO数据集的发布催生了一系列相关研究工作,尤其是在多模态学习和视觉定位领域。许多研究者基于该数据集开发了新的模型和算法,以提高视觉定位的准确性和鲁棒性。例如,一些研究工作探索了如何更有效地融合语言和视觉信息,而另一些则专注于提高模型在复杂场景中的泛化能力。这些衍生工作不仅丰富了该领域的研究内容,还为实际应用提供了更多的技术支持。

以上内容由AI搜集并总结生成