CSC-gpt4|中文拼写纠错数据集|自然语言处理数据集

收藏中文拼写纠错数据集(gpt4修正版)

数据集描述

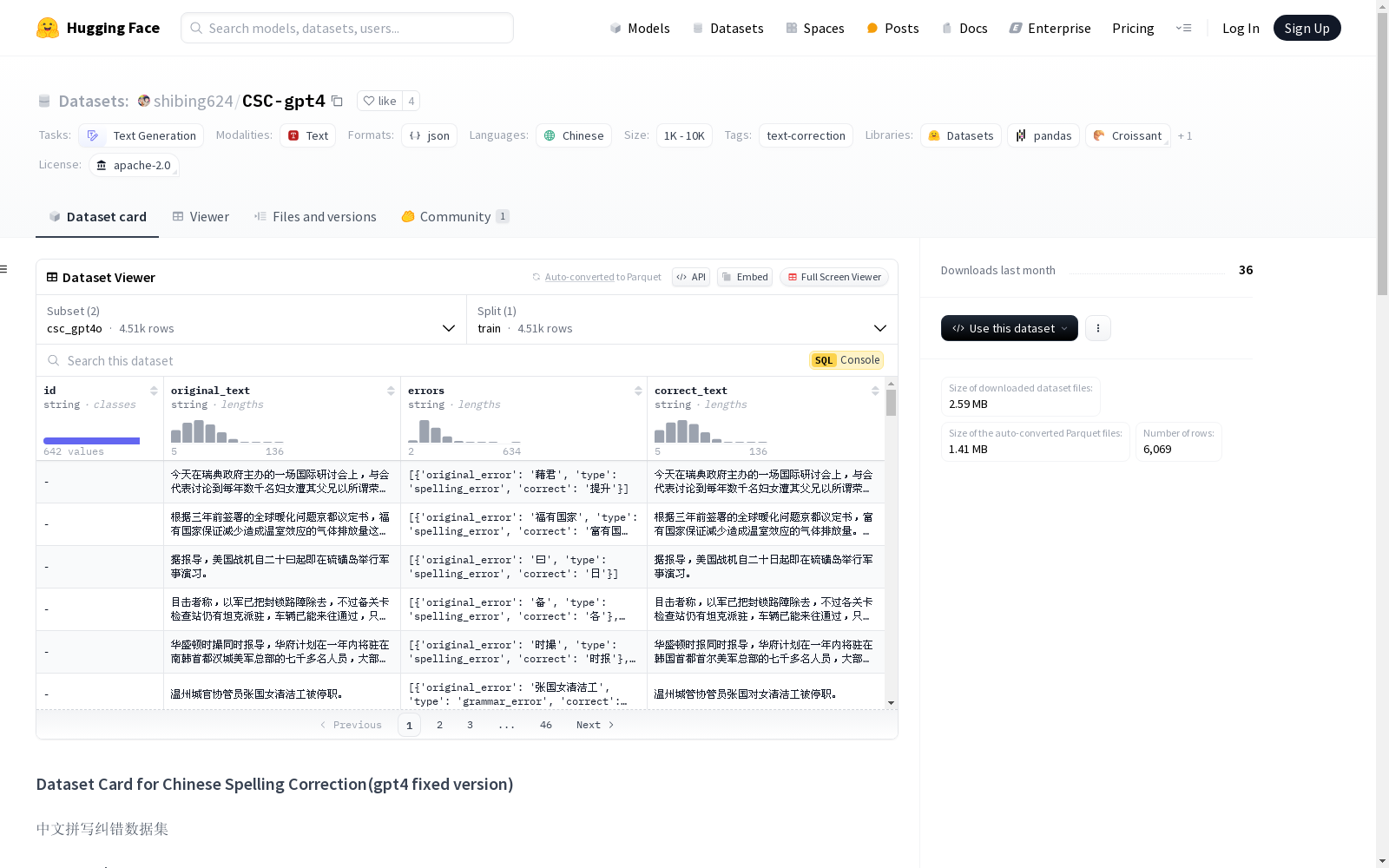

中文拼写纠错数据集(CSC)是一个用于检测和纠正中文文本中拼写错误的任务。由于许多中文字符在视觉或语音上相似但具有完全不同的语义,因此这一任务具有挑战性。

该数据集共包含6千条数据,整合了原始SIGHAN13、14、15年数据集和Wang271k数据集的拼写纠错数据(抽样得到4.5k条),以及语法纠错样本集(抽样得到1.5k条)。这些数据是通过gpt4的API逐条生成得到的,格式为jsonl,并包含错误字符信息。

数据文件

- csc_gpt4o.jsonl:从CSC数据集抽样得到,包括SIGHAN13、14、15和Wang271k数据,文件大小为2MB,包含4.5千条数据。

- grammar_gpt4o.jsonl:从pycorrector/grammar数据集抽样得到,包括语法纠错数据,文件大小为577KB,包含1.5k条数据。

数据格式

数据样例:

json { "id": "-", "original_text": "可是在从原棉制成纱线的过程,就不像穿着光滑舒适的衣服那样让人愉快了:纱厂工人终日面临着音响,尘埃和湿气的。", "errors": [{original_error: 音响, type: wrong_word, correct: 噪音}, {original_error: 的, type: extra_word, correct: }], "correct_text": "可是在从原棉制成纱线的过程,就不像穿着光滑舒适的衣服那样让人愉快了:纱厂工人终日面临着噪音,尘埃和湿气。" }

字段解释:

- id:唯一标识符,无意义。

- original_text:原始错误文本。

- errors:错误列表,包含原始错误文本片段(original_error)、错误类型(type)和正确的文本(correct)。错误类型包括拼写错误(spelling_error)、语法错误(grammar_error)、缺少单词(missing_word)、多余单词(extra_word)等。

- correct_text:纠正后的文本。

支持的任务和排行榜

该数据集设计用于中文拼写纠错任务的预训练语言模型训练。

语言

数据集中的数据为中文。

许可信息

该数据集在Apache 2.0许可下发布。

引用信息

latex @misc{Xu_Pycorrector_Text_error, title={Pycorrector: Text error correction tool}, author={Xu Ming}, year={2024}, howpublished={url{https://github.com/shibing624/pycorrector}}, }

贡献者

shibing624 整理并上传。

FER2013

FER2013数据集是一个广泛用于面部表情识别领域的数据集,包含28,709个训练样本和7,178个测试样本。图像属性为48x48像素,标签包括愤怒、厌恶、恐惧、快乐、悲伤、惊讶和中性。

github 收录

TM-Senti

TM-Senti是由伦敦玛丽女王大学开发的一个大规模、远距离监督的Twitter情感数据集,包含超过1.84亿条推文,覆盖了超过七年的时间跨度。该数据集基于互联网档案馆的公开推文存档,可以完全重新构建,包括推文元数据且无缺失推文。数据集内容丰富,涵盖多种语言,主要用于情感分析和文本分类等任务。创建过程中,研究团队精心筛选了表情符号和表情,确保数据集的质量和多样性。该数据集的应用领域广泛,旨在解决社交媒体情感表达的长期变化问题,特别是在表情符号和表情使用上的趋势分析。

arXiv 收录

中国1km分辨率逐月降水量数据集(1901-2023)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2023.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

World Flights

该数据集包含使用OpenSky Network实时API收集的两小时飞行数据。飞行颜色基于出发国家,记录了18000次飞行,由于缺乏卫星覆盖,海洋上的航线不完整。每条航线还加入了来自airlinecodes.co.uk的航空公司信息。

github 收录

Breast Ultrasound Images (BUSI)

小型(约500×500像素)超声图像,适用于良性和恶性病变的分类和分割任务。

github 收录