Multimodal IFT and PT Dataset|多模态信息融合数据集|表格理解数据集

收藏github2024-05-17 更新2024-05-31 收录

下载链接:

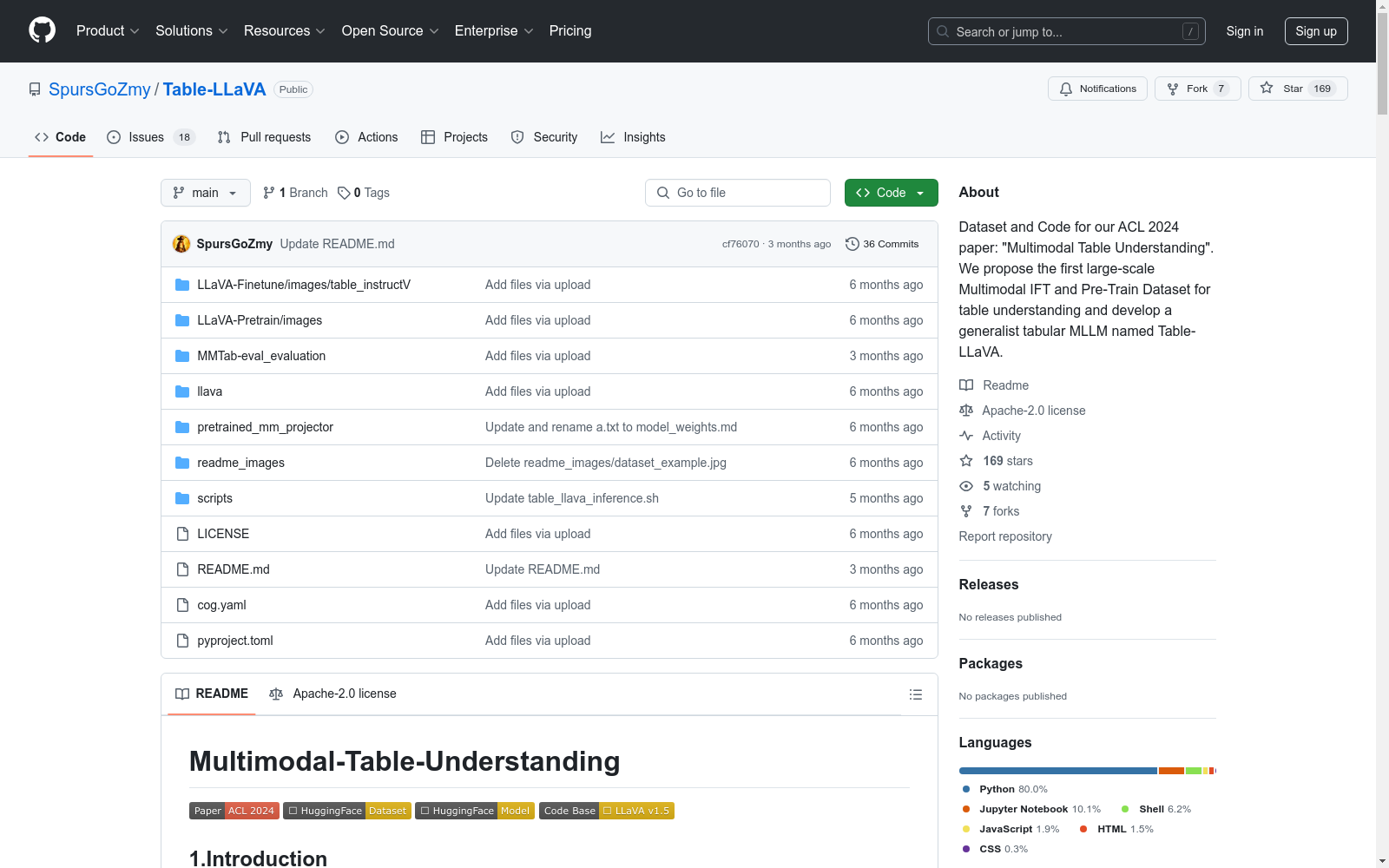

https://github.com/SpursGoZmy/Multimodal-Table-Understanding

下载链接

链接失效反馈资源简介:

该数据集是首次提出的大规模多模态IFT和PT数据集,用于表格理解。

This dataset represents the first large-scale multimodal IFT and PT dataset proposed for table understanding.

创建时间:

2024-05-17

原始信息汇总

数据集概述

数据集名称

MMTab

数据集描述

MMTab是首个开源的大规模多模态表格理解数据集,旨在支持多模态大型语言模型(MLLMs)在多模态表格理解方面的训练和评估。该数据集基于14个公开的表格数据集,涵盖8个领域,通过精心设计的脚本将原始文本表格转换为强调广泛表格结构和样式的表格图像,并将所有特定任务样本转换为统一格式的多模态指令调整样本,格式为<table image, input request, output response>。

数据集结构

MMTab数据集分为三个部分:

- MMTab-pre:包含97K表格图像,150K表格识别样本,用于预训练。

- MMTab-instruct:包含82K表格图像,232K样本,涉及14个表格基础任务,用于指令调整。

- MMTab-eval:包含23K表格图像,45K样本,用于评估17个内部基准和4K样本,用于评估7个外部基准。

数据集用途

该数据集支持多模态表格理解模型的训练和评估,特别适用于开发和测试直接使用视觉信息理解表格的模型。

数据集下载

数据集可从Hugging Face Dataset下载。

AI搜集汇总

数据集介绍

构建方式

MMTab数据集的构建基于14个公开可用的表格数据集,涵盖8个领域。通过精心设计的脚本,原始文本表格被转换为图像,以突出广泛的表格结构和样式。所有任务特定的样本被转换为多模态指令调优样本,采用统一的格式:<表格图像,输入请求,输出响应>。数据集分为三部分:预训练数据(MMTab-pre)、指令调优数据(MMTab-instruct)和评估数据(MMTab-eval)。在构建过程中,采用了多层次的数据增强(如表格级别、任务级别)以提高数据的多样性。

特点

MMTab数据集的显著特点在于其多模态性质,支持基于图像的表格理解和处理。数据集不仅涵盖了广泛的表格结构和样式,还通过多层次的数据增强提升了数据的多样性和复杂性。此外,MMTab是首个开源的大规模多模态表格理解数据集,支持通用多模态大语言模型(MLLMs)的训练和评估,特别适用于需要直接处理表格图像的实际应用场景。

使用方法

MMTab数据集可通过Hugging Face平台下载,支持多种使用场景,包括预训练、指令调优和评估。用户可以利用该数据集训练和评估多模态表格理解模型,如Table-LLaVA。数据集的格式统一,便于直接用于模型的输入和输出。此外,数据集的图像和文本数据均经过精心处理,确保了高质量的训练和评估效果。

背景与挑战

背景概述

随着大规模语言模型(LLM)在表格理解领域的快速发展,尽管这些方法在处理结构化数据方面取得了显著进展,但它们通常依赖于将表格转换为特定文本格式(如Markdown或HTML)作为模型输入。然而,在实际应用中,如扫描文档和网页截图等场景,高质量的文本表格表示往往难以获取,而表格图像则更为常见。因此,如何直接利用视觉信息理解表格成为一个紧迫且关键的挑战。为应对这一挑战,研究团队提出了多模态表格理解问题,并构建了首个开源大规模数据集MMTab,旨在支持多模态表格理解任务的训练与评估。该数据集基于14个公开的表格数据集,涵盖8个领域,通过精心设计的脚本将原始文本表格转换为图像,并生成多模态指令调优样本。MMTab的构建为开发更实用的多模态表格理解模型奠定了基础,推动了该领域的研究进展。

当前挑战

MMTab数据集的构建面临多重挑战。首先,如何将复杂的表格结构和样式转换为高质量的图像表示,确保数据的多样性和覆盖范围,是一个技术难题。其次,在多模态指令调优样本的生成过程中,如何保持任务的多样性和样本的统一格式,以支持模型的泛化能力,也是一个重要挑战。此外,实际应用中,表格图像的质量参差不齐,如模糊、手写或不完整的表格图像,如何处理这些低质量图像并生成有效的训练数据,是未来需要解决的问题。最后,当前模型的图像分辨率相对较低,可能限制其性能上限,如何利用更高分辨率的图像数据提升模型表现,也是未来研究的方向。

常用场景

经典使用场景

Multimodal IFT and PT Dataset 数据集的经典使用场景主要集中在多模态表格理解任务中。该数据集通过将表格数据转换为图像形式,支持模型直接基于表格图像进行理解和推理。这种设计使得模型能够在处理扫描文档、网页截图等实际场景中的表格时,无需依赖文本形式的表格表示,从而提升了模型的实用性和泛化能力。

衍生相关工作

基于 Multimodal IFT and PT Dataset 数据集,研究者们开发了多种多模态表格理解模型,如 Table-LLaVA,该模型在多个基准测试中表现优异,甚至在某些任务上与 GPT-4V 相媲美。此外,该数据集还激发了多模态学习在其他领域的应用研究,如多模态文档理解、视觉问答等。这些衍生工作进一步拓展了数据集的影响力,推动了多模态学习技术的发展。

数据集最近研究

最新研究方向

在多模态表格理解领域,最新的研究方向集中在如何直接利用表格图像进行端到端的理解与响应。这一方向的提出源于现有基于大语言模型(LLM)的表格理解方法在处理真实世界场景(如扫描文档和网页截图)时的局限性。Multimodal IFT and PT Dataset(MMTab)作为首个大规模开放源码的多模态表格理解数据集,支持通用多模态大语言模型(MLLM)的训练与评估。基于MMTab数据集,研究者开发了名为Table-LLaVA的多模态模型,该模型在多个基准测试中表现优异,甚至在部分测试中与GPT-4V竞争。未来研究将进一步探索多语言、多表格场景以及真实世界中低质量表格图像的处理,同时提升图像分辨率以增强模型的理解能力。

以上内容由AI搜集并总结生成