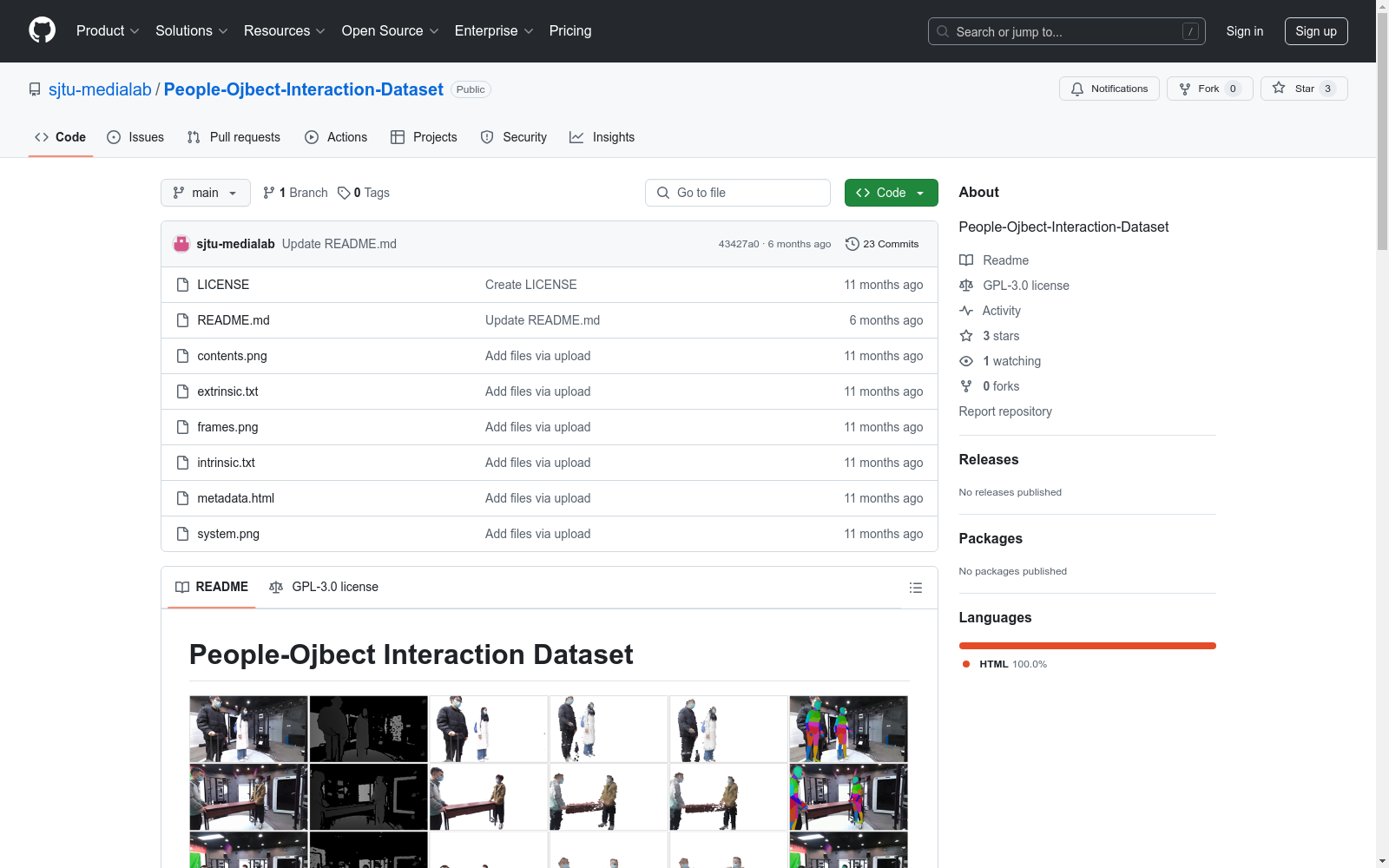

People-Object Interaction Dataset|人机交互数据集|行为识别数据集

收藏People-Object Interaction Dataset 概述

数据集内容

- 视频序列:包含38系列30-view的RGB-D视频序列,分辨率为4K,帧率为25 FPS,持续时间为1~19秒。

- 辅助数据:包括相机参数、前景掩码、SMPL模型、点云和网格文件。

视频序列详情

- 场景类型:

- 空场景:1个,持续1秒。

- 相机校准:1个,持续8秒。

- 单人互动:23个,持续2~19秒,包括多种日常活动如翻书、坐椅子、开伞等。

- 双人互动:11个,持续2~14秒,涉及双人合作活动如移动桌子、扫地等。

- 三人互动:2个,持续2~5秒,主要为集体拍照。

数据处理

- 前景掩码提取:使用BackgroundMattingV2。

- 点云和网格文件提取:采用Zhou et al.和Zhou et al.的方法。

- SMPL模型提取:使用MMHuman3D。

数据集下载

- 下载方式:可通过BaiduNetdisk或Medialab获取。

相机参数

- 文件:

intrinsic.txt和extrinsic.txt提供相机参数。 - 格式:外部参数表示相机坐标系到世界坐标系的转换。

引用信息

-

论文:已被ICIP-2024接受。

-

引用格式:

@inproceedings{POID, title={A New People-Object Interaction Dataset and NVS Benchmarks}, author={Guo, Shuai and Zhong, Houqiang and Wang, Qiuwen and Chen, Ziyu and Gao, Yijie and Yuan, Jiajing and Zhang, Chenyu and Xie, Rong and Song, Li}, booktitle={2024 IEEE International Conference on Image Processing (ICIP)}, year={2024}, organization={IEEE} }

lmarena-ai/arena-human-preference-100k

这个数据集包含了2024年6月至2024年8月期间收集的排行榜对话数据。它包括用于开发Arena Explorer的英语人类偏好评价。此外,我们还提供了一个嵌入文件,其中包含了英语对话的预计算嵌入,这些嵌入用于主题建模管道以对这些对话进行分类和分析。

hugging_face 收录

QM9

QM9数据集包含134k个有机小分子化合物的量子化学计算结果,涵盖了12个量子化学性质,如分子能量、电离能、电子亲和能等。

quantum-machine.org 收录

Duke Lung Cancer Screening Dataset 2024 (DLCS 2024)

Duke Lung Cancer Screening Dataset 2024 (DLCS 2024) 是一个用于肺癌风险分类研究的数据集,随着低剂量胸部CT筛查项目的普及,该数据集变得越来越重要。

github 收录

EDDFS

EDDFS包含28877张彩色眼底图像,用于基于深度学习的眼病诊断。除了15000个健康样本外,数据集还包括8种眼疾,如糖尿病视网膜病变、老年性黄斑变性、青光眼、病理性近视、高血压、视网膜静脉阻塞、LASIK斑点及其他。

github 收录

TyDi QA

TyDi QA是一个包含204,000个问题-答案对的数据集,涵盖11种类型多样的语言。该数据集旨在通过包含多种语言特征,使模型能够跨大量世界语言进行泛化。问题由不知道答案的人撰写,数据直接在每种语言中收集,无需翻译。

github 收录