Rowan/hellaswag|自然语言处理数据集|常识推理数据集

收藏hugging_face2023-09-28 更新2024-03-04 收录

下载链接:

https://hf-mirror.com/datasets/Rowan/hellaswag

下载链接

链接失效反馈资源简介:

---

language:

- en

paperswithcode_id: hellaswag

pretty_name: HellaSwag

dataset_info:

features:

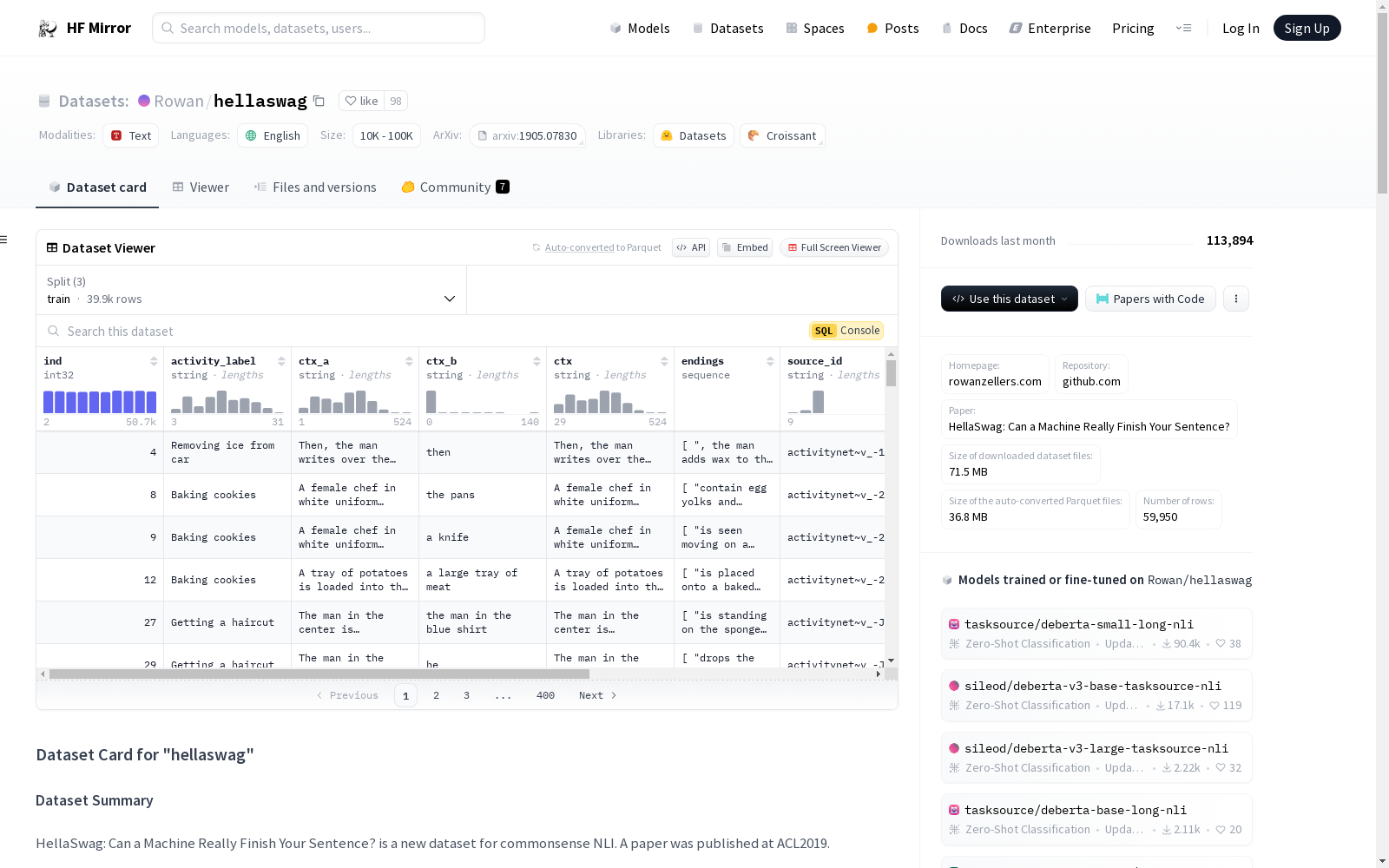

- name: ind

dtype: int32

- name: activity_label

dtype: string

- name: ctx_a

dtype: string

- name: ctx_b

dtype: string

- name: ctx

dtype: string

- name: endings

sequence: string

- name: source_id

dtype: string

- name: split

dtype: string

- name: split_type

dtype: string

- name: label

dtype: string

splits:

- name: train

num_bytes: 43232624

num_examples: 39905

- name: test

num_bytes: 10791853

num_examples: 10003

- name: validation

num_bytes: 11175717

num_examples: 10042

download_size: 71494896

dataset_size: 65200194

---

# Dataset Card for "hellaswag"

## Table of Contents

- [Dataset Description](#dataset-description)

- [Dataset Summary](#dataset-summary)

- [Supported Tasks and Leaderboards](#supported-tasks-and-leaderboards)

- [Languages](#languages)

- [Dataset Structure](#dataset-structure)

- [Data Instances](#data-instances)

- [Data Fields](#data-fields)

- [Data Splits](#data-splits)

- [Dataset Creation](#dataset-creation)

- [Curation Rationale](#curation-rationale)

- [Source Data](#source-data)

- [Annotations](#annotations)

- [Personal and Sensitive Information](#personal-and-sensitive-information)

- [Considerations for Using the Data](#considerations-for-using-the-data)

- [Social Impact of Dataset](#social-impact-of-dataset)

- [Discussion of Biases](#discussion-of-biases)

- [Other Known Limitations](#other-known-limitations)

- [Additional Information](#additional-information)

- [Dataset Curators](#dataset-curators)

- [Licensing Information](#licensing-information)

- [Citation Information](#citation-information)

- [Contributions](#contributions)

## Dataset Description

- **Homepage:** [https://rowanzellers.com/hellaswag/](https://rowanzellers.com/hellaswag/)

- **Repository:** [https://github.com/rowanz/hellaswag/](https://github.com/rowanz/hellaswag/)

- **Paper:** [HellaSwag: Can a Machine Really Finish Your Sentence?](https://arxiv.org/abs/1905.07830)

- **Point of Contact:** [More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

- **Size of downloaded dataset files:** 71.49 MB

- **Size of the generated dataset:** 65.32 MB

- **Total amount of disk used:** 136.81 MB

### Dataset Summary

HellaSwag: Can a Machine Really Finish Your Sentence? is a new dataset for commonsense NLI. A paper was published at ACL2019.

### Supported Tasks and Leaderboards

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Languages

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

## Dataset Structure

### Data Instances

#### default

- **Size of downloaded dataset files:** 71.49 MB

- **Size of the generated dataset:** 65.32 MB

- **Total amount of disk used:** 136.81 MB

An example of 'train' looks as follows.

```

This example was too long and was cropped:

{

"activity_label": "Removing ice from car",

"ctx": "Then, the man writes over the snow covering the window of a car, and a woman wearing winter clothes smiles. then",

"ctx_a": "Then, the man writes over the snow covering the window of a car, and a woman wearing winter clothes smiles.",

"ctx_b": "then",

"endings": "[\", the man adds wax to the windshield and cuts it.\", \", a person board a ski lift, while two men supporting the head of the per...",

"ind": 4,

"label": "3",

"source_id": "activitynet~v_-1IBHYS3L-Y",

"split": "train",

"split_type": "indomain"

}

```

### Data Fields

The data fields are the same among all splits.

#### default

- `ind`: a `int32` feature.

- `activity_label`: a `string` feature.

- `ctx_a`: a `string` feature.

- `ctx_b`: a `string` feature.

- `ctx`: a `string` feature.

- `endings`: a `list` of `string` features.

- `source_id`: a `string` feature.

- `split`: a `string` feature.

- `split_type`: a `string` feature.

- `label`: a `string` feature.

### Data Splits

| name |train|validation|test |

|-------|----:|---------:|----:|

|default|39905| 10042|10003|

## Dataset Creation

### Curation Rationale

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Source Data

#### Initial Data Collection and Normalization

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

#### Who are the source language producers?

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Annotations

#### Annotation process

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

#### Who are the annotators?

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Personal and Sensitive Information

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

## Considerations for Using the Data

### Social Impact of Dataset

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Discussion of Biases

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Other Known Limitations

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

## Additional Information

### Dataset Curators

[More Information Needed](https://github.com/huggingface/datasets/blob/master/CONTRIBUTING.md#how-to-contribute-to-the-dataset-cards)

### Licensing Information

MIT https://github.com/rowanz/hellaswag/blob/master/LICENSE

### Citation Information

```

@inproceedings{zellers2019hellaswag,

title={HellaSwag: Can a Machine Really Finish Your Sentence?},

author={Zellers, Rowan and Holtzman, Ari and Bisk, Yonatan and Farhadi, Ali and Choi, Yejin},

booktitle ={Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics},

year={2019}

}

```

### Contributions

Thanks to [@albertvillanova](https://github.com/albertvillanova), [@mariamabarham](https://github.com/mariamabarham), [@thomwolf](https://github.com/thomwolf), [@patrickvonplaten](https://github.com/patrickvonplaten), [@lewtun](https://github.com/lewtun) for adding this dataset.

提供机构:

Rowan

原始信息汇总

数据集概述

数据集名称: HellaSwag

数据集信息:

- 语言: 英语

- 数据集大小:

- 下载大小: 71.49 MB

- 生成数据集大小: 65.32 MB

- 总磁盘使用量: 136.81 MB

数据集结构

数据实例

- 训练集示例: json { "activity_label": "Removing ice from car", "ctx": "Then, the man writes over the snow covering the window of a car, and a woman wearing winter clothes smiles. then", "ctx_a": "Then, the man writes over the雪 covering the window of a car, and a woman wearing winter clothes smiles.", "ctx_b": "then", "endings": "[", the man adds wax to the windshield and cuts it.", ", a person board a ski lift, while two men supporting the head of the per...", "ind": 4, "label": "3", "source_id": "activitynet~v_-1IBHYS3L-Y", "split": "train", "split_type": "indomain" }

数据字段

ind: int32activity_label: stringctx_a: stringctx_b: stringctx: stringendings: list of stringsource_id: stringsplit: stringsplit_type: stringlabel: string

数据分割

| 名称 | 训练集 | 验证集 | 测试集 |

|---|---|---|---|

| default | 39905 | 10042 | 10003 |

许可证信息

- 许可证: MIT

引用信息

bibtex @inproceedings{zellers2019hellaswag, title={HellaSwag: Can a Machine Really Finish Your Sentence?}, author={Zellers, Rowan and Holtzman, Ari and Bisk, Yonatan and Farhadi, Ali and Choi, Yejin}, booktitle ={Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics}, year={2019} }

贡献者

AI搜集汇总

数据集介绍

构建方式

HellaSwag数据集的构建基于常识自然语言推理(NLI)任务,旨在评估模型在完成句子时的能力。数据集通过收集和标注大量日常活动场景的上下文信息,结合多个可能的结尾选项,形成了一个包含丰富语境和多样性答案的测试平台。具体构建过程中,数据集从多个来源收集初始数据,并通过人工标注和验证确保数据的准确性和一致性。

特点

HellaSwag数据集的主要特点在于其高度复杂的语境设置和多样化的结尾选项,这使得模型在处理时需要具备较强的常识推理能力。数据集包含了大量的日常活动场景,涵盖了广泛的领域,如家庭生活、工作场景等,确保了数据的多样性和代表性。此外,数据集的标注过程严格,确保了每个样本的高质量。

使用方法

HellaSwag数据集适用于评估和训练自然语言处理模型,特别是在常识推理和句子完成任务上。使用该数据集时,研究者可以选择不同的数据分割(如训练集、验证集和测试集)来训练和评估模型。数据集提供了详细的字段信息,包括上下文、活动标签、结尾选项等,便于模型进行输入和输出处理。通过使用该数据集,研究者可以有效提升模型在复杂语境下的推理能力。

背景与挑战

背景概述

HellaSwag数据集由Rowan Zellers等人于2019年创建,旨在评估机器在常识自然语言推理(NLI)任务中的表现。该数据集的核心研究问题在于检验机器是否能够真正完成人类句子,特别是在涉及日常活动和常识推理的情境中。HellaSwag通过提供丰富的上下文和多种可能的结尾,挑战了现有模型在理解复杂语境和生成合理续写方面的能力。该数据集的发布对自然语言处理领域产生了深远影响,尤其是在推动模型对人类常识的理解和应用方面。

当前挑战

HellaSwag数据集的主要挑战在于其设计的高度复杂性和对模型常识推理能力的严格要求。首先,数据集中的每个实例都包含多个可能的结尾,要求模型不仅理解上下文,还需具备选择最合理续写的能力。其次,构建过程中面临的挑战包括如何确保数据集的多样性和覆盖广泛的生活场景,以及如何避免数据偏见,确保评估的公正性。此外,数据集的规模和复杂性也增加了模型训练和评估的计算成本和时间。

常用场景

经典使用场景

HellaSwag数据集在自然语言处理领域中,主要用于评估和提升模型在常识推理任务中的表现。该数据集通过提供上下文和多个可能的结尾,要求模型选择最符合常识的结尾,从而测试模型在理解人类日常活动和情境中的能力。这一任务不仅考验模型的语言理解能力,还涉及对现实世界常识的掌握,是评估模型在复杂语境下推理能力的重要工具。

实际应用

HellaSwag数据集的应用场景广泛,尤其在需要高度依赖常识推理的领域中表现突出。例如,在智能助手、自动文本生成和对话系统中,模型需要根据用户的输入和上下文,生成符合常识和逻辑的回应。此外,在教育、医疗和法律等领域,模型的常识推理能力也至关重要,能够帮助系统更好地理解和回应复杂的人类需求和情境。

衍生相关工作

HellaSwag数据集的发布激发了大量相关研究,特别是在常识推理和自然语言理解领域。许多研究者基于该数据集开发了新的模型和算法,以提升模型在常识推理任务中的表现。此外,HellaSwag的成功也启发了其他类似数据集的创建,如SWAG和COPA,这些数据集共同推动了自然语言处理领域在常识推理方面的研究进展。

以上内容由AI搜集并总结生成