cryptom/ceval-exam|中文评估数据集|模型评估数据集

收藏数据集概述

名称: C-Eval

许可证: cc-by-nc-sa-4.0

任务类别:

- 文本分类

- 多项选择

- 问答

语言: 中文

规模: 10K<n<100K

数据集内容

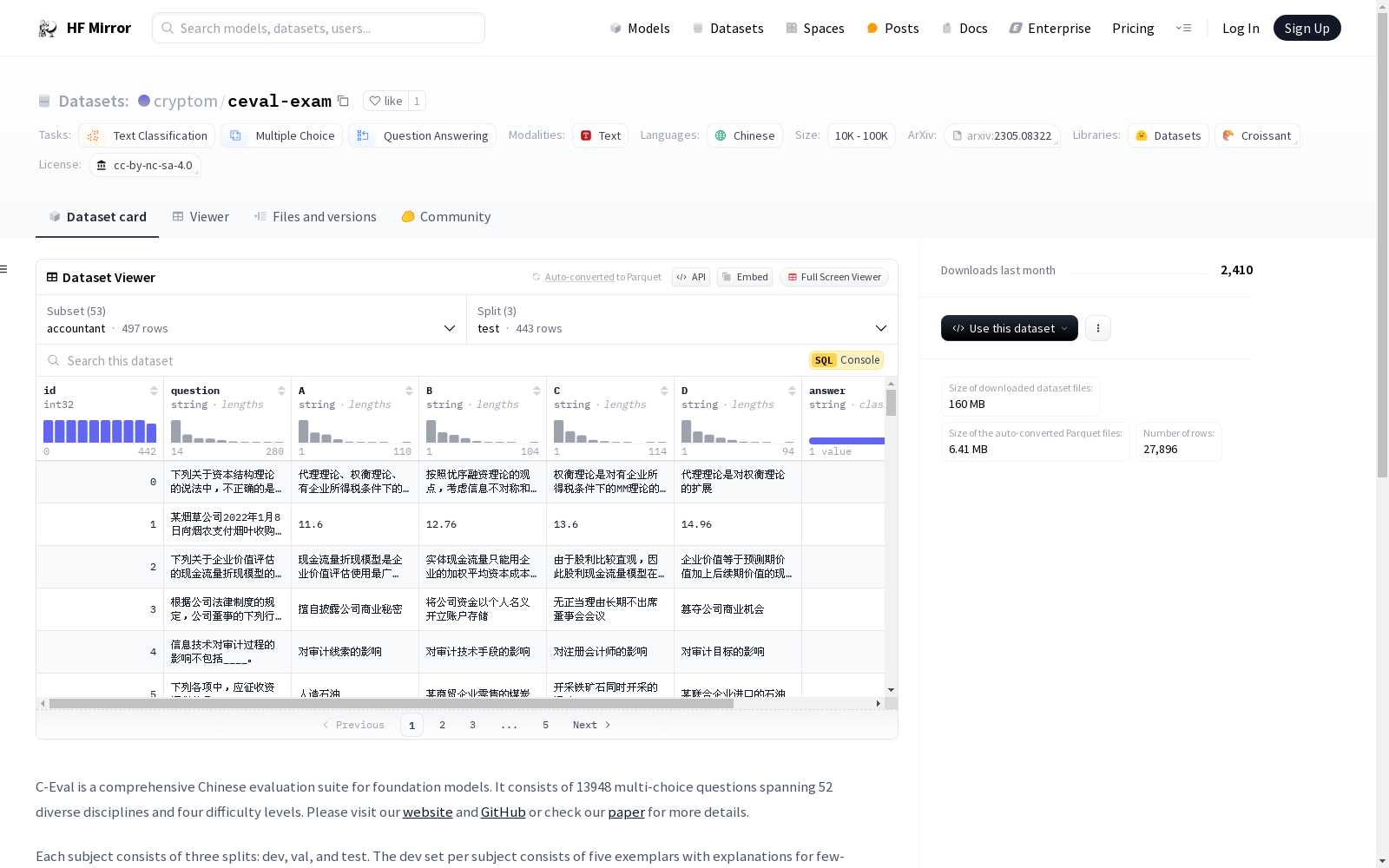

C-Eval 是一个综合性的中文基础模型评估套件,包含13948个多项选择题,涵盖52个不同学科和四个难度级别。

数据集结构

每个学科包含三个部分:

- dev 集:包含五个示例及其解释,用于少样本评估。

- val 集:用于超参数调整。

- test 集:用于模型评估,测试集的标签不公开,用户需提交结果以自动获取测试准确率。

数据加载示例

python from datasets import load_dataset dataset=load_dataset(r"ceval/ceval-exam",name="computer_network")

print(dataset[val][0])

{id: 0, question: 使用位填充方法,以01111110为位首flag,数据为011011111111111111110010,求问传送时要添加几个0____, A: 1, B: 2, C: 3, D: 4, answer: C, explanation: }

引用信息

@article{huang2023ceval, title={C-Eval: A Multi-Level Multi-Discipline Chinese Evaluation Suite for Foundation Models}, author={Huang, Yuzhen and Bai, Yuzhuo and Zhu, Zhihao and Zhang, Junlei and Zhang, Jinghan and Su, Tangjun and Liu, Junteng and Lv, Chuancheng and Zhang, Yikai and Lei, Jiayi and Fu, Yao and Sun, Maosong and He, Junxian}, journal={arXiv preprint arXiv:2305.08322}, year={2023} }

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

CatMeows

该数据集包含440个声音样本,由21只属于两个品种(缅因州库恩猫和欧洲短毛猫)的猫在三种不同情境下发出的喵声组成。这些情境包括刷毛、在陌生环境中隔离和等待食物。每个声音文件都遵循特定的命名约定,包含猫的唯一ID、品种、性别、猫主人的唯一ID、录音场次和发声计数。此外,还有一个额外的zip文件,包含被排除的录音(非喵声)和未剪辑的连续发声序列。

huggingface 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

DermNet

DermNet是一个包含皮肤病图像的数据集,涵盖了多种皮肤病类型,如痤疮、湿疹、牛皮癣等。该数据集主要用于皮肤病诊断和研究。

www.dermnetnz.org 收录