CodeUltraFeedback|偏好数据集数据集|AI模型校准数据集

收藏arXiv2024-03-14 更新2024-08-26 收录

下载链接:

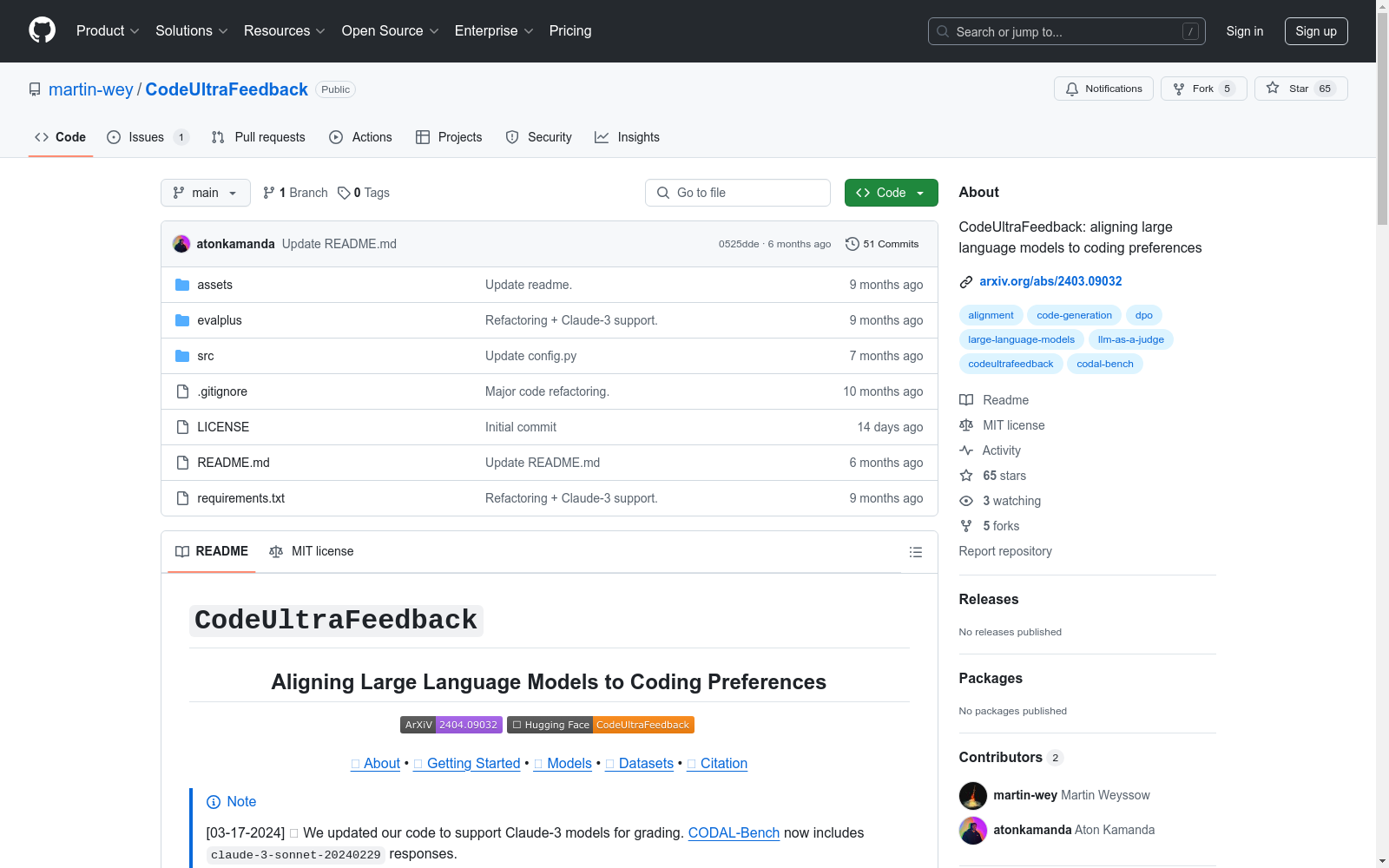

https://github.com/martin-wey/CodeUltraFeedback

下载链接

链接失效反馈资源简介:

CodeUltraFeedback是由蒙特利尔大学DIRO创建的一个包含10,000个复杂指令的数据集,旨在通过AI反馈调整和校准大型语言模型(LLMs)以符合编程偏好。该数据集通过14种不同的LLMs生成响应,并使用GPT-3.5作为评判标准,提供数值和文本反馈。数据集内容涵盖指令遵循、代码解释、代码复杂性和效率、代码可读性以及编码风格等五个非功能性要求(或编程偏好)。CodeUltraFeedback不仅用于校准LLMs,还支持了如UltraFeedback、AI反馈的强化学习(RLAIF)和LLM作为评判者等先进校准技术的开发。此外,该数据集还促进了CODAL-Bench的建立,这是一个评估LLMs与编程偏好对齐的基准。

CodeUltraFeedback is a dataset of 10,000 complex instructions created by the DIRO at the University of Montreal, designed to adjust and calibrate large language models (LLMs) to align with programming preferences through AI feedback. The dataset generates responses through 14 different LLMs and utilizes GPT-3.5 as the evaluation standard, providing both numerical and textual feedback. The content of the dataset covers five non-functional requirements (or programming preferences), including instruction adherence, code explanation, code complexity and efficiency, code readability, and coding style. CodeUltraFeedback is not only used for calibrating LLMs but also supports the development of advanced calibration techniques such as UltraFeedback, Reinforcement Learning for AI Feedback (RLAIF), and LLMs as judges. Additionally, the dataset has facilitated the establishment of CODAL-Bench, a benchmark for evaluating the alignment of LLMs with programming preferences.

提供机构:

蒙特利尔大学DIRO

创建时间:

2024-03-14

原始信息汇总

CodeUltraFeedback 数据集概述

关于数据集

概述

CodeUltraFeedback 是一个用于对齐大型语言模型(LLMs)与编码偏好的偏好数据集。该数据集基于 MagiCoder Evol-Instruct 的 10k 子集,包含复杂的编码指令。

特点

- 复杂指令:基于 10k 子集的复杂编码指令。

- 编码偏好:包含 5 种编码偏好,用于评估 LLMs 的广泛能力:指令遵循、代码解释、代码复杂性和效率、代码可读性、编码风格。

- 大型 LLM 池:使用 14 个来自 8 个模型家族的 LLMs 生成响应,考虑多样化的写作和编码风格。

- LLM-as-a-judge 和 AI 反馈:使用 GPT-3.5 作为评判,为每个响应提供数值和文本反馈。

相关数据集和基准

引用

bibtex @misc{weyssow2024codeultrafeedback, title={CodeUltraFeedback: An LLM-as-a-Judge Dataset for Aligning Large Language Models to Coding Preferences}, author={Martin Weyssow and Aton Kamanda and Houari Sahraoui}, year={2024}, eprint={2403.09032}, archivePrefix={arXiv}, primaryClass={cs.SE} }

AI搜集汇总

数据集介绍

构建方式

CodeUltraFeedback数据集的构建基于Magicoder Evol-Instruct数据集,从中随机抽取了10,000个样本,每个样本都标有五个编码偏好之一。随后,从14个不同的LLM中随机选择4个LLM生成响应,并使用GPT-3.5作为‘LLM-as-a-Judge’来评估这些响应与编码偏好的对齐程度,生成数值评分和文本反馈。这一过程确保了数据集的多样性和高质量的反馈,为LLM的偏好调优提供了坚实的基础。

特点

CodeUltraFeedback数据集的显著特点在于其复杂性和多样性。每个指令都与五个编码偏好之一相关联,涵盖了从指令遵循到代码复杂性和效率等多个维度。此外,数据集包含了来自14个不同LLM的40,000个响应,这些响应经过GPT-3.5的严格评估,确保了反馈的准确性和一致性。这种结构使得数据集不仅适用于LLM的偏好调优,还能用于评估和比较不同LLM在编码偏好对齐方面的表现。

使用方法

CodeUltraFeedback数据集主要用于通过监督微调(SFT)和直接偏好优化(DPO)来调优LLM,使其更好地对齐编码偏好。研究者可以利用数据集中的指令和响应对LLM进行微调,然后通过DPO进一步优化模型,使其在生成代码时更加符合开发者的预期。此外,数据集还可用于构建基准测试,如CODAL-Bench,以系统地评估和比较不同LLM在编码偏好对齐方面的性能。

背景与挑战

背景概述

随着大型语言模型(LLMs)在代码生成领域的快速发展,如何确保这些模型生成的代码不仅功能正确,而且符合开发者的非功能性需求,如代码可读性、效率和最佳实践,成为一个关键问题。CodeUltraFeedback数据集由蒙特利尔大学的Martin Weyssow、Aton Kamanda和Houari Sahraoui等人于2024年创建,旨在通过AI反馈调整和校准LLMs以符合编码偏好。该数据集包含10,000个复杂指令和40,000个由14种不同LLMs生成的响应,通过GPT-3.5的LLM-as-a-Judge方法进行标注,生成数值和文本反馈。CodeUltraFeedback不仅填补了现有基准在评估LLMs与非功能性需求对齐方面的空白,还为未来的模型校准和强化学习从AI反馈(RLAIF)提供了基础。

当前挑战

CodeUltraFeedback数据集面临的挑战主要集中在两个方面。首先,现有基准依赖自动化指标和静态分析工具,无法捕捉用户指令和LLMs输出中的细微差别,这凸显了构建大规模数据集和基准的必要性。其次,数据集构建过程中,如何确保多样性和代表性的LLMs响应,以及如何通过LLM-as-a-Judge方法进行有效标注,都是技术上的难题。此外,评估LLMs与编码偏好的对齐度时,如何平衡功能正确性和非功能性需求,以及如何减少对闭源模型(如GPT-3.5和GPT-4)的依赖,也是未来研究的重要方向。

常用场景

经典使用场景

CodeUltraFeedback 数据集的经典使用场景在于通过大规模的复杂指令和多样化的语言模型生成的响应,来评估和调整大型语言模型(LLMs)与用户定义的编码偏好之间的对齐。该数据集通过 AI 反馈的强化学习(RLAIF)和直接偏好优化(DPO)技术,帮助模型生成更符合编码偏好的高质量代码。

实际应用

在实际应用中,CodeUltraFeedback 数据集可用于训练和优化代码生成模型,使其生成的代码更符合开发者的编码偏好,如代码可读性、效率和最佳实践。通过使用该数据集进行模型微调和偏好优化,可以显著提高模型在实际编码任务中的表现,从而在软件开发、自动化代码生成等领域发挥重要作用。

衍生相关工作

CodeUltraFeedback 数据集的发布催生了一系列相关研究工作,包括基于该数据集的模型对齐技术、偏好优化算法以及新的基准测试方法。例如,CODAL-Bench 基准测试的提出,为评估模型对编码偏好的对齐提供了标准化的工具。此外,该数据集还激发了对 AI 反馈数据在模型训练中应用的深入研究,推动了代码智能领域的进一步发展。

以上内容由AI搜集并总结生成