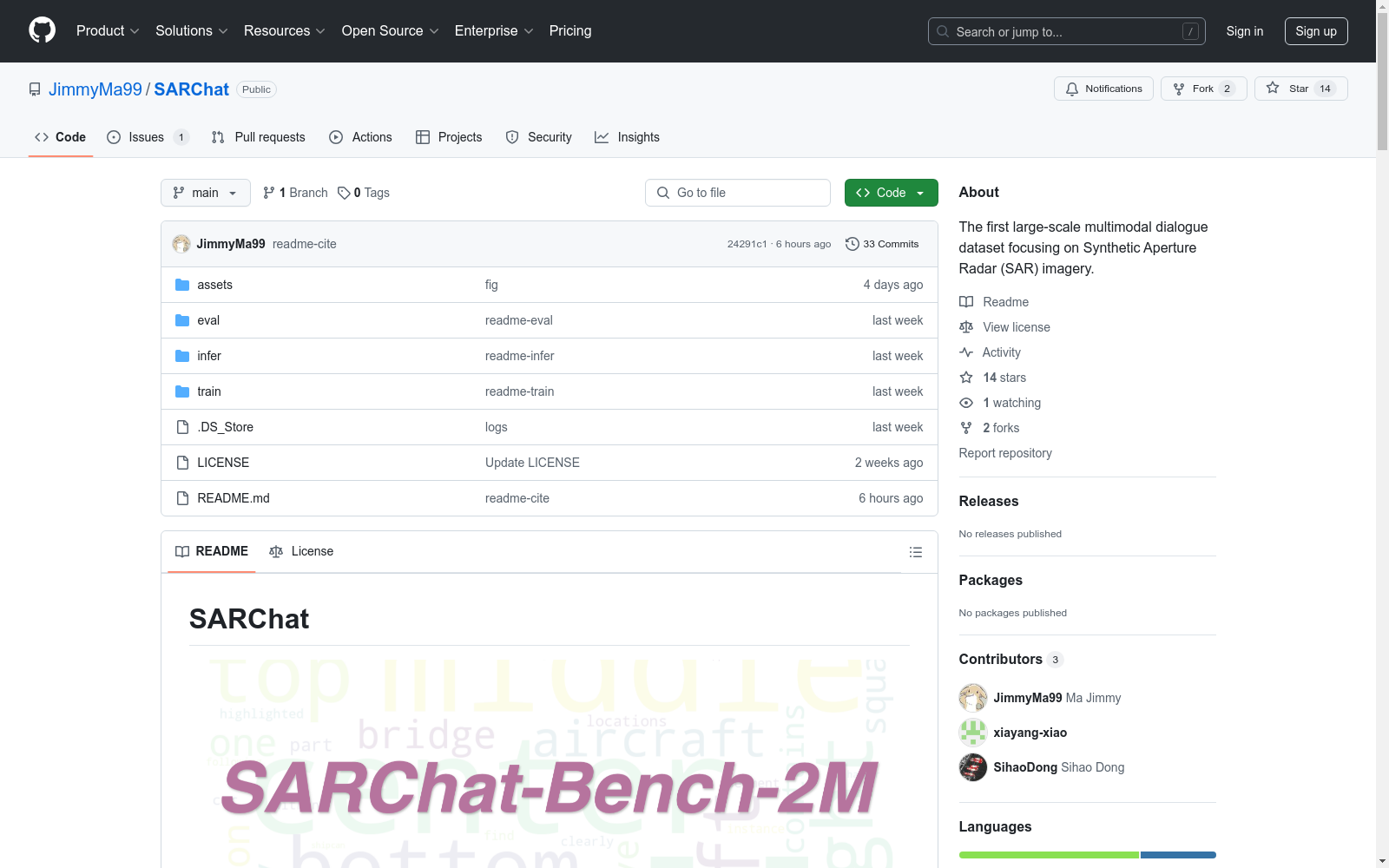

SARChat-2M|合成孔径雷达图像处理数据集|视觉语言模型数据集

收藏

- 1SARChat-Bench-2M: A Multi-Task Vision-Language Benchmark for SAR Image Interpretation复旦大学信息科学与技术学院、中国教育部电磁波信息科学重点实验室 · 2025年

中国区域地面气象要素驱动数据集 v2.0(1951-2024)

中国区域地面气象要素驱动数据集(China Meteorological Forcing Data,以下简称 CMFD)是为支撑中国区域陆面、水文、生态等领域研究而研发的一套高精度、高分辨率、长时间序列数据产品。本页面发布的 CMFD 2.0 包含了近地面气温、气压、比湿、全风速、向下短波辐射通量、向下长波辐射通量、降水率等气象要素,时间分辨率为 3 小时,水平空间分辨率为 0.1°,时间长度为 74 年(1951~2024 年),覆盖了 70°E~140°E,15°N~55°N 空间范围内的陆地区域。CMFD 2.0 融合了欧洲中期天气预报中心 ERA5 再分析数据与气象台站观测数据,并在辐射、降水数据产品中集成了采用人工智能技术制作的 ISCCP-ITP-CNN 和 TPHiPr 数据产品,其数据精度较 CMFD 的上一代产品有显著提升。 CMFD 历经十余年的发展,其间发布了多个重要版本。2019 年发布的 CMFD 1.6 是完全采用传统数据融合技术制作的最后一个 CMFD 版本,而本次发布的 CMFD 2.0 则是 CMFD 转向人工智能技术制作的首个版本。此版本与 1.6 版具有相同的时空分辨率和基础变量集,但在其它诸多方面存在大幅改进。除集成了采用人工智能技术制作的辐射和降水数据外,在制作 CMFD 2.0 的过程中,研发团队尽可能采用单一来源的再分析数据作为输入并引入气象台站迁址信息,显著缓解了 CMFD 1.6 中因多源数据拼接和气象台站迁址而产生的虚假气候突变。同时,CMFD 2.0 数据的时间长度从 CMFD 1.6 的 40 年大幅扩展到了 74 年,并将继续向后延伸。CMFD 2.0 的网格空间范围虽然与 CMFD 1.6 相同,但其有效数据扩展到了中国之外,能够更好地支持跨境区域研究。为方便用户使用,CMFD 2.0 还在基础变量集之外提供了若干衍生变量,包括近地面相对湿度、雨雪分离降水产品等。此外,CMFD 2.0 摒弃了 CMFD 1.6 中通过 scale_factor 和 add_offset 参数将实型数据化为整型数据的压缩技术,转而直接将实型数据压缩存储于 NetCDF4 格式文件中,从而消除了用户使用数据时进行解压换算的困扰。 本数据集原定版本号为 1.7,但鉴于本数据集从输入数据到研制技术都较上一代数据产品有了大幅的改变,故将其版本号重新定义为 2.0。

国家青藏高原科学数据中心 收录

Granary

Granary是一个包含25种欧洲语言的大规模语音识别和翻译数据集,由NVIDIA等多家机构联合创建。数据集通过伪标签技术生成,旨在解决低资源语言的语音处理问题。数据集包含约643,237.57小时的语音数据,经过精心筛选和处理,旨在提高数据质量并减少数据中的错误。该数据集可用于自动语音识别(ASR)和自动语音翻译(AST)等领域的研究,有助于提高语音模型在低资源语言上的准确性和鲁棒性。

arXiv 收录

Paper III (Walker et al. 2024)

Data products used in 3-D CMZ Paper III, Walker et al. (2024). The full cloud catalogue is provided in tabular format, along with a full CMZ map showing the clouds and their assigned IDs. For each cloud ID in the published catalogue there are: - Individual cube cutouts from the MOPRA 3mm CMZ survey (HC3N, HCN, and HNCO). - Individual cube cutouts from the APEX 1mm CMZ survey (13CO, C18O, and H2CO). - Cloud-averaged spectra of the ATCA H2CO 4.83 GHz line. - PV slices of the ATCA H2CO 4.83 GHz line, taken across the major axis of the source. - Where applicable, there are mask files which correspond to the different velocity components of the cloud. In these cases, there are two mask files per velocity component, corresponding to the different masking approaches described in the paper.

DataCite Commons 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

CMU-MOSI

CMU-MOSI数据集包括了从93个YouTube的视频中获取的2199个独白类型的短视频片段。每个片段都是一个独立的多模态示例,其中图像、文本和音频占比是均匀的,情感分数取值为[-3,+3],表示从强负向到强正向情感。

DataCite Commons 收录