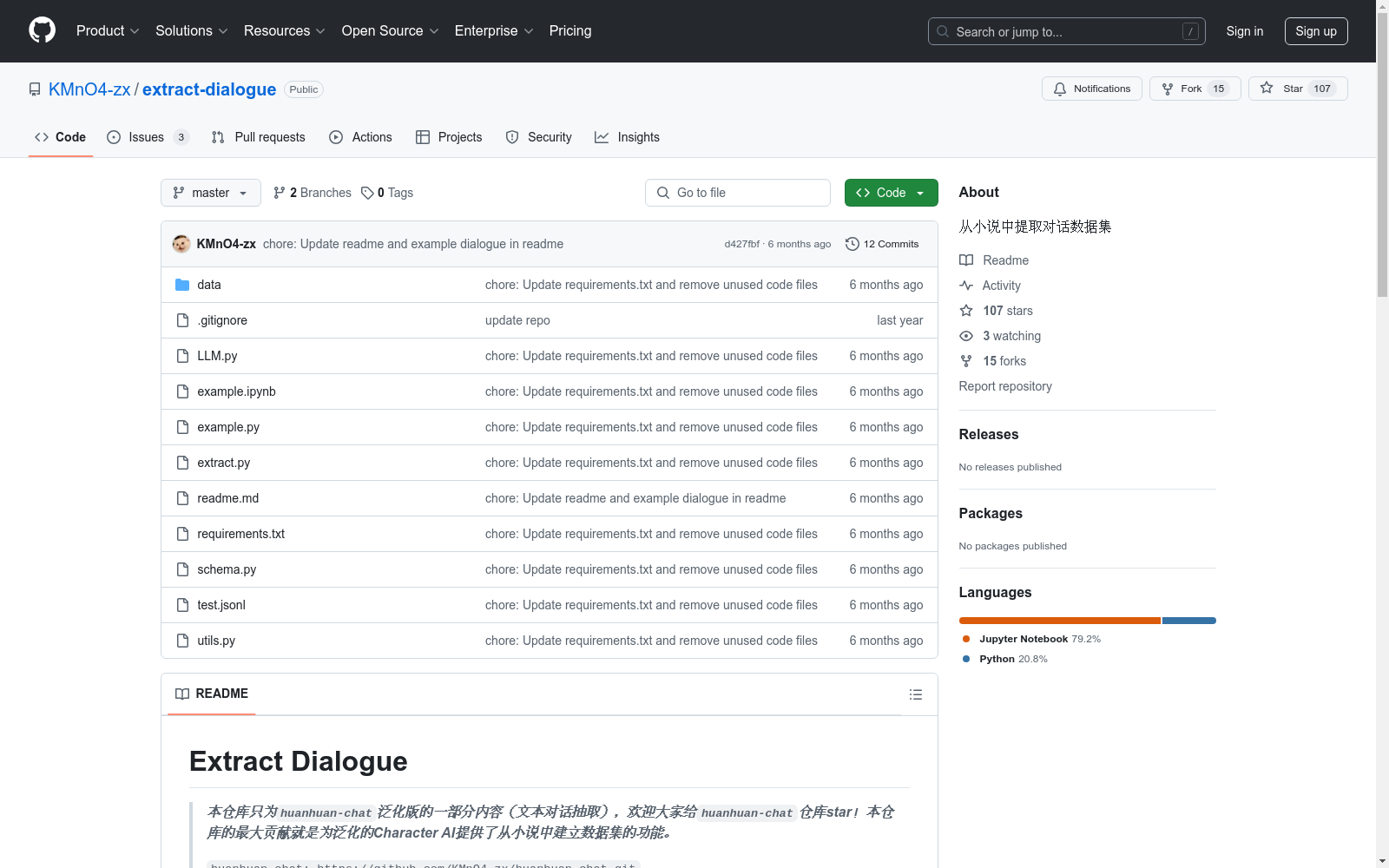

extract-dialogue|文本处理数据集|对话提取数据集

收藏数据集概述

数据集名称

- Extract Dialogue

数据集描述

- 本项目利用

chatgpt从小说中提取对话集,提取的样本中包括role(角色)和dialogue(对话)。

数据集内容示例

json { "role": "艾伦", "dialogue": "不,不要提,这真是太倒霉了!我从楼梯上摔了下去,出现了较为严重的骨裂,只能打石膏做固定。" } { "role": "克莱恩", "dialogue": "真是不够走运啊。" }

数据集使用方法

- 克隆仓库:

git clone https://github.com/KMnO4-zx/extract-dialogue.git - 切换目录:

cd extract-dialogue - 安装依赖:

pip install -r requirements.txt - 创建

.env文件:填入DEEPSEEK_API - 放置小说或文本:放到当前目录,并在

example.py中修改path - 修改

schema.py:建议结合要提取的小说修改schema示例 - 运行

example.py:python example.py

数据集输出示例

json {"role": "克莱恩", "dialogue": "在帮警察们调查那起连环杀人案,虽然不一定能有收获,但赏金足够诱人,而且,和警察部门建立良好的关系对我们私家侦探来说非常重要。"} {"role": "塔利姆", "dialogue": "这果然是大侦探忙碌的事情。"} {"role": "塔利姆", "dialogue": "莫里亚蒂先生,我能请教一个问题吗?"} {"role": "克莱恩", "dialogue": "这单免费,还有,叫我夏洛克就行了。"} {"role": "塔利姆", "dialogue": "我有个朋友,爱上了不该爱的人,这种情况该怎么处理?"} {"role": "克莱恩", "dialogue": "我唯一的建议是,不要犯法。"} {"role": "克莱恩", "dialogue": "首先,我们要弄清楚‘不该’是源于什么?双方的家庭之间有仇恨关系?"} {"role": "塔利姆", "dialogue": "不,这不是《罗密欧与朱丽叶》的故事!"}

中国劳动力动态调查

“中国劳动力动态调查” (China Labor-force Dynamics Survey,简称 CLDS)是“985”三期“中山大学社会科学特色数据库建设”专项内容,CLDS的目的是通过对中国城乡以村/居为追踪范围的家庭、劳动力个体开展每两年一次的动态追踪调查,系统地监测村/居社区的社会结构和家庭、劳动力个体的变化与相互影响,建立劳动力、家庭和社区三个层次上的追踪数据库,从而为进行实证导向的高质量的理论研究和政策研究提供基础数据。

中国学术调查数据资料库 收录

UCM-Captions, Sydney-Captions, RSICD, RSITMD, NWPU-Captions, RS5M, SkyScript

UCM-Captions: 包含613张图像,分辨率为256×256。Sydney-Captions: 包含2,100张图像,分辨率为500×500。RSICD: 包含10,921张图像,分辨率为224×224。RSITMD: 包含4,743张图像,分辨率为256×256。NWPU-Captions: 包含31,500张图像,分辨率为256×256。RS5M: 包含超过500万张图像,分辨率为所有可能的分辨率。SkyScript: 包含520万张图像,分辨率为所有可能的分辨率。

github 收录

jpft/danbooru2023

Danbooru2023是一个大规模的动漫图像数据集,包含超过500万张由爱好者社区贡献并详细标注的图像。图像标签涵盖角色、场景、版权、艺术家等方面,平均每张图像有30个标签。该数据集可用于训练图像分类、多标签标注、角色检测、生成模型等多种计算机视觉任务。数据集基于danbooru2021构建,扩展至包含ID #6,857,737的图像,增加了超过180万张新图像,总大小约为8TB。图像以原始格式提供,分为1000个子目录,使用图像ID的模1000进行分桶,以避免文件系统性能问题。

hugging_face 收录

UniMed

UniMed是一个大规模、开源的多模态医学数据集,包含超过530万张图像-文本对,涵盖六种不同的医学成像模态:X射线、CT、MRI、超声、病理学和眼底。该数据集通过利用大型语言模型(LLMs)将特定模态的分类数据集转换为图像-文本格式,并结合现有的医学领域的图像-文本数据,以促进可扩展的视觉语言模型(VLM)预训练。

github 收录

flames-and-smoke-datasets

该仓库总结了多个公开的火焰和烟雾数据集,包括DFS、D-Fire dataset、FASDD、FLAME、BoWFire、VisiFire、fire-smoke-detect-yolov4、Forest Fire等数据集。每个数据集都有详细的描述,包括数据来源、图像数量、标注信息等。

github 收录