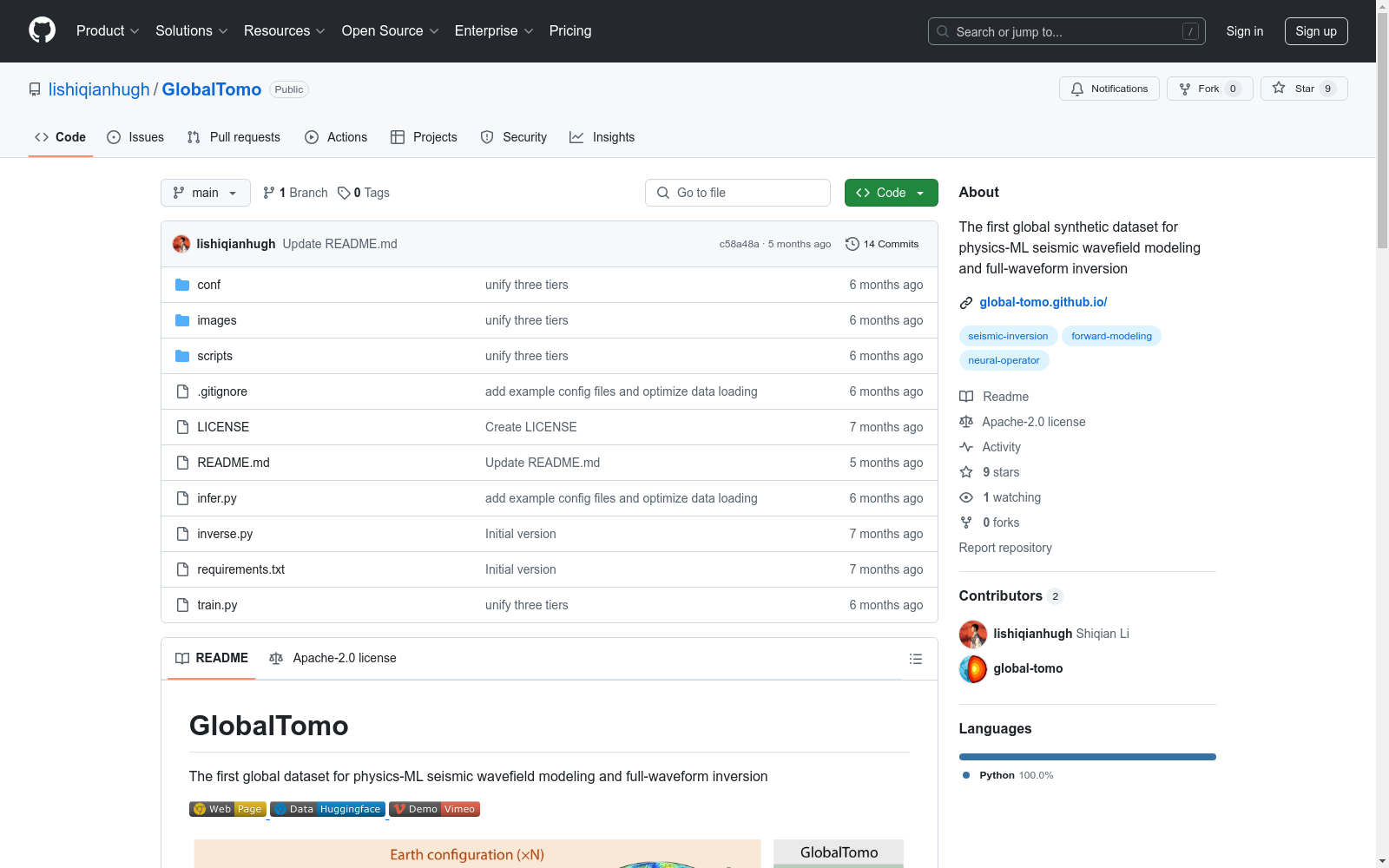

GlobalTomo|地震学数据集|机器学习数据集

收藏GlobalTomo 数据集概述

数据集结构

GlobalTomo/

│

├── conf/

│ ├── config.yaml # 配置文件

│

├── images/

│ └── overview.jpg

│

├── scripts/

│ ├── eq.py # PDE约束定义

│ ├── load_data.py # 从.h5文件加载数据

│ ├── meta_info.py # 数据元信息

│ ├── misc.py # 定制训练工具

│ ├── model.py # 定制ML模型

│ └── plot.py # 可视化工具

│

├── .gitignore # Git忽略内容

├── infer.py # 评估函数

├── inverse.py # 反演函数

├── LICENSE # 许可证

├── README.md # 使用说明

├── requirements.txt # 依赖项

└── train.py # 训练脚本

开始使用

conda create -n globaltomo python==3.8 conda activate globaltomo pip install -r requirements.txt

训练正向模型

在conf目录中定义训练配置文件。提供示例YAML文件以方便开始。通常,应在这些文件中指定数据层级、模型类型和期望输出。确保配置中的custom.name与文件名匹配。

启动训练的命令:

python train.py --config-name=acoustic_wfslice_MLP

训练完成后,检查点将自动存储在outputs目录中。

评估正向模型

在infer.py中指定wave_type、output_type和model_name。

启动评估的命令:

python infer.py

如果模型路径存在,代码将自动加载配置和模型参数进行评估。

反演

1. 基于优化的反演

在inverse.py中指定模型路径,执行以下命令开始从随机起点优化结构:

python inverse.py

2. 直接反向映射

训练神经网络直接将观测地震图映射到速度结构。创建配置文件,设置custom.velocity为true,并定义其他参数。使用类似训练正向模型的命令:

python train.py --config-name=acoustic_velocity_MLP

数据下载

点击此链接并填写请求表单以访问数据。

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio 收录

Figshare

Figshare是一个在线数据共享平台,允许研究人员上传和共享各种类型的研究成果,包括数据集、论文、图像、视频等。它旨在促进科学研究的开放性和可重复性。

figshare.com 收录

FER2013

FER2013数据集是一个广泛用于面部表情识别领域的数据集,包含28,709个训练样本和7,178个测试样本。图像属性为48x48像素,标签包括愤怒、厌恶、恐惧、快乐、悲伤、惊讶和中性。

github 收录

HIT-UAV

HIT-UAV数据集包含2898张红外热成像图像,这些图像从43,470帧无人机拍摄的画面中提取。数据集涵盖了多种场景,如学校、停车场、道路和游乐场,在不同的光照条件下,包括白天和夜晚。

github 收录

flames-and-smoke-datasets

该仓库总结了多个公开的火焰和烟雾数据集,包括DFS、D-Fire dataset、FASDD、FLAME、BoWFire、VisiFire、fire-smoke-detect-yolov4、Forest Fire等数据集。每个数据集都有详细的描述,包括数据来源、图像数量、标注信息等。

github 收录