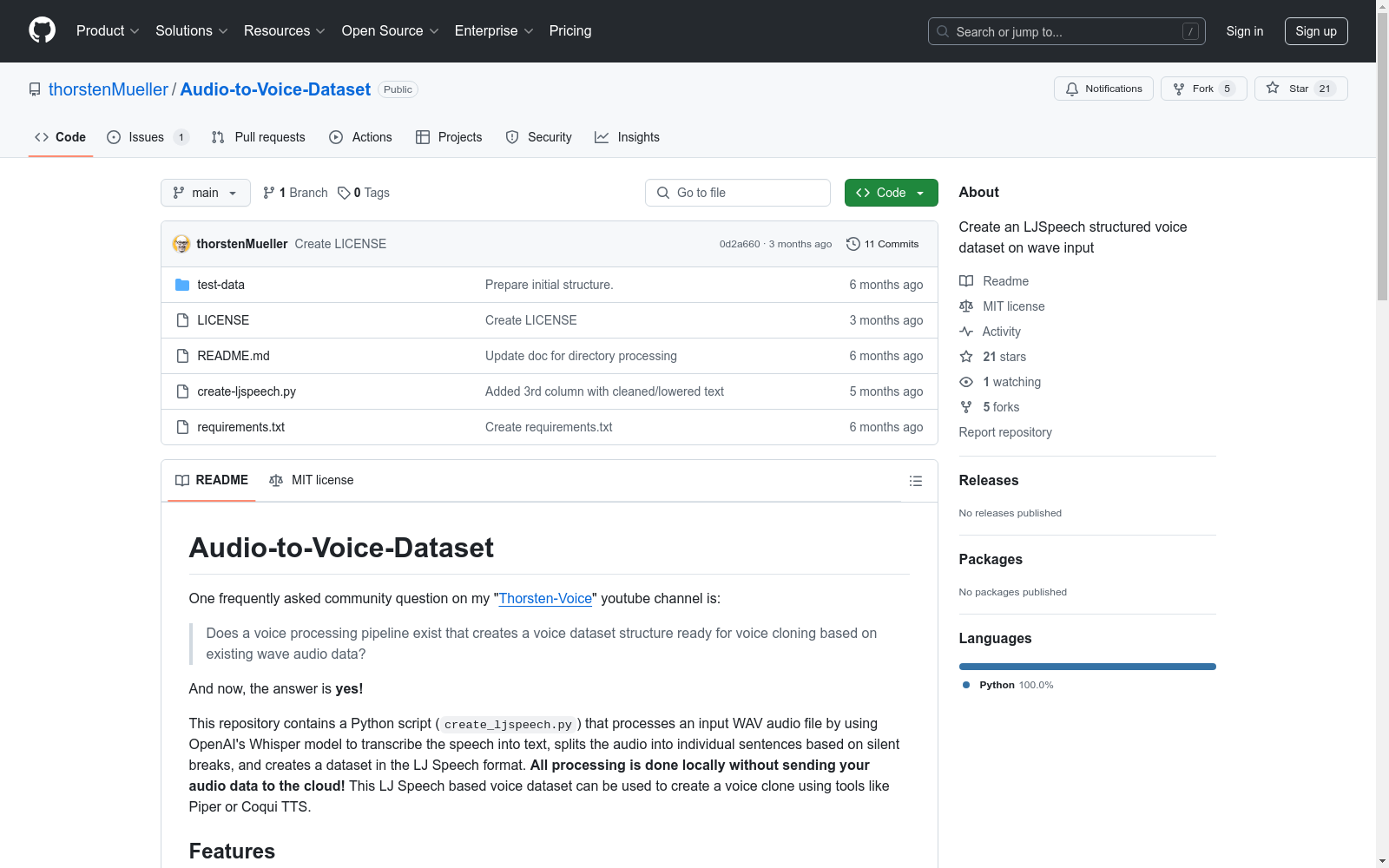

LJSpeech based voice dataset|语音合成数据集|语音识别数据集

收藏Audio-to-Voice-Dataset

概述

该数据集通过使用OpenAI的Whisper模型将现有的WAV音频数据转换为文本,并根据静音间隔将音频分割成单独的句子,创建一个LJ Speech格式的语音数据集,可用于语音克隆。所有处理均在本地进行,无需将音频数据发送到云端。

功能

- 使用OpenAI的Whisper模型将语音转录为文本。

- 根据较长的静音间隔将多个音频文件分割成句子。

- 将每个句子保存为单独的WAV文件。

- 生成一个元数据CSV文件,将每个句子映射到其对应的音频文件。

前提条件

确保已安装Python,并安装以下Python库:

openai-whisperpydubpandas

可以使用以下命令安装这些依赖项: bash pip install openai-whisper pydub pandas

使用方法

- 准备音频文件:将输入的WAV文件放置在一个目录中,并记下其路径。

- 更新脚本:修改脚本中的

audio_path变量,指向输入的WAV文件。 - 根据个人录音调整

min_silence_len和keep_silence的值(速度和句子间的间隔)。 - 运行脚本:执行脚本,它将处理音频文件,分割成句子,并将每个句子保存为单独的WAV文件在输出目录的音频目录中。同时,它会在输出目录中创建一个

metadata.csv文件,包含句子及其对应的音频文件ID。

输出

- 音频文件:脚本将在输出目录的音频目录中为每个句子创建单独的WAV文件。

- CSV文件:脚本将在输出目录中生成一个

metadata.csv文件,包含转录的句子和对应的音频文件ID。

示例

运行脚本后,输出目录可能如下所示:

output/ ├── audio/ │ ├── LJ0001.wav │ ├── LJ0002.wav │ ├── LJ0003.wav │ └── ... └── metadata.csv

metadata.csv文件内容如下:

LJ0001|Hello, world. LJ0002|This is a test. LJ0003|How are you?

注意事项

- Whisper模型的转录过程可能需要一些时间,尤其是对于较长的音频文件。

- 为了获得最佳结果,确保输入音频文件具有清晰的语音和最小的背景噪音。

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

Solar Radiation Data

该数据集包含全球多个地点的太阳辐射数据,涵盖了不同时间段和气象条件下的辐射强度。数据包括直接辐射、散射辐射和总辐射等指标,适用于太阳能资源评估和气候研究。

www.nrel.gov 收录

LinkedIn Salary Insights Dataset

LinkedIn Salary Insights Dataset 提供了全球范围内的薪资数据,包括不同职位、行业、地理位置和经验水平的薪资信息。该数据集旨在帮助用户了解薪资趋势和市场行情,支持职业规划和薪资谈判。

www.linkedin.com 收录

EdNet

圣诞老人收集的各种学生活动的大规模分层数据集,一个配备人工智能辅导系统的多平台自学解决方案。 EdNet 包含 2 年多来收集的 784,309 名学生的 131,441,538 次互动,这是迄今为止向公众发布的 ITS 数据集中最大的。资料来源:EdNet:教育中的大规模分层数据集

OpenDataLab 收录

LIDC-IDRI

LIDC-IDRI 数据集包含来自四位经验丰富的胸部放射科医师的病变注释。 LIDC-IDRI 包含来自 1010 名肺部患者的 1018 份低剂量肺部 CT。

OpenDataLab 收录