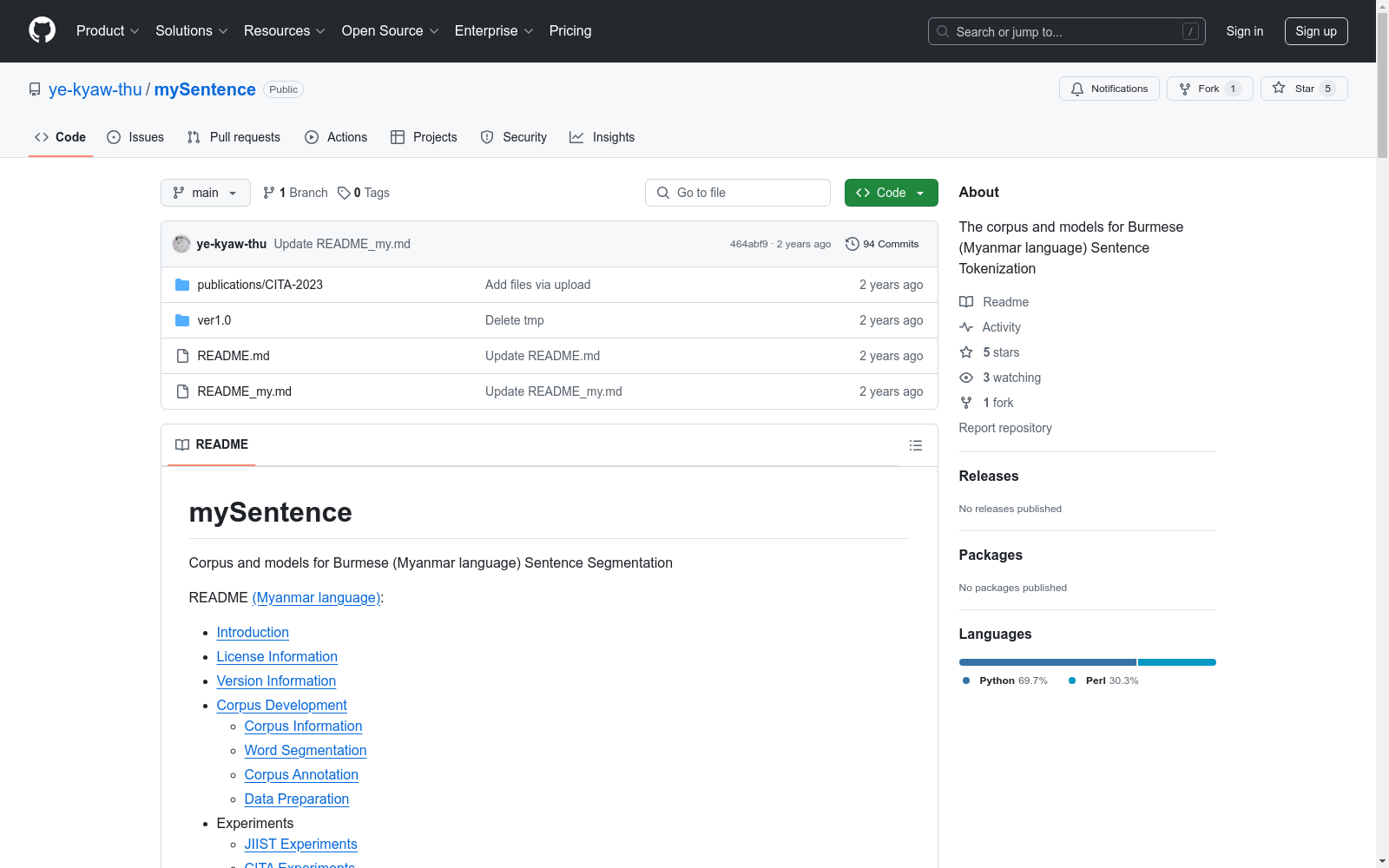

mySentence Corpus|缅甸语数据集|句子分割数据集

收藏数据集概述

数据集名称

- mySentence

数据集目的

- 用于缅甸语(Myanmar language)句子分割的语料库和模型。

数据集内容

-

语料库信息

- 数据来源包括myPOS ver3.0、Covid-19 Q&A、Shared By Louis Augustine Page、Maung Zis Tales Page、Wikipedia等。

- 总计包含47,127个句子,8,465个段落。

-

词分割

- 使用myWord工具进行词分割,并手动审核结果。

-

语料库标注

- 对语料库中的每个词进行标注,使用B(Begin)、O(Other)、N(Next)和E(End)四种标签。

- 若序列中包含两个以上的E标签,则视为段落。

-

数据准备

- 准备了两类数据:仅包含句子的数据和同时包含句子与段落的数据。

- 数据被分割为训练、开发和测试集。

数据集版本

- 版本 1.0

- 发布日期:2023年7月30日

数据集格式

- 提供了CRF格式和并行格式的数据,用于不同的实验和模型训练。

许可证信息

- Creative Commons Attribution-NonCommercial-Share Alike 4.0 International (CC BY-NC-SA 4.0)

贡献者

- Ye Kyaw Thu

- Thura Aung

相关出版物

- Ye Kyaw Thu, Thura Aung, Thepchai Supnithi, "Neural Sequence Labeling based Sentence Segmentation for Myanmar Language", the 12th Conference on Information Technology and its applications (CITA 2023).

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

Subway Dataset

该数据集包含了全球多个城市的地铁系统数据,包括车站信息、线路图、列车时刻表、乘客流量等。数据集旨在帮助研究人员和开发者分析和模拟城市交通系统,优化地铁运营和乘客体验。

www.kaggle.com 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录