BBC-Dataset-News-Classification|新闻分类数据集|文本分析数据集

收藏github2019-12-05 更新2024-05-31 收录

下载链接:

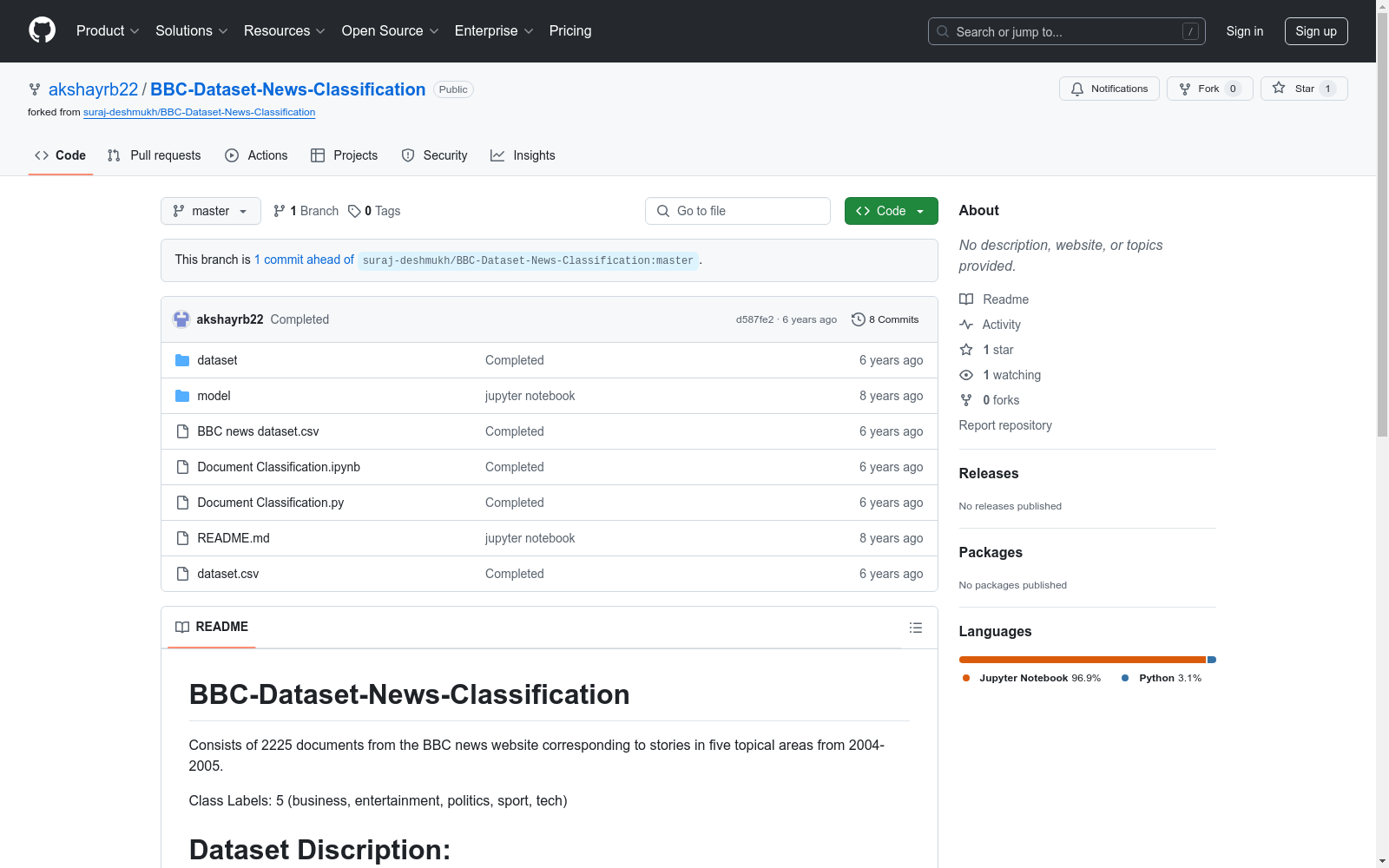

https://github.com/akshayrb22/BBC-Dataset-News-Classification

下载链接

链接失效反馈资源简介:

包含2004-2005年间BBC新闻网站上的2225篇新闻文档,涵盖五个主题领域:商业、娱乐、政治、体育和技术。

This dataset comprises 2,225 news articles from the BBC News website, spanning the years 2004 to 2005. It covers five thematic areas: business, entertainment, politics, sports, and technology.

创建时间:

2019-04-08

原始信息汇总

数据集概述

数据集名称

BBC-Dataset-News-Classification

数据集内容

- 文档数量:2225篇

- 来源:BBC新闻网站

- 时间范围:2004-2005年

- 主题领域:5个(商业、娱乐、政治、体育、科技)

数据集结构

- 文件描述:

dataset/data_files:包含多个新闻txt文件的数据文件夹。dataset/dataset.csv:包含“新闻”和“类型”两列的csv文件。其中“新闻”列代表新闻文章,“类型”列代表新闻类别。model/get_data.py:用于将所有txt文件整合成一个包含两列(“新闻”,“类型”)的csv文件。model/model.py:包含预处理、tf-idf特征提取、模型构建和评估的脚本。model/test.ipynb:Jupyter笔记本文件。

数据集划分

- 训练集:1780个样本

- 测试集:445个样本

评估结果

- 准确率:0.9573

- Kappa系数:0.9461

AI搜集汇总

数据集介绍

构建方式

BBC-Dataset-News-Classification数据集的构建,始于对BBC新闻网站2004-2005年间五个主题领域的2225篇文档的采集。数据集的构建过程包括了对原始文本文件的整理,通过特定的脚本处理生成了包含新闻文章和类别标签的CSV文件,进而划分为训练集和测试集,以便于后续的模型训练和评估。

使用方法

使用BBC-Dataset-News-Classification数据集时,用户首先需要下载并解压数据集,然后可以利用提供的Python脚本将文本文件整合为CSV格式。之后,用户可以根据需要,使用数据集中的训练集来训练模型,并利用测试集来评估模型的性能。数据集附带的Jupyter Notebook也为用户提供了一个便捷的实验环境。

背景与挑战

背景概述

BBC-Dataset-News-Classification数据集,创建于21世纪初,源自爱尔兰都柏林大学学院(UCD)的研究项目。该数据集汇集了2004至2005年间BBC新闻网站上的2225篇文档,涉及五个主题领域:商业、娱乐、政治、体育和科技。它旨在为文本分类研究提供基准,帮助研究人员探索新闻文本的自动化分类问题,对自然语言处理和机器学习领域产生了显著影响。

当前挑战

数据集构建过程中,研究人员面临了多方面的挑战。首先,确保数据的多样性和代表性是一大挑战。其次,构建过程中涉及到的文本预处理、特征提取和模型评估等步骤均需要精细的设计与实施。此外,该数据集在解决新闻分类领域问题时,需要克服多类别分类的准确性挑战,提高分类模型的Kappa系数和准确度。

常用场景

经典使用场景

在自然语言处理与文本分类研究领域,BBC-Dataset-News-Classification数据集的典型应用场景是对新闻文本进行分类。该数据集包含了五个主题领域的新闻文章,为研究者提供了一个基准,以训练和评估分类模型的性能,进而实现对新闻文本的自动化分类。

解决学术问题

该数据集解决了文本分类中的多类别识别问题,特别是在新闻分类领域,有助于研究者在不同类别间建立高效的分类界限。其提供的标注数据使得模型可以在实际应用中区分商业、娱乐、政治、体育和技术等不同类型的新闻,对提高文本分类模型的准确性和鲁棒性具有重要的学术价值。

实际应用

在实际应用中,BBC-Dataset-News-Classification数据集可用于构建新闻推荐系统、内容审核工具以及信息过滤服务。它使得计算机能够对大量新闻内容进行快速而准确的分类,提高了信息处理的效率和质量。

数据集最近研究

最新研究方向

在文本分类领域,BBC-Dataset-News-Classification数据集近期被广泛用于探索新闻文本的自动化分类技术。研究者们致力于提升分类算法的精确度与效率,以实现对新闻的五类主题(商业、娱乐、政治、体育、科技)快速准确归类。当前研究聚焦于深度学习模型的优化,包括模型的结构调整与参数优化,以及利用tf-idf等特征提取技术提升分类性能。此外,该数据集在信息检索、自然语言处理等领域的研究中也具有重要价值,其应用不仅推动了新闻内容的智能处理,也为理解大规模文本数据中的主题分布提供了有力支撑。

以上内容由AI搜集并总结生成