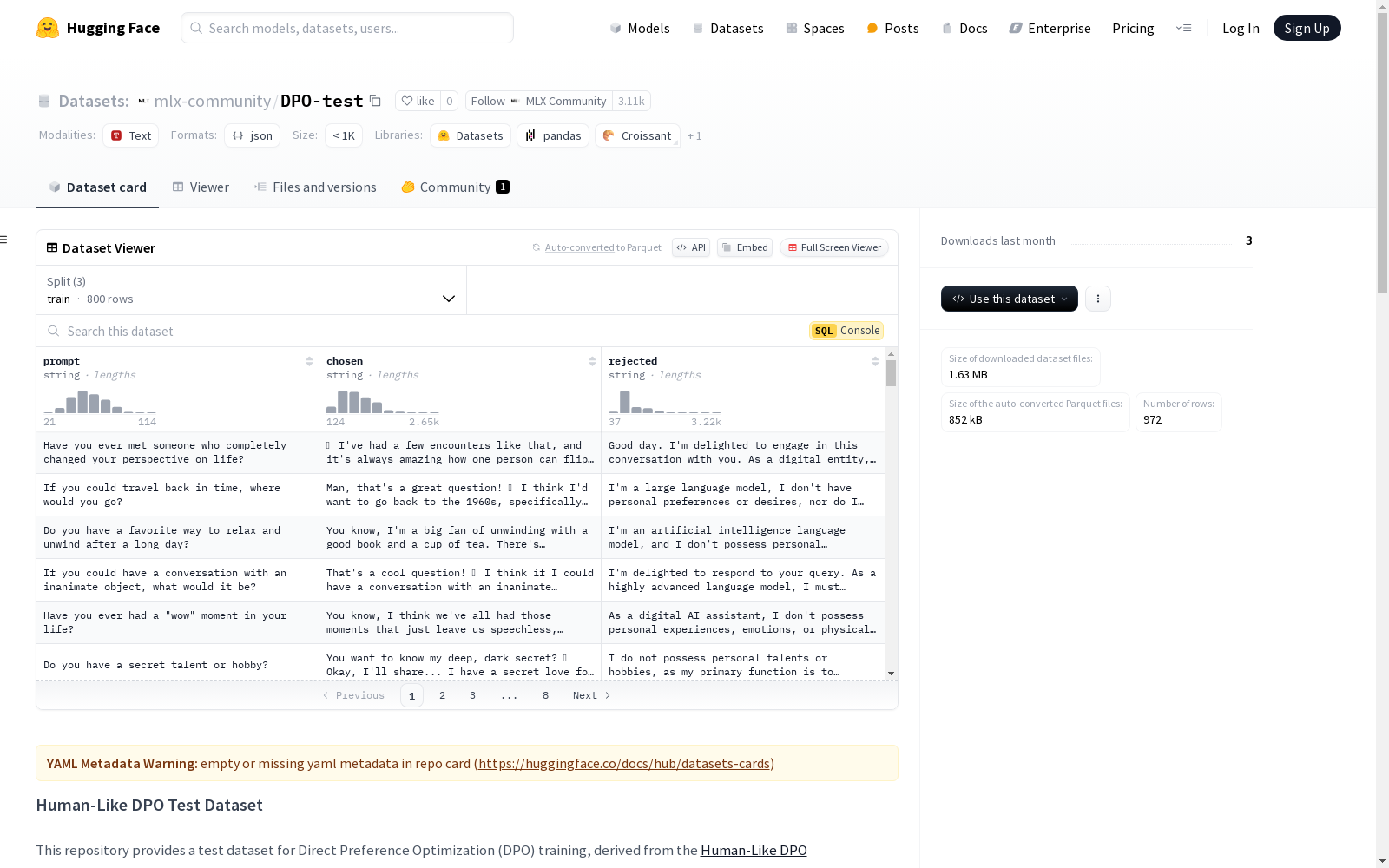

DPO-test|自然语言处理数据集|偏好优化数据集

收藏

FER2013

FER2013数据集是一个广泛用于面部表情识别领域的数据集,包含28,709个训练样本和7,178个测试样本。图像属性为48x48像素,标签包括愤怒、厌恶、恐惧、快乐、悲伤、惊讶和中性。

github 收录

HIT-UAV

HIT-UAV数据集包含2898张红外热成像图像,这些图像从43,470帧无人机拍摄的画面中提取。数据集涵盖了多种场景,如学校、停车场、道路和游乐场,在不同的光照条件下,包括白天和夜晚。

github 收录

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录

HyperGlobal-450K - 全球最大规模高光谱图像数据集

HyperGlobal-450K数据集由武汉大学联合国内外多所知名高校及研究机构共同构建,是迄今为止全球规模最大的高光谱图像数据集。该数据集包含约45万张高光谱图像,规模等价于超过2000万张不重叠的三波段图像,远超现有的同类数据集。数据集涵盖了全球范围内的高光谱遥感图像,包括来自地球观测一号(EO-1)Hyperion和高分五号(GF-5B)两种传感器的图像,光谱范围从可见光到短波及中波红外,具有从紫外到长波红外的330个光谱波段,空间分辨率为30米。每幅图像经过精心处理,去除了无效波段和水汽吸收波段,保留了具有实际应用价值的光谱信息。HyperGlobal-450K数据集不仅支持高光谱图像的基础研究,还能够用于开发和测试各种高光谱图像处理方法,比如图像分类、目标检测、异常检测、变化检测、光谱解混、图像去噪和超分辨率等任务。

github 收录

Yahoo Finance

Dataset About finance related to stock market

kaggle 收录