GigaHands|手部姿态识别数据集|计算机视觉数据集

收藏GigaHands数据集概述

基本信息

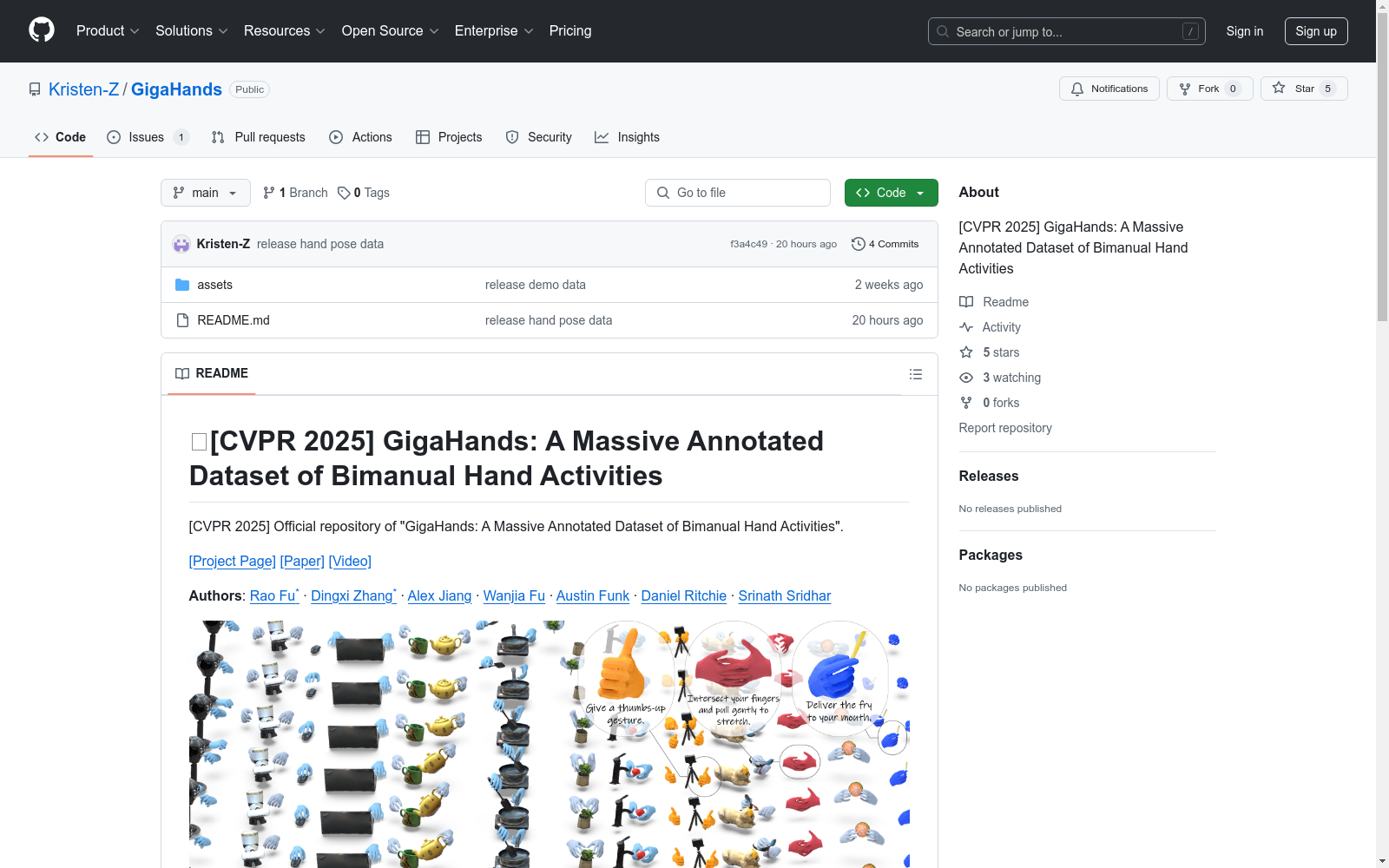

- 数据集名称: GigaHands: A Massive Annotated Dataset of Bimanual Hand Activities

- 会议/年份: CVPR 2025

- 项目页面: https://ivl.cs.brown.edu/research/gigahands.html

- 论文链接: https://www.arxiv.org/abs/2412.04244

- 视频介绍: https://ivl.cs.brown.edu/assets/images/projects/gigahands/gigahands_explain.mp4

作者信息

- Rao Fu*

- Dingxi Zhang*

- Alex Jiang

- Wanjia Fu

- Austin Funk

- Daniel Ritchie

- Srinath Sridhar

数据格式

演示数据

-

包含内容: 5个运动序列

-

目录结构:

demo_data/ ├── hand_pose/ ├── p<participant id>-<scene>-<squence id>/ ├── bboxes/ # 2D关键点跟踪的边界框 ├── keypoints_2d/ # 2D手部关键点 ├── keypoints_3d/ # 3D手部关键点 ├── mano_vid/ # MANO参数可视化 ├── params/ # MANO参数 ├── rgb_vid/ # 原始多视角视频 ├── repro_2d_vid/ # 2D手部关键点可视化 ├── repro_3d_vid/ # 3D手部关键点可视化 ├── optim_params.txt # 相机参数 └── object_pose ├── p<participant id>-<scene>-<squence id>/ ├── mesh # 重建的对象网格 ├── pose # 对象姿态 ├── render # 对象姿态可视化 ├── segmentation # 分割的对象帧

完整数据集

- 已发布内容: 所有手部姿态数据(包括所有

keypoints_3d和params) - 下载链接: https://g-2488dc.56197.5898.data.globus.org/hand_poses.tar.gz

数据下载

- 演示数据: https://g-2488dc.56197.5898.data.globus.org/demo_data.tar%2Cgz

- 所有注释: https://g-2488dc.56197.5898.data.globus.org/demo_all.tar.gz

- 原始数据: https://app.globus.org/file-manager?origin_id=1f1426dd-3440-4cae-8c57-4a0e6934eaf2&origin_path=%2F

发布计划

- [x] 发布演示数据

- [ ] 发布文本到运动任务的推理代码

- [ ] 发布文本到运动任务的训练代码

- [ ] 发布完整数据集

引用

bibtex @article{fu2024gigahands, title={GigaHands: A Massive Annotated Dataset of Bimanual Hand Activities}, author={Fu, Rao and Zhang, Dingxi and Jiang, Alex and Fu, Wanjia and Funk, Austin and Ritchie, Daniel and Sridhar, Srinath}, journal={arXiv preprint arXiv:2412.04244}, year={2024} }

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

DroneVehicle 大规模无人机航拍车辆检测数据集

这个数据集是天津大学的研究团队在进行无人机航拍图像的车辆检测和计数研究过程中收集和标注的。研究团队于 2020 年发布,相关论文成果为「Drone-based RGB-Infrared Cross-Modality Vehicle Detection via Uncertainty-Aware Learning」。

超神经 收录

Figshare

Figshare是一个在线数据共享平台,允许研究人员上传和共享各种类型的研究成果,包括数据集、论文、图像、视频等。它旨在促进科学研究的开放性和可重复性。

figshare.com 收录

CrowdHuman

CrowdHuman是一个用于评估人群场景中检测器性能的基准数据集。该数据集规模大、注释丰富且具有高多样性,包含训练、验证和测试集,共计47万个标注的人体实例,平均每张图像有23个人,包含各种遮挡情况。每个人体实例都标注有头部边界框、可见区域边界框和全身边界框。

github 收录

CatMeows

该数据集包含440个声音样本,由21只属于两个品种(缅因州库恩猫和欧洲短毛猫)的猫在三种不同情境下发出的喵声组成。这些情境包括刷毛、在陌生环境中隔离和等待食物。每个声音文件都遵循特定的命名约定,包含猫的唯一ID、品种、性别、猫主人的唯一ID、录音场次和发声计数。此外,还有一个额外的zip文件,包含被排除的录音(非喵声)和未剪辑的连续发声序列。

huggingface 收录