Vaihingen dataset|语义分割数据集|计算机视觉数据集

收藏数据集概述

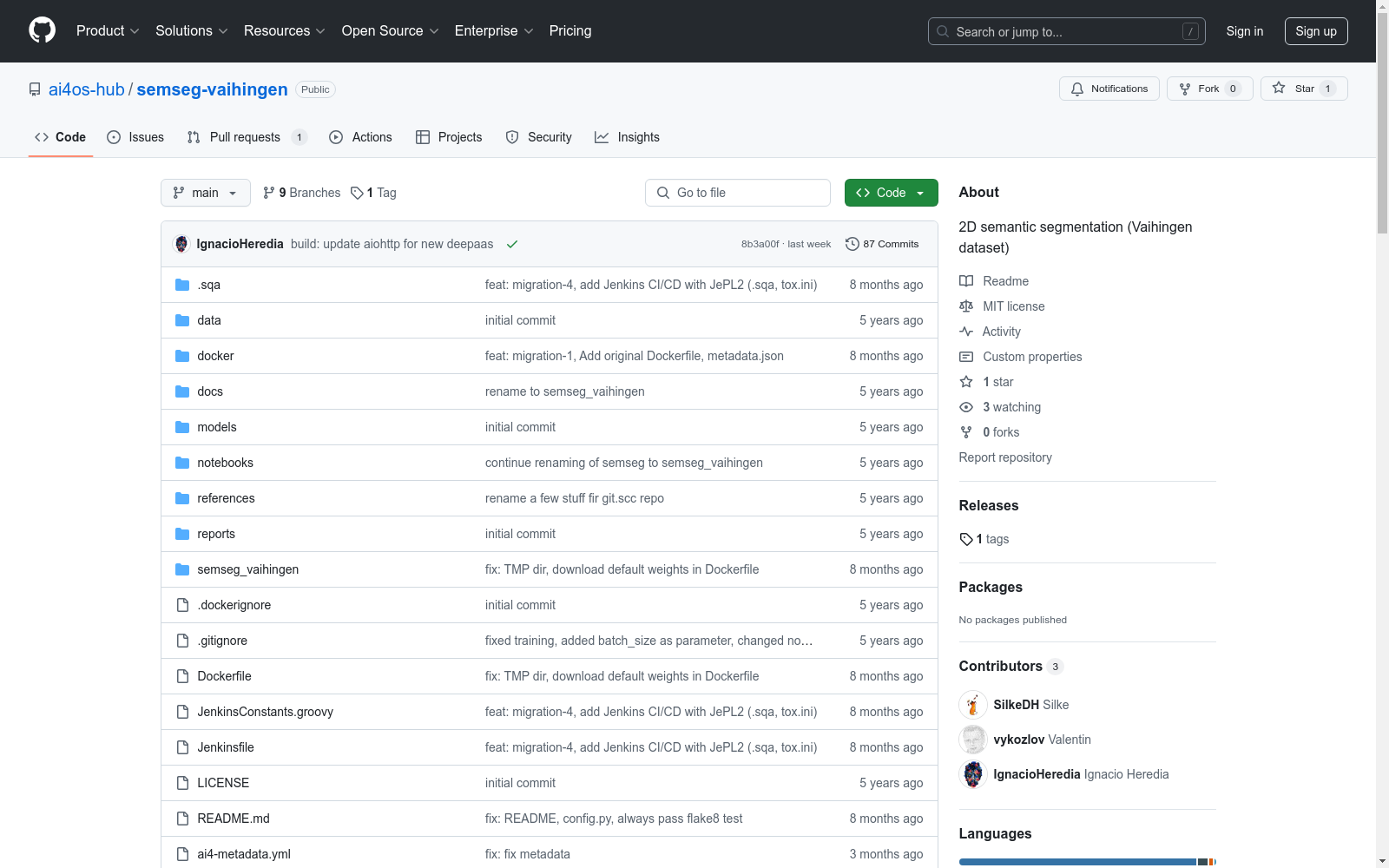

名称: 2D semantic segmentation (Vaihingen dataset)

作者: G.Cavallaro (FZJ), M.Goetz (KIT), V.Kozlov (KIT), A.Grupp (KIT), S.Donayer Holz (KIT)

项目背景: 本项目是DEEP Hybrid-DataCloud项目的一部分,该项目获得欧盟Horizon 2020研究与创新计划的资助,资助协议号为777435。

应用场景: 该数据集用于ISPRS 2D Semantic Labeling Contest,主要用于2D语义分割,即对多个对象类别进行标签分配。

数据集获取: 获取Vaihingen数据集的详细信息可参考此处。

数据集使用

安装指南:

- 本地安装: 需要Ubuntu 18.04和Python 3.6环境,具体依赖见

requirements.txt。通过Git克隆仓库并使用pip安装。 - Docker安装: 提供预配置的Docker容器,可通过Docker命令快速部署。

训练流程:

- 数据预处理: 将训练文件

vaihingen_train.hdf5和验证文件vaihingen_val.hdf5放置于./semseg-vaihingen/data目录下。 - 训练分类器: 通过Web界面选择

TRAINPOST方法进行训练,可实时监控训练状态。

预测流程:

- 使用预训练的分类器进行预测。通过Web界面的

PREDICTPOST方法,上传数据文件(支持.hdf5,.tiff,.png,.jpg格式),并选择结果输出格式(json或.pdf)。

致谢

若认为本项目有用,请考虑引用DEEP Hybrid DataCloud项目相关文献。

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录

ReferCOCO数据集

ReferCOCO数据集包括refcoco、refcoco+和refcocog三个子集,用于视觉定位任务。数据集包含图像和对应的描述性文本,用于训练和测试模型识别图像中特定对象的能力。

github 收录

MultiTalk

MultiTalk数据集是由韩国科学技术院创建,包含超过420小时的2D视频,涵盖20种不同语言,旨在解决多语言环境下3D说话头生成的问题。该数据集通过自动化管道从YouTube收集,每段视频都配有语言标签和伪转录,部分视频还包含伪3D网格顶点。数据集的创建过程包括视频收集、主动说话者验证和正面人脸验证,确保数据质量。MultiTalk数据集的应用领域主要集中在提升多语言3D说话头生成的准确性和表现力,通过引入语言特定风格嵌入,使模型能够捕捉每种语言独特的嘴部运动。

arXiv 收录

中国近海台风路径集合数据集(1945-2024)

1945-2024年度,中国近海台风路径数据集,包含每个台风的真实路径信息、台风强度、气压、中心风速、移动速度、移动方向。 数据源为获取温州台风网(http://www.wztf121.com/)的真实观测路径数据,经过处理整合后形成文件,如使用csv文件需使用文本编辑器打开浏览,否则会出现乱码,如要使用excel查看数据,请使用xlsx的格式。

国家海洋科学数据中心 收录

LUNA16

LUNA16(肺结节分析)数据集是用于肺分割的数据集。它由 1,186 个肺结节组成,在 888 次 CT 扫描中进行了注释。

OpenDataLab 收录