CULTURALBENCH|文化知识数据集|语言模型评估数据集

收藏arXiv2024-10-04 更新2024-10-05 收录

下载链接:

https://hf.co/spaces/kellycyy/CulturalBench

下载链接

链接失效反馈资源简介:

CULTURALBENCH是由华盛顿大学开发的用于评估大型语言模型(LLMs)文化知识的数据集。该数据集包含1227个高质量的人工编写和验证的问题,涵盖45个全球区域,包括孟加拉国、津巴布韦和秘鲁等代表性较弱的地区。问题涉及17个多样化的文化主题,如饮食偏好和问候礼仪。数据集的创建过程结合了AI辅助的红队测试和人工质量检查,确保了数据的多样性和挑战性。CULTURALBENCH旨在解决LLMs在跨文化知识评估中的不足,提供一个有效的基准来测试和改进模型的文化敏感性。

提供机构:

华盛顿大学

创建时间:

2024-10-04

AI搜集汇总

数据集介绍

构建方式

CULTURALBENCH的构建采用了AI辅助的红队数据收集和验证管道,确保了数据集的鲁棒性、多样性和挑战性。具体步骤包括:1) 通过AI辅助的红队数据收集,人类根据个人文化经验提供多样化的文化场景,AI助手将其转化为结构化问题;2) 人类质量检查,通过Prolific平台招募五名专家对每个问题进行验证;3) 基于多数投票的过滤,确保每个问题至少有四名专家达成一致意见。最终形成了包含1,227个高质量问题的数据集,涵盖45个全球区域和17个文化主题。

特点

CULTURALBENCH的特点在于其广泛的地域覆盖和主题多样性,包括南亚的孟加拉国、非洲的津巴布韦和南美的秘鲁等代表性地区。数据集中的问题类型分为单模式和多模式,分别对应单一正确答案和多个正确答案的情况,确保了模型在处理文化多样性时的全面性。此外,数据集通过严格的多数投票机制确保了问题的准确性和文化代表性。

使用方法

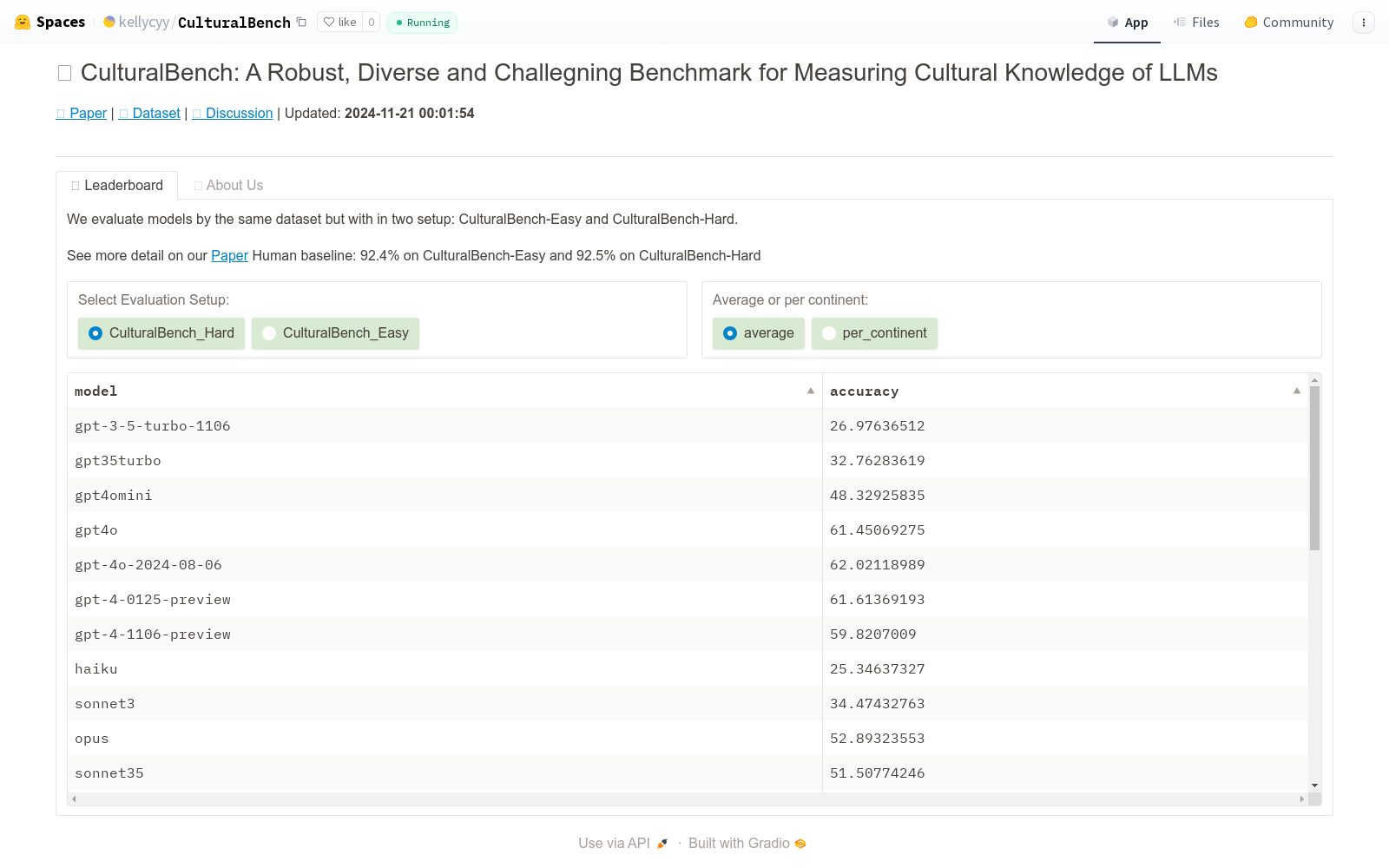

CULTURALBENCH提供了两种评估设置:CULTURALBENCH-Easy和CULTURALBENCH-Hard。CULTURALBENCH-Easy采用多项选择题形式,要求模型从四个选项中选择一个正确答案;CULTURALBENCH-Hard则将多项选择题转换为二元问题,要求模型对每个选项进行真假判断。通过这两种设置,研究者可以全面评估模型在不同文化知识测试中的表现,特别是在处理复杂和多答案问题时的能力。

背景与挑战

背景概述

CULTURALBENCH数据集由华盛顿大学和艾伦人工智能研究所的研究人员于近期创建,旨在评估大型语言模型(LLMs)在跨文化知识方面的表现。该数据集包含1,227个人类编写和验证的问题,涵盖45个全球区域,特别是包括了如孟加拉国、津巴布韦和秘鲁等代表性不足的地区。这些问题跨越17个多样化的主题,从饮食偏好到问候礼仪,旨在全面评估LLMs的文化知识。CULTURALBENCH的推出填补了现有文化知识基准的空白,为推动LLMs在多元文化环境中的应用提供了重要工具。

当前挑战

CULTURALBENCH数据集面临的挑战主要包括两个方面:首先,构建过程中需要确保问题的多样性和代表性,以覆盖全球不同文化和地区的细微差别,这要求高度的专业知识和广泛的文化背景。其次,评估LLMs在处理复杂文化问题时的表现,特别是那些具有多个正确答案的难题,揭示了模型在处理文化多样性方面的局限性。此外,数据集的验证过程依赖于少数专家的共识,这在某些文化区域可能存在样本不足的问题,影响了数据集的全面性和鲁棒性。

常用场景

经典使用场景

CULTURALBENCH 数据集的经典使用场景在于评估大型语言模型(LLMs)在跨文化知识方面的表现。通过提供1,227个由人类编写和验证的问题,覆盖45个全球区域,包括孟加拉国、津巴布韦和秘鲁等代表性不足的地区,该数据集能够有效评估LLMs在不同文化背景下的知识掌握情况。问题涵盖17个多样化的主题,从饮食偏好到问候礼仪,确保了评估的全面性和挑战性。

实际应用

在实际应用中,CULTURALBENCH 数据集可用于开发和优化面向全球用户的语言模型,特别是在需要高度文化敏感性的领域,如客户服务、跨文化交流和国际市场分析。通过使用该数据集进行模型训练和评估,企业可以确保其产品和服务在全球范围内更加适用和受欢迎,从而提升用户体验和市场竞争力。

衍生相关工作

CULTURALBENCH 数据集的推出激发了一系列相关研究和工作,特别是在跨文化语言模型评估和优化领域。例如,一些研究团队已经开始利用该数据集开发新的评估方法和模型训练策略,以提高LLMs在处理跨文化内容时的表现。此外,该数据集还促进了跨学科合作,吸引了语言学、计算机科学和社会学等领域的专家共同探讨和解决文化多样性在人工智能中的应用问题。

以上内容由AI搜集并总结生成