MovieSum|电影剧本摘要数据集|自然语言处理数据集

收藏MovieSum: An Abstractive Summarization Dataset for Movie Screenplays

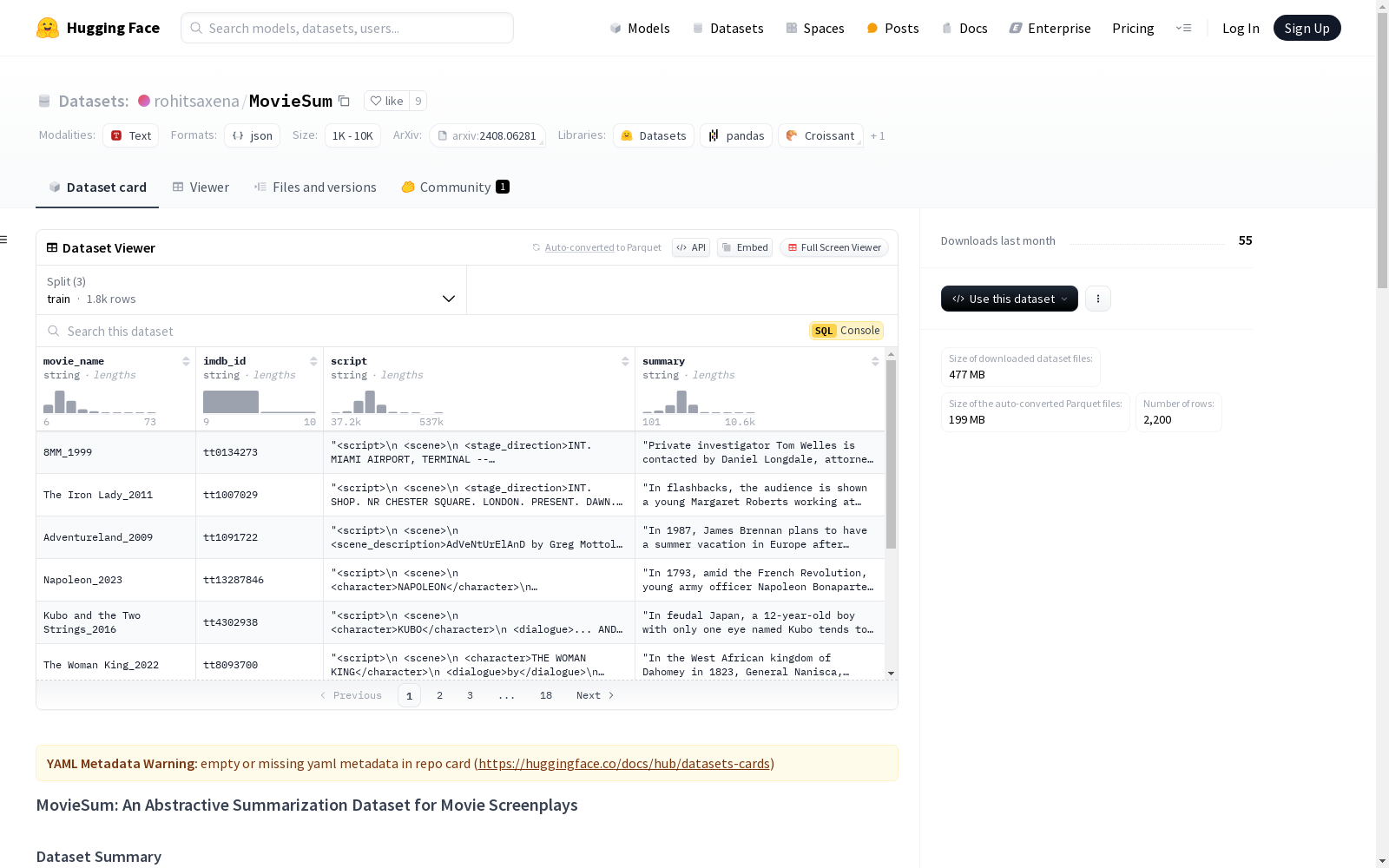

数据集概述

MovieSum 包含 2,200 部电影剧本及其对应的维基百科摘要。这是一个长篇摘要任务,电影剧本的平均长度约为 34,000 字。我们手动格式化了电影剧本,以表示其结构元素。我们还提供了每个电影的 IMDB ID,以便于收集额外的元数据。

数据集统计

| 总电影剧本数 | 2,200 |

| 平均剧本长度 | 34,275 |

| 平均摘要长度 | 793 |

每个电影剧本以 XML 格式提供,具有以下 DOM 结构:

xml <script> <scene> <stage_direction>..</stage_direction> <scene_description>...</scene_description> <character>..</character> <dialogue>..</dialogue> ... </scene> <scene> ... </scene> <script>

数据集结构

数据集分为三个部分:

- 训练集:1800 部电影剧本、摘要和 IMDB ID。

- 验证集:200 部电影剧本、摘要和 IMDB ID。

- 测试集:200 部电影剧本、摘要和 IMDB ID。

许可证

Creative Commons Attribution Non Commercial 4.0

引用

plaintext

@inproceedings{saxena-keller-2024-moviesum,

title = "MovieSum: An Abstractive Summarization Dataset for Movie Screenplays",

author = "Saxena, Rohit and

Keller, Frank",

booktitle = "Findings of the Association for Computational Linguistics: ACL 2024",

month = AUG,

year = "2024",

address = "Bangkok, Thailand",

publisher = "Association for Computational Linguistics",

}

@misc{saxena2024moviesumabstractivesummarizationdataset, title={MovieSum: An Abstractive Summarization Dataset for Movie Screenplays}, author={Rohit Saxena and Frank Keller}, year={2024}, eprint={2408.06281}, archivePrefix={arXiv}, primaryClass={cs.CL}, url={https://arxiv.org/abs/2408.06281}, }

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

中国1km分辨率逐月降水量数据集(1901-2023)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2023.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

中国行政区划数据

本项目为中国行政区划数据,包括省级、地级、县级、乡级和村级五级行政区划数据。数据来源于国家统计局,存储格式为sqlite3 db文件,支持直接使用数据库连接工具打开。

github 收录

猫狗图像数据集

该数据集包含猫和狗的图像,每类各12500张。训练集和测试集分别包含10000张和2500张图像,用于模型的训练和评估。

github 收录

Nexdata/chinese_dialect

该数据集包含25,000小时的中文方言语音数据,收集自多个方言区域的本地方言使用者,涵盖闽南语、粤语、四川话、河南话、东北话、上海话、维吾尔语和藏语等。数据格式为16kHz、16bit、未压缩的wav文件,单声道。句子准确率超过95%。数据集支持的任务包括自动语音识别(ASR)和音频说话人识别。

hugging_face 收录