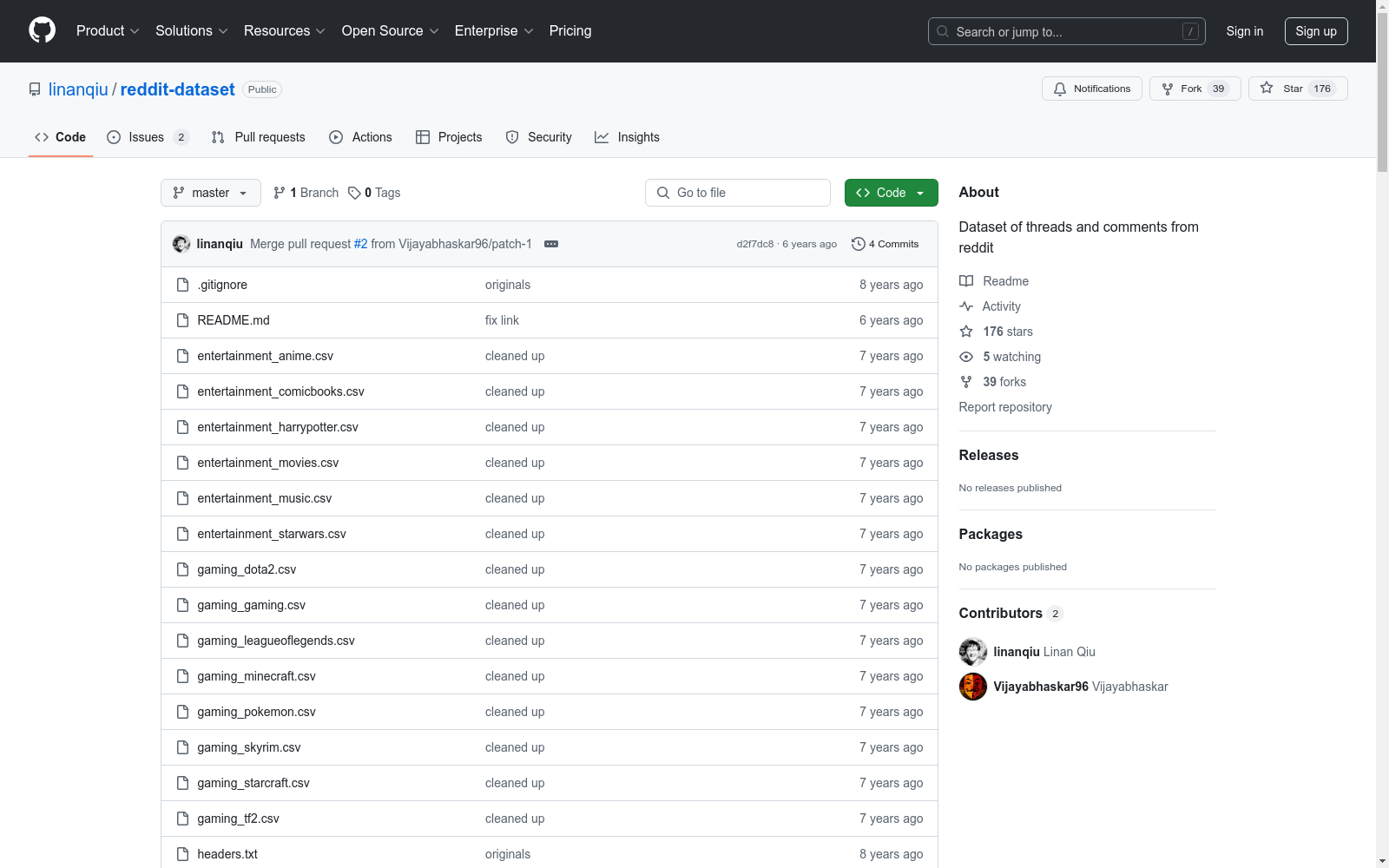

reddit-dataset|社交媒体数据数据集|NLP数据集

收藏数据集概述:Reddit Comment and Thread Datas

数据集描述

- 数据量: 约260,000条Reddit论坛的评论和帖子数据。

- 用途: 适用于自然语言处理(NLP)项目。

数据结构

通用字段

- text: 评论/帖子的文本内容。

- id: 评论/帖子的唯一标识符。

- subreddit: 评论/帖子所属的子论坛。

- meta: 评论/帖子所属的元论坛。

- time: 评论/帖子的UNIX时间戳。

- author: 评论/帖子的作者用户名。

- ups: 评论/帖子获得的支持票数。

- downs: 评论/帖子获得的反对票数。

- authorlinkkarma: 作者的链接积分。

- authorkarma: 作者的积分。

- authorisgold: 作者是否为黄金用户(1为是,0为否)。

帖子特定字段

- title: 帖子的标题。

- url: 帖子的URL。

- authorcommentkarma: 作者的评论积分。

评论特定字段

- authorcommentkarma: 作者的评论积分。

数据文件

- threads.csv: 包含帖子数据,文件格式为

<metareddit>_<subreddit>.csv。 - comments.csv: 包含评论数据,文件格式为

<metareddit>_<subreddit>.csv。

数据处理

- 所有文本已转换为小写,并使用TreebankTokenizer进行分词,然后以空格连接,使得标点符号与单词分离。

Beijing Traffic

The Beijing Traffic Dataset collects traffic speeds at 5-minute granularity for 3126 roadway segments in Beijing between 2022/05/12 and 2022/07/25.

Papers with Code 收录

BANTH

BANTH数据集是由Penta Global Limited和Islamic University of Technology合作创建的,专门用于检测和分类转写孟加拉语中的仇恨言论。该数据集包含37,350条样本,主要来源于YouTube评论,涵盖新闻与政治、人物与博客、娱乐等多个类别。数据集的创建过程包括数据抓取、过滤、清洗和多轮人工标注与验证,确保了数据的高质量和准确性。BANTH数据集的应用领域主要集中在多标签仇恨言论检测,旨在解决低资源语言中仇恨言论自动检测的挑战,并为未来的跨语言和多标签分类研究奠定基础。

arXiv 收录

光伏电站发电量预估数据

1、准确预测一个地区分布式光伏场站的整体输出功率,可以提高电网的稳定性,增加电网消纳光电能量的能力,在降低能源消耗成本的同时促进低碳能源发展,实现动态供需状态预测的方法,为绿色电力源网荷储的应用落地提供支持。 2、准确预估光伏电站发电量,可以自动发现一些有故障的设备或者低效电站,提升发电效能。1、逆变器及电站数据采集,将逆变器中计算累计发电量数据,告警数据同步到Maxcompute大数据平台 2、天气数据采集, 通过API获取ERA5气象数据包括光照辐射、云量、温度、湿度等 3、数据特征构建, 在大数据处理平台进行数据预处理,用累计发电量矫正小时平均发电功率,剔除异常数据、归一化。告警次数等指标计算 4、异常数据处理, 天气、设备数据根据经纬度信息进行融合, 并对融合后的数据进行二次预处理操作,剔除辐照度和发电异常的一些数据 5、算法模型训练,基于XGBoost算法模型对历史数据进行训练, 生成训练集并保存至OSS 6、算法模型预测,基于XGBoost算法模型接入OSS训练集对增量数据进行预测, 并评估预测准确率等效果数据,其中误差率=(发电量-预估发电量)/发电量,当误差率低于一定阈值时,该数据预测为准确。预测准确率=预测准确数量/预测数据总量。

浙江省数据知识产权登记平台 收录

AgiBot World

为了进一步推动通用具身智能领域研究进展,让高质量机器人数据触手可及,作为上海模塑申城语料普惠计划中的一份子,智元机器人携手上海人工智能实验室、国家地方共建人形机器人创新中心以及上海库帕思,重磅发布全球首个基于全域真实场景、全能硬件平台、全程质量把控的百万真机数据集开源项目 AgiBot World。这一里程碑式的开源项目,旨在构建国际领先的开源技术底座,标志着具身智能领域 「ImageNet 时刻」已到来。AgiBot World 是全球首个基于全域真实场景、全能硬件平台、全程质量把控的大规模机器人数据集。相比于 Google 开源的 Open X-Embodiment 数据集,AgiBot World 的长程数据规模高出 10 倍,场景范围覆盖面扩大 100 倍,数据质量从实验室级上升到工业级标准。AgiBot World 数据集收录了八十余种日常生活中的多样化技能,从抓取、放置、推、拉等基础操作,到搅拌、折叠、熨烫等精细长程、双臂协同复杂交互,几乎涵盖了日常生活所需的绝大多数动作需求。

github 收录

Traditional-Chinese-Medicine-Dataset-SFT

该数据集是一个高质量的中医数据集,主要由非网络来源的内部数据构成,包含约1GB的中医各个领域临床案例、名家典籍、医学百科、名词解释等优质内容。数据集99%为简体中文内容,质量优异,信息密度可观。数据集适用于预训练或继续预训练用途,未来将继续发布针对SFT/IFT的多轮对话和问答数据集。数据集可以独立使用,但建议先使用配套的预训练数据集对模型进行继续预训练后,再使用该数据集进行进一步的指令微调。数据集还包含一定比例的中文常识、中文多轮对话数据以及古文/文言文<->现代文翻译数据,以避免灾难性遗忘并加强模型表现。

huggingface 收录