OmniCorpus - 最大开源图文交错数据集|多模态数据集数据集|人工智能研究数据集

收藏github2024-06-13 更新2024-06-14 收录

下载链接:

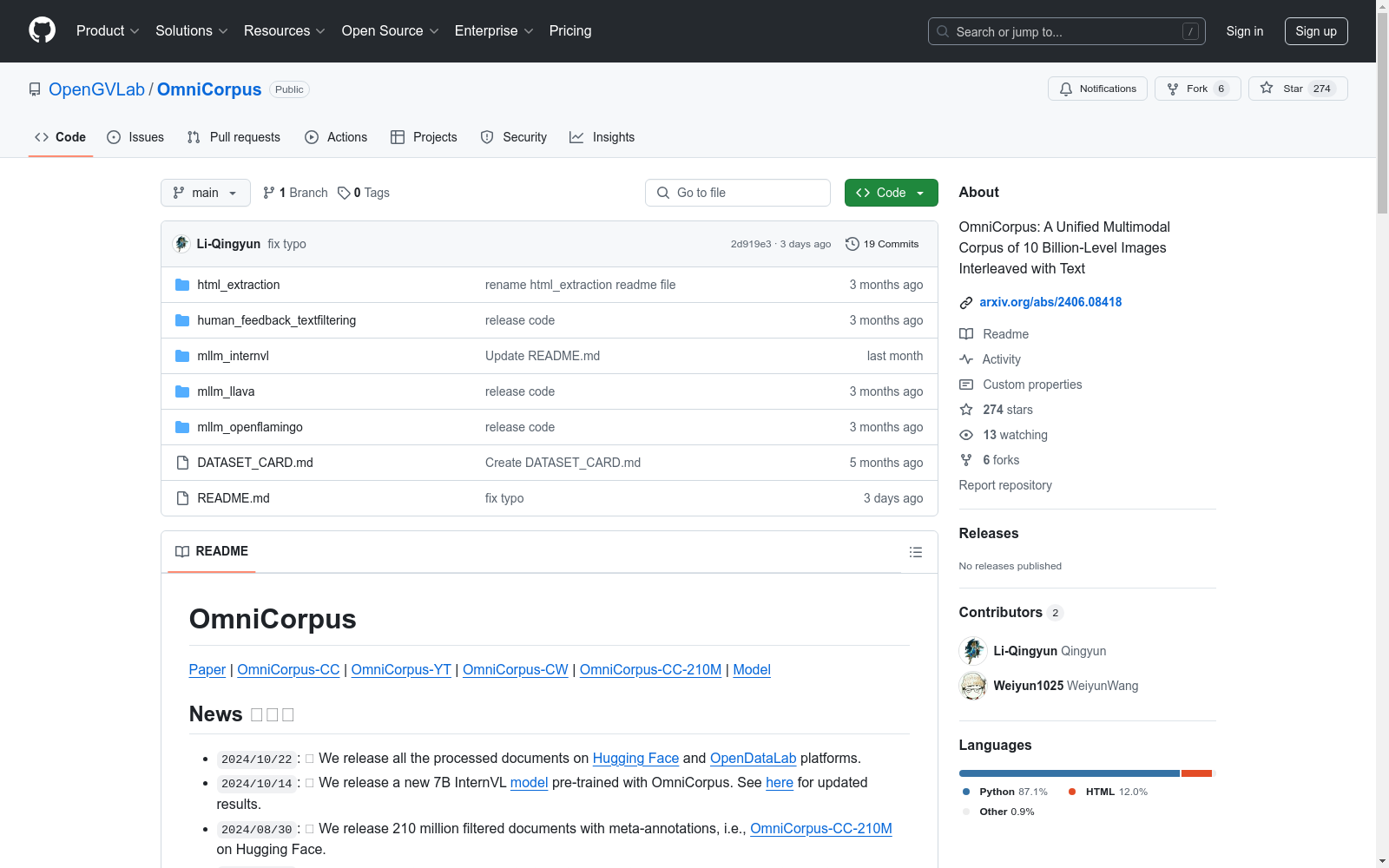

https://github.com/OpenGVLab/OmniCorpus

下载链接

链接失效反馈资源简介:

OmniCorpus由上海人工智能实验室联合多所知名高校及研究机构共同构建,是迄今为止最大的多模态数据集。该数据集包含了86亿张图像和1696亿个文本Token,支持中英双语。与现有的数据集相比,其在以下方面具有显著优势:1)更大的数据规模:与之前最大的多模态数据集LAION-5B相比,OmniCorpus的数据集在图像方面大了1.7倍,在文本方面大了12.5倍,同时保持了出色的数据质量。2)更丰富的数据多样性:从更广泛的数据源中提取数据,OmniCorpus数据集比其他图像-文本交错数据集更具多样性。它包括中英文双语多模态数据,并包括从常见网站和视频平台提取的以文本为中心和以视觉为中心的文档。3)更灵活的格式:OmniCorpus的流式数据格式提供了非凡的灵活性,允许适应各种数据结构,包括纯文本语料库、图像-文本对和交错数据格式。数据集制作pipeline由五个关键阶段组成:主体提取、初步文本过滤、文档重复数据消除、图像下载和过滤以及详细文本过滤。每个阶段都有效地减少数据集,只保留高质量的数据。OmniCorpus的多语言特性和高质量数据为多模态机器学习模型提供了丰富的训练资源,推动了人工智能领域的研究进展。

OmniCorpus, jointly constructed by the Shanghai Artificial Intelligence Laboratory and several renowned universities and research institutions, stands as the largest multimodal dataset to date. This dataset encompasses 8.6 billion images and 169.6 billion text tokens, supporting both Chinese and English languages. Compared to existing datasets, OmniCorpus exhibits significant advantages in the following aspects: 1) Larger data scale: Compared to the previously largest multimodal dataset, LAION-5B, OmniCorpus is 1.7 times larger in terms of images and 12.5 times larger in terms of text, while maintaining excellent data quality. 2) Richer data diversity: By extracting data from a broader range of sources, OmniCorpus offers greater diversity than other image-text interleaved datasets. It includes bilingual multimodal data in Chinese and English, incorporating both text-centric and vision-centric documents sourced from common websites and video platforms. 3) More flexible format: The streaming data format of OmniCorpus provides exceptional flexibility, allowing adaptation to various data structures, including plain text corpora, image-text pairs, and interleaved data formats. The dataset creation pipeline consists of five key stages: entity extraction, preliminary text filtering, document deduplication, image downloading and filtering, and detailed text filtering. Each stage effectively reduces the dataset, retaining only high-quality data. The multilingual features and high-quality data of OmniCorpus provide rich training resources for multimodal machine learning models, advancing research in the field of artificial intelligence.

提供机构:

上海人工智能实验室、哈尔滨工业大学、南京大学、复旦大学等

创建时间:

2024-06-12

原始信息汇总

数据集概述

数据集名称

OmniCorpus

数据集规模

- 包含8.6亿张图像

- 1,696亿文本令牌

- 2.2亿文档

数据集特点

- 数据规模:比之前的最大多模态数据集LAION-5B大1.7倍图像量和12.5倍文本量。

- 数据多样性:涵盖更广泛的数据源,包括中英文双语多模态数据,以及从常见网站和视频平台提取的文本中心和视觉中心文档。

- 数据格式灵活性:采用流式数据格式,适应多种数据结构,如纯文本语料库、图像-文本对和交错数据格式。

数据处理流程

- 主要包含五个阶段:主体提取、初步文本过滤、文档去重、图像下载与过滤、详细文本过滤。

实验结果

- 使用OmniCorpus训练的模型在学术字幕和VQA基准测试中表现优异。

数据集发布计划

- 计划发布多个子集:OmniCorpus-YT、OmniCorpus-CC-600M、OmniCorpus-CC-200M、OmniCorpus-CC-8M。

AI搜集汇总

数据集介绍

构建方式

OmniCorpus数据集的构建过程经过精心设计,涵盖了五个关键阶段:主体提取、初步文本过滤、文档去重、图像下载与过滤以及详细文本过滤。每个阶段都旨在确保数据的高质量和多样性。通过从Common Crawl、中国互联网资源和YouTube视频中提取数据,OmniCorpus成功整合了86亿张图像和1696亿个文本标记,形成了目前最大的多模态数据集。

特点

OmniCorpus数据集以其庞大的规模和丰富的多样性著称。相较于之前的最大多模态数据集LAION-5B,OmniCorpus在图像数量上增加了1.7倍,在文本数量上增加了12.5倍,同时保持了卓越的数据质量。此外,该数据集不仅包含中英文双语的多模态数据,还涵盖了从常见网站和视频平台提取的文本中心和视觉中心文档,提供了极高的灵活性。

使用方法

OmniCorpus数据集适用于多种应用场景,特别推荐用于多模态大语言模型的预训练。其图像与文本交错的数据格式有助于多模态上下文学习和大型语言模型在多模态微调中的能力保持。此外,数据集还提供了基于CLIP计算的图像与文本相似度,可用于长文本图像检索,支持多模态检索增强生成和纯文本到多模态样本的转换。

背景与挑战

背景概述

OmniCorpus,作为迄今为止最大的多模态数据集,于2024年6月13日由OpenGVLab团队推出,标志着多模态数据集领域的一次重大飞跃。该数据集包含了86亿张图像和1.696万亿个文本标记,涵盖了从2013年至2023年11月/12月的Common Crawl数据、中文互联网资源以及YouTube视频帧和字幕。OmniCorpus不仅在数据规模上超越了以往的数据集,如LAION-5B,还在数据多样性和灵活性上展现出显著优势。其核心研究问题在于如何通过大规模、多样化的图文交错数据,提升多模态大语言模型(MLLM)的预训练效果,进而推动多模态学习的发展。

当前挑战

OmniCorpus在构建过程中面临多项挑战。首先,数据来源的多样性带来了数据质量控制的难题,需通过多阶段的数据处理流程,包括主体提取、初步文本过滤、文档去重、图像下载与过滤以及详细文本过滤,以确保数据的高质量。其次,数据规模的巨大使得存储和处理成本显著增加,对计算资源和存储技术提出了高要求。此外,如何有效利用这些大规模数据进行多模态模型的预训练,以实现高效的模型性能提升,也是当前研究的重要挑战。最后,数据集的多样性要求开发新的数据处理和模型训练策略,以适应不同类型的数据格式和应用场景。

常用场景

经典使用场景

在多模态学习领域,OmniCorpus数据集的经典应用场景主要集中在多模态大语言模型(MLLM)的预训练。通过利用OmniCorpus中丰富的图像与文本交错数据,研究人员能够显著提升模型的多模态上下文学习能力,同时保持大语言模型在多模态微调中的核心能力。此外,该数据集还支持长文本图像检索任务,通过提供基于CLIP计算的图像文本相似度,使得模型能够基于更长的文本来检索图像,从而应用于多模态检索增强生成(RAG)等场景。

衍生相关工作

基于OmniCorpus数据集,一系列相关研究工作得以展开。例如,研究人员开发了基于该数据集的多模态大语言模型,如InternVL系列模型,这些模型在多模态任务中表现优异。此外,OmniCorpus还启发了多模态数据筛选和处理策略的研究,推动了数据处理工具和方法的创新。这些衍生工作不仅丰富了多模态学习的理论基础,也为实际应用提供了强有力的技术支持。

数据集最近研究

最新研究方向

在多模态数据处理领域,OmniCorpus数据集的最新研究方向主要集中在利用其庞大的规模和丰富的多样性来推动多模态大语言模型(MLLM)的预训练。通过整合8.6亿张图像和1.696万亿文本标记,OmniCorpus不仅在数据量上超越了现有的多模态数据集,如LAION-5B,还在数据多样性上有所突破,涵盖了中英文双语的多模态数据。这一特性使得OmniCorpus成为研究多模态上下文学习和多模态微调的理想平台。此外,OmniCorpus还支持长文本图像检索和数据集研究,为数据筛选策略和成本降低提供了新的可能性。

以上内容由AI搜集并总结生成