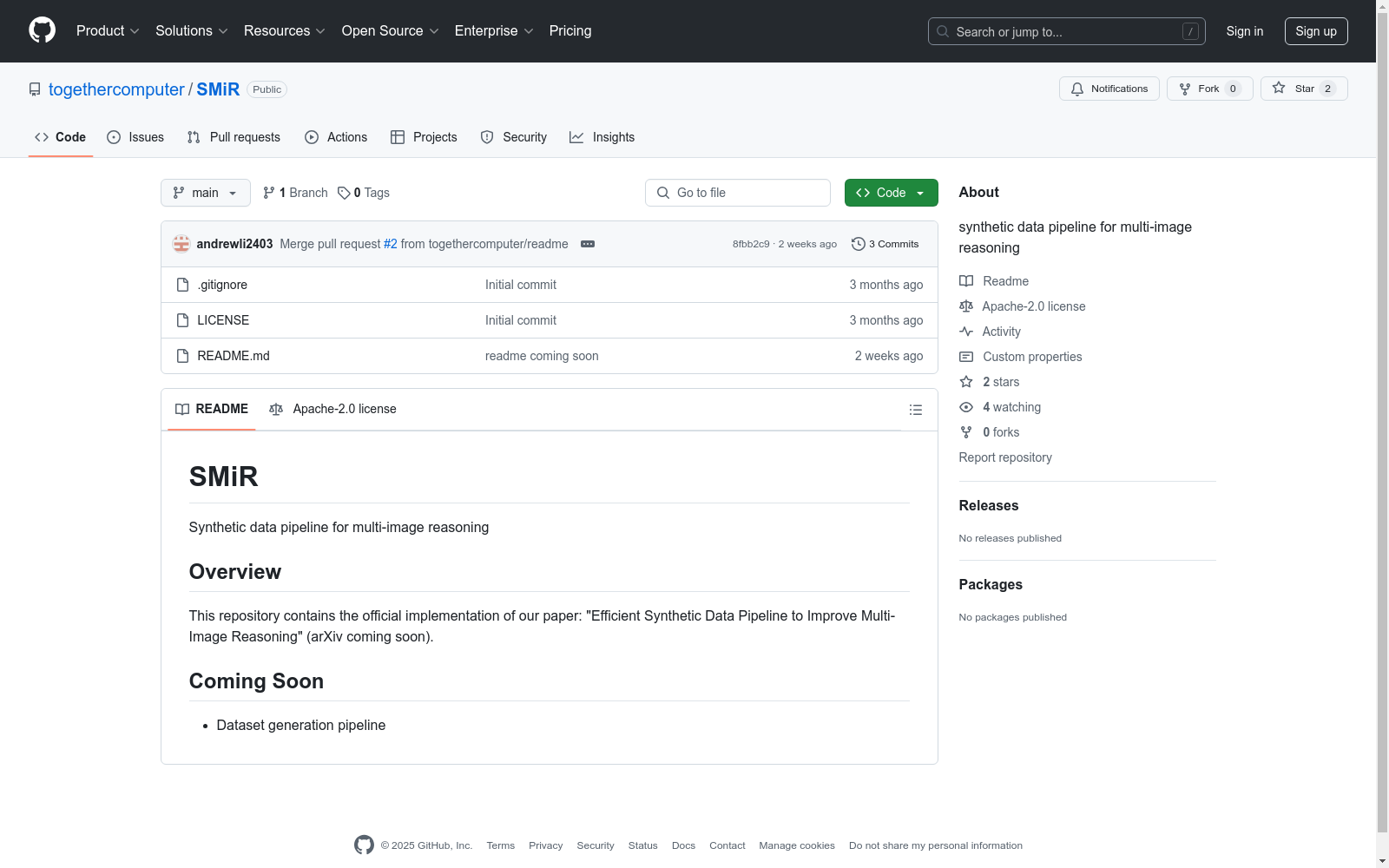

SMIR|多图像推理数据集|多模态嵌入数据集

收藏

日食计算器

此日食计算器能够查询公元前3000至后3000年范围内的日食信息,生成每次日食的覆盖区、中心区范围数据,展示日食带的地图;并可根据用户在地图上点击的坐标在线计算该地日食各阶段时间、食分等观测信息。

国家天文科学数据中心 收录

flames-and-smoke-datasets

该仓库总结了多个公开的火焰和烟雾数据集,包括DFS、D-Fire dataset、FASDD、FLAME、BoWFire、VisiFire、fire-smoke-detect-yolov4、Forest Fire等数据集。每个数据集都有详细的描述,包括数据来源、图像数量、标注信息等。

github 收录

China Family Panel Studies (CFPS)

Please visit CFPS official data platform to download the newest data, WeChat official account of CFPS: ISSS_CFPS. The CFPS 2010 baseline survey conducted face-to-face interviews with the sampled households’ family members who live in the sample communities. It also interviewed those family members who were elsewhere in the same county. For those who were not present at home at the time of interview, basic information was collected from their family members at presence. All family members who had blood/marital/adoptive ties with the household were identified as permanent respondents. Prospective family members including new-borns and adopted children.

DataCite Commons 收录

Breast Cancer Dataset

该项目专注于清理和转换一个乳腺癌数据集,该数据集最初由卢布尔雅那大学医学中心肿瘤研究所获得。目标是通过应用各种数据转换技术(如分类、编码和二值化)来创建一个可以由数据科学团队用于未来分析的精炼数据集。

github 收录

Photovoltaic power plant data

包括经纬度、电源板模型、NWP等信息。

github 收录